Data / IA

Mistral Large 2, Meta LLama 3.1 : Les LLM « frontières » font de la résistance

Par Laurent Delattre, publié le 26 juillet 2024

Alors que l’on parle beaucoup du rôle croissant des petits modèles génératifs en entreprise, les très grands modèles continuent de repousser les frontières de l’IA en matière de raisonnement, de compétences et de capacités d’analyse. Cette semaine, Mistral et Meta ont chacun annoncé deux LLM à plus de 100 milliards de paramètres… Grâce à eux, l’IA en open source refait son retard…

L’année 2024 marque un tournant en faveur des petits modèles génératifs, les SLM (Small Language Models) dans les grandes tendances autour de l’IA ouvrant l’accès à des inférences en local, embarquées ou dans l’Edge, que ce soit au sein des datacenters pour un plus grand contrôle de l’utilisation des données, au sein de solutions clés en main comme Nutanix GPT-In-A-Box ou au sein des nouveaux « Copilot+ PC » et leur NPU intégré.

Le début d’année a ainsi été marqué par l’arrivée de petits modèles très spécialisés et extrêmement doués comme RedPajama 3B, Mistral Mathstral ou Mistral Codestral Mamba mais aussi de petits modèles plus généralistes mais étonnamment capables comme Microsoft Phi-3, Google Gemma 2, Mistral NeMo, LLama 3 8B, Claude Haiku, et dernièrement GPT-4o mini.

Pour autant le succès rencontré par ces SLM ne doit pas masquer les progrès également réalisés par les LLM dits « frontière » qui poussent les capacités informatiques au maximum de ce qu’il est aujourd’hui possible de délivrer. Ainsi, on a vu progresser de façon assez spectaculaire des modèles comme GPT-4 avec l’itération « GPT-4o » dont le potentiel n’est pas encore totalement accessible au public ou encore des modèles comme « Claude AI » avec un « Claude 3.5 Sonnet » très impressionnant dans sa capacité à manier la langue française et à analyser de longs documents.

Cette semaine, deux autres acteurs sont venus bousculer l’univers des LLM frontières. Le premier n’est autre que Meta avec le plus grand LLM open source à ce jour, Llama 3.1 405B. Le second est le français Mistral AI dont le dynamisme lui permet de continuer à coller aux basques de l’innovation américaine sans se faire distancer : son Mistral Large 2 bouscule le marché par ses performances et sa pertinence.

Llama 3.1, l’IA open source sort les griffes

Llama de Meta est la référence des modèles LLM open source. Il est au cœur de tous les benchmarks et de toutes les comparaisons d’IA du marché. Il est surtout systématiquement implémenté par toutes les plateformes IA du marché et tous les services MaaS (Model as a Service) du cloud. On le retrouve bien évidemment sur le service Hugging Face ainsi que sur Azure AI, Google Vertex AI, AWS Bedrock, mais aussi sur Nutanix GPT-In-a-Box, NVidia NIM, OVHcloud AI Endpoints, etc.

Bref, Llama est devenu un modèle LLM incontournable de l’IA générative et un atout pour toutes les entreprises qui cherchent à exécuter, fine-tuner et adapter des modèles LLM dans leurs datacenters.

En avril, Meta avait introduit Llama 3, avec des versions 8B et 70B, mais également promis une version 400B qui ne s’est jamais concrétisée. Un manque désormais comblé avec le lancement de Llama 3.1 toujours décliné en versions 8B et 70B (8 milliards et 70 milliards de paramètres) mais aussi et surtout en version « 405B », soit 405 milliards de paramètres ! Meta a d’ailleurs été obligé de mobiliser plus de 16.000 GPU NVidia H100 pour l’entraîner !

Dit autrement, LLama 3.1 « 405B » est le plus vaste modèle LLM en open source. Et sa taille rivalise avec celle d’un GPT 3.5 par exemple. Sauf qu’il est bien plus optimisé que ce dernier. Selon Meta, Llama 3.1 405B est le premier modèle AI open source de type « frontier-level » et un modèle « unique en son genre avec une flexibilité inégalée, un contrôle et des capacités de pointe ».

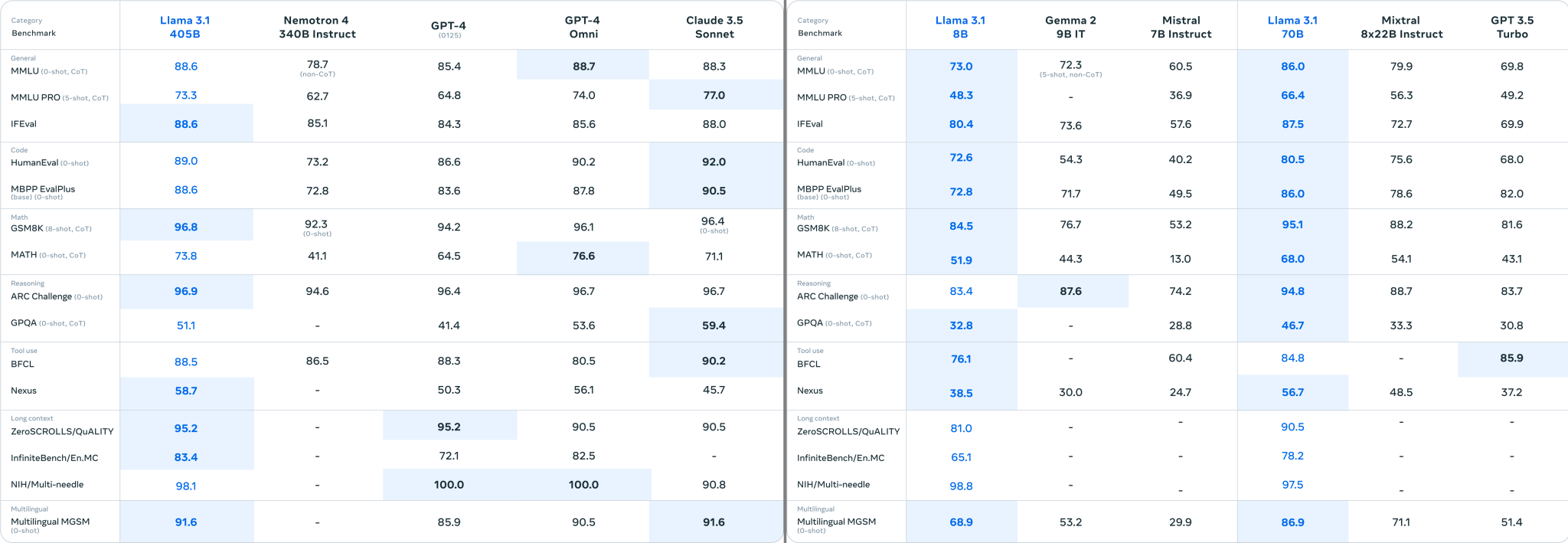

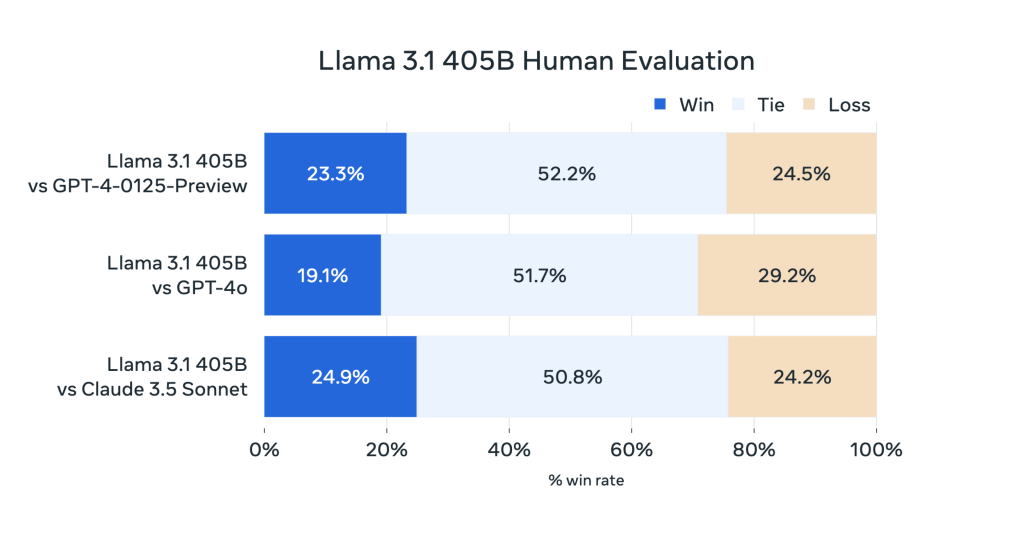

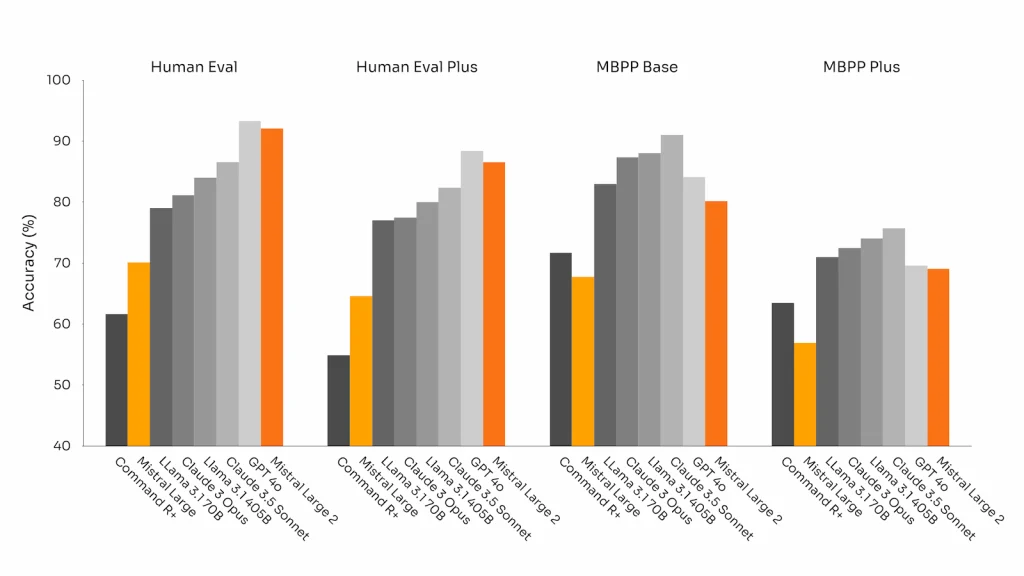

Supportant 8 langues humaines (dont le Français) et entraîné sur une base d’information de 15.000 milliards de tokens, Llama 3.1 « 405B » rivalise avec les meilleurs LLM du marché, surpassant même GPT-4o et Claude 3.5 Sonnet sur plusieurs des benchmarks usuels de l’IA. Toutefois, contrairement à ces derniers, Llama 3.1 reste un pur LLM textuel là où les autres sont multimodaux et peuvent analyser images et autres contenus multimédias. Au passage, on notera que les versions 8B et 70B de LLama 3.1 montrent également des progrès significatifs, notamment en raisonnement mathématique et en génération de code informatique. Autre amélioration fondamentale, Llama 3.1 étend désormais la fenêtre contextuelle à 128 000 tokens (ce qui représente environ un roman de 300 pages).

Par ailleurs, afin de permettre aux entreprises de développer des IA responsables basées sur Llama 3.1, Meta publie parallèlement et toujours en open source un système de référence complet qui comprend des exemples pratiques mais surtout de nouveaux composants de contrôle comme Llama Guard 3 (un modèle de sécurité multilingue pour protéger les usages de l’IA) et Prompt Guard (un filtre d’injection de prompts).

Mistral Large 2, l’état de l’art européen

En réponse aux annonces de Meta, Mistral AI a également dévoilé cette semaine son nouveau LLM Frontière. Dénommé « Mistral Large 2 », ce LLM est disponible sous forme commerciale et sous forme ouverte mais limitée aux usages de recherche IA non commerciaux. Mistral Large 2 est composé de 123 milliards de paramètres, ce qui en fait le plus large modèle Européen.

Les modèles de Mistral AI sont réputés pour leur efficience et des résultats pertinents malgré des tailles plus petites. Et Mistral Large 2 ne déroge pas à la règle.

Pour rappel, Mistral avait annoncé en février dernier ses premiers modèles commerciaux, Mistral Small et Mistral Large. Depuis, la startup française a lancé bien d’autres IA, dont les modèles génératifs de code Codestral 22B et Codestral Mamba, ainsi qu’un modèle de langage très optimisé, Mistral NeMo.

Cette semaine, Mistral AI a donc lancé Mistral Large 2, nouvelle version de son LLM « Large ». Ce modèle s’appuie sur 123 milliards de paramètres, un nombre élevé mais qui lui permet néanmoins de s’exécuter sur un seul nœud NVidia H100, offrant ainsi des réponses très rapides avec une efficacité et une pertinence maximales. Il supporte de nombreuses langues humaines et plus de 80 langages de programmation, avec une fenêtre contextuelle de 128 000 tokens.

Mistral Large 2 est comparable en performance à LLama 3.1 405B, Claude 3.5 Sonnet et GPT-4o, et est particulièrement performant en français. Il excelle dans le suivi d’instructions précises et la gestion de longues discussions. Le modèle est conçu pour minimiser les hallucinations mais aussi reconnaître ses limites (en avouant son incapacité à pouvoir répondre de façon pertinente lorsqu’il ne dispose pas des informations suffisantes). Mistral Large 2 est également compétent en appels de fonctions et récupération de données, avec des appels de fonctions parallèles et séquentiels.

Le modèle est accessible via l’interface conversationnelle « Le Chat » de Mistral AI, sa plateforme MaaS « La Plateforme », ainsi que sur Azure AI, Google Vertex AI, AWS Bedrock et IBM watsonx.

Vous l’aurez compris, en 2024, l’innovation IA reste toujours aussi intense et dynamique, avec des progrès sensibles et réguliers mais aussi davantage de choix de scénarios pour les entreprises. Le prochain grand événement dans les modèles “frontières” devraient être l’arrivée de GPT-5 annoncé d’ici la fin de l’année.

OpenAI se lance dans la recherche Web

La rumeur courrait depuis des mois : OpenAI serait sur le point de divulguer un nouveau moteur de recherche Web basé sur ses technologies IA. Cette semaine, la startup a présenté SearchGPT, un prototype de moteur de recherche Web qui sera d’abord expérimenté auprès de 10.000 utilisateurs et qui sera peut-être un jour intégré à ChatGPT. OpenAI a ainsi ouvert une liste d’attente où peuvent s’inscrire les internautes qui veulent tester ce prototype.

Ce nouveau moteur de recherche Web adopte une approche conversationnelle pour vous aider à retrouver les informations recherchées. Plutôt que de livrer directement des liens à consulter, il cherche à réorganiser les liens grâce à l’IA et génère de résumés des sites Web pertinents. En outre, il suggère également d’autres questions pour vous aider à mieux cerner l’information recherchée.

OpenAI affirme que son expérience de recherche a été conçue en partenariat avec des éditeurs de contenus Web et s’appuie sur leurs retours. Par ailleurs, la startup veut leur proposer différents contrôles sur comment les résultats apparaissent dans SearchGPT et propose des réglages qui permettent à un éditeur d’interdire l’usage de ses contenus pour entraîner les modèles d’OpenAI tout en apparaissant néanmoins dans les résultats de recherche de SearchGPT. Reste à voir si OpenAI peut vraiment s’affirmer en concurrent de Google Search mais aussi de son principal investisseur Microsoft avec Bing.

À LIRE AUSSI :

À LIRE AUSSI :