Newtech

Eviden joue la partition du quantique en écosystème

Par Pierre Landry, publié le 19 juin 2023

Alors qu’IBM évoque des systèmes à 100000 qubits pour 2033 (et des réalisations logicielles vraiment marquantes d’ici deux ans), Eviden, l’entité d’Atos regroupant ses activités cloud, big data, sécurité et digital, lance une offre quantique à large vocation sectorielle s’appuyant sur du conseil, son système d’émulation QLM, et un écosystème de partenaires logiciels et matériels.

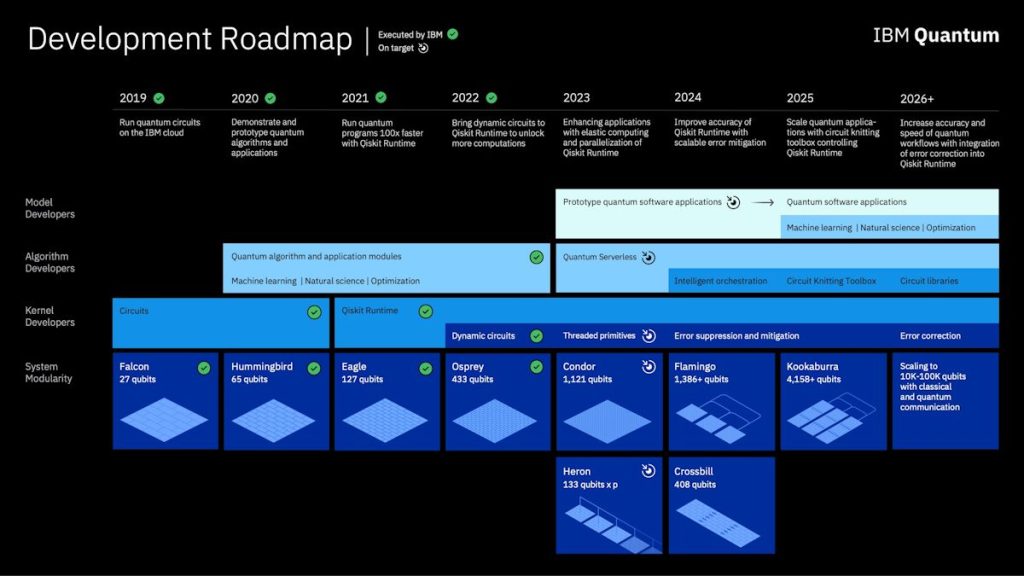

Principalement sous l’impulsion d’IBM, l’émergence d’ordinateurs quantiques généralistes à grande échelle se rapproche. Le constructeur estime en effet pouvoir réaliser, d’ici dix ans, un système à 100.000 qubits avec l’aide de l’Université de Chicago (pour la partie communication quantique) et l’Université de Tokyo, via le laboratoire commun IBM-UTokyo Lab. Ces 100.000 qubits seront atteints par l’interconnexion de quatre sous-systèmes de 25.000 qubits, eux-mêmes atteints grâce à des infrastructures multiprocesseurs. Des interconnexions et architectures qu’IBM a intégré dans sa Roadmap : les principes d’interconnexions doivent être expérimentés dès la fin de cette année avec le système Heron 133 qubits, et les principes multiprocesseurs quantiques dès la fin 2024 avec Crossbill (système 408 qubits). Avec toujours comme objectif de de dépasser les 1000 qubits en 2023, les 4000 qubits en 2025 et les 10.000 qubits à l’horizon 2026-2028.

Pour le moment, Eagle, avec ses 127 qubits, est le processeur quantique utilisable d’IBM le plus avancé. Pour mémoire, IBM a annoncé à la fin de l’an dernier l’Osprey 433 qubits, mais la machine est encore en phase de réglage et fiabilisation.

Les machines Eagle sont désormais accessibles via le Cloud IBM. Pour leur soumettre des workloads, pas d’autre solution que d’adhérer au Premium Plan d’IBM, assorti de l’offre de services Quantum Accelerator qui accompagnera l’entreprise dans sa montée en compétences et la réalisation de ses cas d’usage. Mais IBM vient d’annoncer que l’accès à ces machines va être élargi. Ainsi, fin mai, les 2000 participants de l’IBM Quantum Spring Challenge ont pu accéder à ce processeur de plus de 100 qubits. Au cours de l’année prochaine, plusieurs modèles seront déployés aussi bien dans son cloud que sur des sites de partenaires.

Pour rappel, il est possible d’utiliser des systèmes cinq ou sept qubits gratuitement sur le service QaaS d’IBM, mais aussi des systèmes à 27 qubits pour 1,60$ la seconde (prix public du Pay-As-You-Go Plan). Idéal pour se faire la main sur des algorithmes quantiques en s’appuyant sur les conseils, uniquement techniques cette fois, de la communauté IBM Quantum Network.

Selon IBM, ses processeurs Eagles donnent désormais accès à une puissance de calcul suffisamment importante pour surpasser les méthodes classiques (autrement dit l’informatique classique) dans certaines applications et offrent des temps de cohérence améliorés ainsi que des taux d’erreur inférieurs à ceux des précédents systèmes quantiques d’IBM.

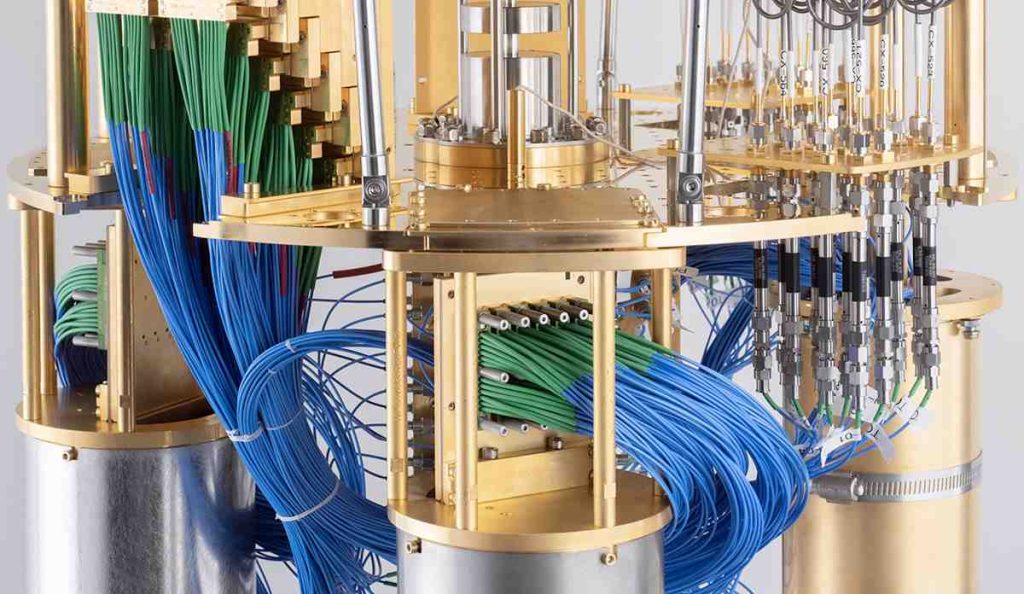

Au coeur de la machine quantique 127 qubits à processeur Eagle d’IBM

Ses chercheurs viennent d’ailleurs de publier dans Nature une expérience de calcul quantique démontrant qu’avec Eagle, les systèmes quantiques peuvent déjà se montrer supérieurs aux approches classiques et avoir des applications utiles. Ils ont réussi à simuler le comportement d’un matériau magnétique en s’appuyant sur de nouvelles techniques d’atténuation des erreurs. Ce calcul a ainsi mis en œuvre les 127 qubits de l’Eagle et 60 étapes de traitement (plus que toute autre expérimentation connue). L’expérience a été menée sur des circuits quantiques comportant jusqu’à 60 couches de portes à deux qubits, soit un total de 2 880 portes CNOT.

« C’est la première fois que nous voyons des ordinateurs quantiques modéliser avec précision un système physique de la nature, au-delà des principales approches classiques », a déclaré Darío Gil, vice-président principal et directeur d’IBM Research. « Pour nous, cette étape importante prouve que les ordinateurs quantiques d’aujourd’hui sont des outils scientifiques capables de modéliser des problèmes extrêmement difficiles – voire impossibles – pour les systèmes classiques, ce qui indique que nous entrons maintenant dans une nouvelle ère d’utilité pour l’informatique quantique ».

Utiliser la technologie adaptée au cas d’usage

Bien sûr, il est aujourd’hui possible d’explorer et d’exploiter d’autres technologies quantiques que celle d’IBM, qui s’appuie sur des qubits à base de supraconducteurs, et n’est pas forcément optimale pour tous les cas d’usage au niveau actuel de scalabilité et de performance des systèmes.

Résoudre un problème de façon quantique implique de concevoir un algorithme qui utilisera un certain nombre de portes selon la «largeur» du problème, qui aura besoin d’un temps de cohérence plus ou moins long des qubits selon la complexité du traitement, et qui supportera ou non un taux d’erreur selon la précision attendue.

Or, toutes les technologies quantiques ne sont pas égales en performances et en conditions d’opération. Dans sa QLM (Quantum Learning Machine), Atos a modélisé divers systèmes quantiques (à portes, adiabatiques, photoniques, etc.) afin d’en permettre la simulation sur un système classique. Il est alors possible de déterminer la technologie que devra utiliser le «coprocesseur quantique» optimal pour supporter le cas d’usage, de la même manière qu’on choisit une topologie de CPU ou de GPU pour certains calculs.

Un écosystème européen pour le moment

Une étape supplémentaire a été franchie avec l’offre Qaptiva que vient de lancer Eviden.

D’une part, Eviden a développé la couche d’orchestration qui, telle celle d’IBM au sein de Qiskit Runtime, permet de répartir au mieux les traitements et d’assurer l’ordonnancement des interactions entre système classique et système quantique.

D’autre part, la simulation de QPU peut désormais s’exécuter en partie sur un supercalculateur.

Last but not least, Qaptiva regroupe un écosystème de partenaires européens côté algorithmie (ColibrITD, QuantFI, QubitSoft, Qubit Pharmaceuticals, QuRisk et Multiverse Computing) comme côté matériel (IQM Quantum Computers, Quandela, Pasqal). Cela lui permet de cibler des cas d’usage dans divers secteurs d’activité (énergie, finances, sciences de la vie…) avec les technologies idoines (supraconducteurs, photons, atomes neutres), et avec une approche on-premise ou as a service selon les besoins du client :

« La QPU de Quandela est accessible depuis le cloud selon le pricing contracté par le client avec eux. On envoie le circuit, on récupère le résultat, c’est simple. Nous n’hébergerons les systèmes quantiques que si les clients le demandent », explique Cédric Bourrasset, directeur des activités HPC-AI et informatique quantique d’Eviden.

S’il est actuellement européen et très français, le casting a vocation à être élargi : « J’ai récemment rencontré la start-up australienne Quantum Brilliance dont la QPU se présente sous forme d’un serveur 6U qui opère à température ambiante. Cela donne des idées… », sourit-il.

Et verra-t-on un jour les offres d’IBM ou de D-Wave au catalogue ? Rien ne l’empêche techniquement, nous dit-on…

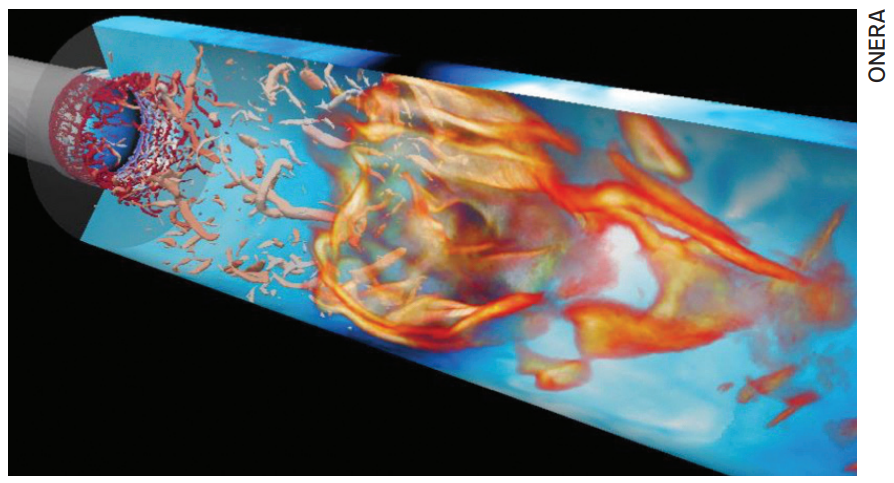

Réduire l’énergie nécessaire aux moteurs d’aéronefs

Après des travaux préparatoires avec Quandela, l’Onera va s’appuyer sur l’expertise algorithmique de ColibrITD pour développer un algorithme hybride résistant au bruit capable de résoudre les équations différentielles modélisant la flamme et donc la poussée d’un moteur. Sa simulation sur la QLM permettra de comparer cette approche hybride et l’approche purement HPC.