Data / IA

Comment activer Microsoft Copilot sans risque pour ses données

Par La rédaction, publié le 18 avril 2024

L’utilisation de Microsoft Copilot Pro expose les entreprises à des risques de sécurité des données, notamment par des fuites potentielles dues à un accès étendu et à une classification parfois inadéquate des informations sensibles. Pour contrer ces risques, que peut-on mettre en œuvre?

Par Farrah Gamboa, Senior Director of Product Management chez Netwrix

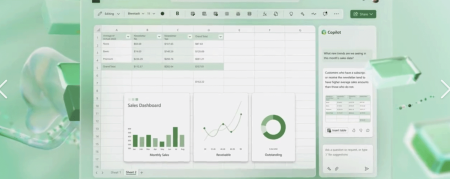

Début 2024, Microsoft a étendu l’accès à son IA avec Copilot Pro, un abonnement premium offrant des fonctionnalités avancées aux abonnés Microsoft 365 Personnel et Famille. Cet outil a été déployé en France fin 2023, et est désormais disponible sur iOS et Android, tandis que Copilot pour Microsoft 365 est ouvert aux entreprises de toutes tailles, des TPE aux grands groupes. Il peut améliorer les workflows en aidant les utilisateurs à rédiger des documents et des présentations, à identifier des points d’action dans les réunions Teams, analyser des données dans Excel et à effectuer bien d’autres tâches.

Cependant, l’usage de cet outil peut aussi introduire des risques en matière de sécurité des données. En effet, comme Copilot dispose des contrôles d’accès natifs de Microsoft 365, il peut afficher ou modifier les mêmes données que l’utilisateur, y compris ses documents, emails et notes. Il est donc essentiel de prendre certaines précautions avant tout déploiement dans une entreprise afin de s’assurer que les données sensibles resteront sous contrôle à l’avenir.

Comprendre les risques liés à Copilot

Afin d’adopter l’outil en toute sécurité, il existe trois principaux points de vigilance à garder à l’esprit. En effet, ces facteurs clés peuvent rendre son adoption risquée.

Tout d’abord, étant donné que Copilot dispose des permissions d’accès attribuées dans Microsoft 365, des informations sensibles peuvent rapidement échapper à tout contrôle. Cette problématique peut survenir dans l’hypothèse où des utilisateurs ou groupes sont autorisés à afficher ou modifier des contenus auxquels ils ne devraient pas avoir accès.

De plus, des données peuvent être mal classifiées car l’outil se base sur un système d’étiquettes indiquant les niveaux de confidentialité de celles-ci. Leur sécurité dépend donc de la bonne attribution des étiquettes. Malheureusement, cette classification est rarement complète et peut souffrir d’incohérences. L’étiquetage manuel est en effet sujet aux erreurs humaines et n’est pas adapté aux énormes volumes de contenus gérés par la plupart des entreprises. En outre, la technologie d’étiquetage de Microsoft se limite à certains types de fichiers.

Enfin, les documents générés par Copilot n’héritent pas des étiquettes indiquant les niveaux de confidentialité des documents sources. Par conséquent, de nouveaux documents contenant des données sensibles peuvent être partagés avec des utilisateurs non autorisés. Or, il peut être difficile de s’assurer que tous ces documents sont correctement classifiés en raison des volumes produits par l’outil.

À LIRE AUSSI :

Limiter le risque d’intrusions dans les projets Copilot

Dès lors, si ces risques ne sont pas pris en compte, Copilot peut exposer une entreprise à des fuites de données et à des amendes de non-conformité. Selon le dernier rapport Cost of Insider Risks du Ponemon Institute, le coût moyen des menaces internes est passé à 16,2 millions de dollars par entreprise en 2023, à 15,4 millions de dollars en 2022. Il est donc crucial de renforcer les systèmes de sécurité avant de déployer Copilot, mais aussi de mettre en place un solide programme de gouvernance de l’accès aux données pour bénéficier d’une protection durable. Ainsi, différentes pratiques permettent de lutter contre les trois types de risques associés à son adoption et à son utilisation.

Dans un premier temps, il est primordial de mettre en place et d’appliquer le principe du moindre privilège. Cette précaution permet de s’assurer que les utilisateurs disposent uniquement des autorisations requises pour effectuer leurs tâches, ce qui réduit considérablement le risque de fuite de données. Le processus doit permettre de passer facilement en revue les droits des différents propriétaires de données. Il doit aussi prévoir des workflows pour les demandes et approbations d’accès, ainsi qu’une visibilité sur les accès autorisés.

Cette première mesure sera renforcée grâce à la systématisation de la détection et de la classification des données. Cela permet d’améliorer la qualité de l’étiquetage pour les systèmes de stockage de données et les nouveaux contenus générés par Copilot. La mise en œuvre de contrôles de sécurité requis pour l’ensemble des contenus est ainsi largement facilitée. Par ailleurs, un étiquetage précis des données est essentiel pour établir une stratégie de prévention des pertes de données (DLP) efficace.

Automatiser la réaction aux menaces

Pour réduire efficacement les risques liés à la sécurité des données, il faut automatiser les processus de détection et de réaction aux menaces potentielles. Cela implique de reconnaître rapidement les facteurs de risque touchant les données cruciales et de mettre en place des mesures automatisées pour y répondre. Par exemple, les entreprises peuvent prévenir la compromission d’informations sensibles en révoquant automatiquement les autorisations inappropriées et en désactivant les comptes utilisateurs suspects. De plus, activer des alertes sur les menaces, qu’il s’agisse de tentatives de changement d’autorisation ou d’accès à des documents confidentiels, permet aux équipes de sécurité d’identifier rapidement les sources de danger et de prendre des mesures préventives pour éviter ou minimiser les dommages en cas d’intrusion.

Ainsi, en ce sens, Microsoft Copilot peut accroître la productivité ainsi que la création de contenu et les tâches administratives grâce à ses suggestions générées par l’IA. Cependant, afin de le déployer en toute sécurité, il est crucial pour les entreprises de mettre différentes pratiques de protection en place, tout en veillant à protéger les données sensibles et à être conscients de ses limites pour garantir l’intégrité et la sécurité du code produit.

À LIRE AUSSI :

À LIRE AUSSI :