Newtech

Avec Moshi, Kyutai passe avec succès le test de Turing

Par Thierry Derouet, publié le 05 juillet 2024

Comment en 6 mois avec 8 chercheurs et l’accès à 1000 GPU, la fondation dirigée par Patrick Perez a volé la politesse à OpenAI en mettant à disposition Moshi, un nouveau modèle de langage doté de capacités vocales étonnantes ? Coulisses d’un exploit pour la science.

Ne cherchez pas de logique financière dans les défis que relèvent les magiciens de Kyutai. Leur démarche dépasse largement les levées de fonds abyssales d’un H ou d’un Mistral afin de rivaliser avec OpenAI ou Google.

Pour Neil Zeghidour, le Chief Modeling Officer de Kyutai, le plus dur reste à faire : publier, avec ses collègues, le fruit de travaux menés tambour battant. « Les six derniers mois ont été vraiment fous », reconnaît Patrick Pérez, qui, avec son équipe restreinte de huit chercheurs, a réalisé une prouesse.

Car comment huit chercheurs de haut vol, disposant de 1 000 GPU, ont-ils réussi à développer Moshi, une IA vocale dotée d’une fluidité et d’une capacité d’interaction humaine impressionnantes ? Mais pour l’heure, uniquement en anglais.

Sur le papier, les moyens n’ont rien d’exceptionnel. Pour mener leurs travaux et entraîner leur modèle, l’équipe s’est appuyée sur le superpod Nabu 23 de Scaleway, filiale du Groupe Iliad. Un calculateur dont l’investissement (200 000 euros) est assez dérisoire comparé aux récents investissements rien que pour la France d’un Microsoft (4 milliards d’euros).

La facture pour faire avancer la recherche en IA n’a donc pas besoin d’être excessive. Damien Lucas, le patron de Scaleway, reconnaît qu’il n’y a rien de secret, pour une entreprise partenaire de la fondation Kyutai, et qui facture à prix coûtant : 10 millions d’euros en 6 mois ! Une somme dérisoire comparée aux montants colossaux engloutis par OpenAI et consorts.

Mais la comparaison avec OpenAI s’arrête là. En effet, avant de pouvoir converser librement avec Moshi, il reste encore beaucoup de travail à accomplir. Bien que la démonstration disponible sur leur site montre certaines de ses capacités, ce n’est qu’un prototype destiné à faire progresser la science et à partager la « secrète sauce » de ce qui ne doit pas rester longtemps une boîte noire. C’est ce que l’on appelle de la science ouverte qui est, comme l’a rappelé Patrick Pérez, « au bénéfice de tous ».

Des conversations dynamiques reconnaissant 70 émotions

En quoi Moshi se distingue ? Moshi est présenté comme un modèle d’intelligence artificielle vocal conçu pour interagir en temps réel avec ses utilisateurs. Contrairement aux assistants vocaux traditionnels, Moshi peut tenir des conversations dynamiques et naturelles, en comprenant et en répondant aux nuances émotionnelles et contextuelles du discours. Il s’agit d’une IA multimodale qui combine l’audio et le texte et qui a la capacité d’écouter et de répondre simultanément en un temps record (avec une latence d’environ 200 à 240 millisecondes). L’expérience conversationnelle est quasi humaine. Cette approche combinée audio-texte permet un entraînement plus rapide et des réponses plus riches. À la base de Moshi, Helium, un modèle de langage large (LLM) de 7 milliards de paramètres a été utilisé. Il est capable de comprendre et de générer des réponses complexes et contextuelles.

Des capacités de conversation avancées

L’équipe de Kyutai s’est attaquée aux limitations des chatbots textuels et des assistants vocaux actuels, caractérisés par une complexité excessive et une perte d’informations cruciales. Le pipeline traditionnel, composé de multiples modèles (détection de l’activité vocale, transcription, génération de réponse textuelle et synthèse vocale), engendre une latence notable de 3 à 5 secondes et perd des éléments essentiels comme les émotions et les conditions acoustiques. Pour y remédier, Kyutai a développé ce modèle qualifié « d’audiolangagier » qui unifie ces étapes en un seul réseau neuronal profond, réduisant ainsi cette fameuse latence tout et conservant la richesse de la communication vocale.

Une approche innovante de l’entraînement

Selon son concepteur, le modèle audiolangagier de Moshi prend de petits segments de son et prédit le segment suivant, similaire à la façon dont les modèles de langage textuel prédisent les mots suivants dans une phrase. Cette méthode permet de capturer non seulement le contenu des mots, mais aussi les nuances de l’intonation, de l’émotion et du contexte, rendant les interactions avec Moshi beaucoup plus naturelles. Et Neil Zeghidour – lors de sa démonstration basée sur un extrait de 7 secondes d’une intervention de Xavier Niel – de rappeler que « la façon dont nous disons les choses est au moins aussi importante que le contenu que nous disons. Ainsi, nous écoutons, nous réfléchissons, nous répondons presque instantanément, ce qui rend la conversation très vivante, très spontanée… »

Ce que ne sait pas faire un chatbot conversationnel actuel.

Mochi, une IA à la fois multimodale et multiflux

Mochi peut écouter et générer de l’audio tout en produisant des « pensées » textuelles en parallèle. Cette combinaison permet d’entraîner Mochi plus rapidement et de produire des réponses plus pertinentes et plus précises. En intégrant à la fois le texte et l’audio, Mochi utilise cette base riche pour fournir des réponses optimales. Le véritable atout de Mochi réside dans sa capacité à gérer deux flux audio simultanés. Contrairement aux systèmes existants qui alternent entre les tours de parole en utilisant la détection d’activité vocale, Mochi peut ainsi parler et écouter en même temps. Cela imite les conversations humaines où les interlocuteurs se chevauchent souvent, rendant les interactions plus naturelles. Grâce à cette capacité multiflux, Mochi peut interrompre ou répondre instantanément, créant une interaction où l’on oublie presque que l’on parle à une machine. Le test de Turing dépassé ?

Pour illustrer l’efficacité et la fluidité des interactions avec Mochi, l’équipe de Patrick Pérez a utilisé un corpus de données collecté dans les années 90 jusqu’au début des années 2000 réalisées à partir de conversations téléphoniques américaines. La démonstration de ce travail n’est rien d’autre qu’une conversation entre deux personnes. Avec l’objectif de capturer la dynamique des échanges, en y incluant les interruptions naturelles, les hésitations, les nuances émotionnelles… Bob commence par se présenter et demande à Jay d’où il vient. La conversation progresse de manière fluide, couvrant des sujets pour connaitre la nationalité de l’interlocuteur, sa connaissance des États-Unis comme des détails très personnels sur l’ordinateur et le téléphone portable utilisés par Jay… Mais il y a de cela plus de 25 années.

Création de la voix de Moshi

La création de la voix de Moshi a été un processus méticuleux. L’équipe de Kyutai a collaboré avec une artiste vocale, Alice, qui a enregistré de nombreux monologues et dialogues dans différentes situations, utilisant divers tons de voix et styles de conversation. Ces enregistrements ont servi de base pour entraîner le moteur de synthèse vocale de Moshi. Alice a prêté sa voix pour créer plus de 70 émotions ou styles de conversation, permettant à Moshi de répondre de manière appropriée dans diverses situations. Par exemple, Moshi peut parler comme un pirate, raconter une histoire mystérieuse à voix basse, ou encore réciter un poème sur Paris avec un accent français. Ces capacités vocales enrichissent les interactions et rendent Moshi « humain ». Associé à ce travail, un codec, Mimi, joue un rôle crucial en compressant le signal audio brut de manière extrêmement efficace, réduisant ainsi la taille des fichiers audio tout en capturant les caractéristiques acoustiques et sémantiques pour une meilleure qualité de reproduction et de compréhension. Dernier axe de recherche de l’équipe Kyutai, la sécurité. Elle consiste à savoir différencier les sons générés par des machines de ceux produits naturellement, en utilisant des signatures audio et des filigranes inaudibles détectables, ce qui est crucial pour des applications en authentification et protection des droits d’auteur.

La démarche d’Open Science

Kyutai entend contribuer à la recherche ouverte en IA et au développement de tout l’écosystème. L’équipe de Kyutai prévoit de rendre Moshi et ses modèles sous-jacents disponibles en open source. Le code et les poids des modèles seront donc bientôt partagés librement et gratuitement. Ce qui est inédit pour une telle technologie. Ils serviront aussi bien aux chercheurs du domaine qu’aux développeurs travaillant sur des produits et des services basés sur la voix. Cette technologie pourra ainsi être étudiée en profondeur, modifiée, étendue ou spécialisée en fonction des besoins. La communauté pourra notamment étendre la base de connaissances et la véracité de Moshi, aujourd’hui limitées dans un modèle volontairement par trop léger, tout en exploitant ses capacités d’interaction vocale hors pair.

La démonstration ne s’arrête pas là. Moshi s’exécute localement sur un MacBook Pro (un M3 Max) sans connexion Internet. Cette avancée ouvre la voie à une future exécution sur des PC dotés de « NPU » et autres smartphones, rendant l’IA vocale accessible et pratique partout et à tout moment. Avec au passage un travail impressionnant de compression et de réduction du temps de latence. De quoi nous laisser sans voix ?

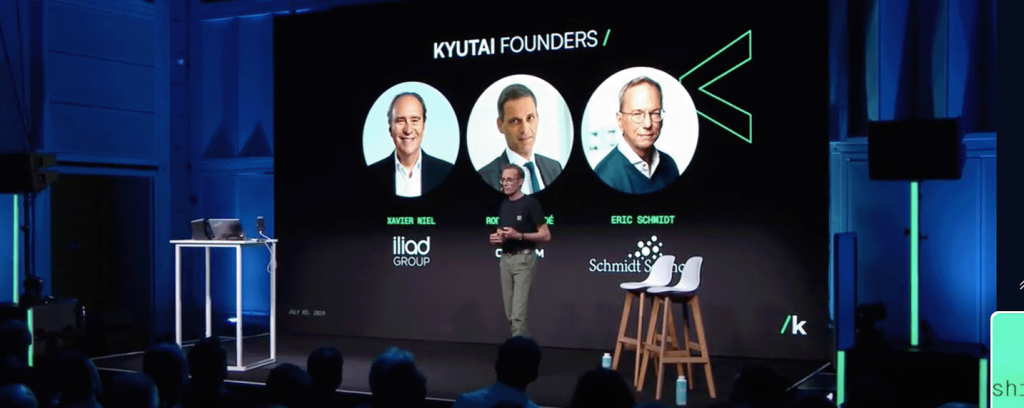

Kyutai, une fondation, mais pas à la sauce OpenAI

Sous la houlette de Patrick Perez, Kyutai émerge comme un pilier de l’innovation dans le domaine de l’intelligence artificielle, soutenu par un budget impressionnant de près de 300 millions d’euros. Des entités de renom telles qu’Iliad et CMA CGM, ainsi que la fondation d’Eric Schmidt (ex CEO de Google), ont chacune investi 100 millions d’euros, affirmant ainsi leur confiance dans la mission de la fondation : positionner la France comme leader de l’IA tout en attirant et retenant les talents nationaux qui pourraient être tentés par l’étranger. Ici nul n’est question du business, mais bien de science ouverte à tous !

À LIRE AUSSI :