Data / IA

Des réseaux de neurones physiques pour des entraînements moins énergivores

Par Charlotte Mauger, publié le 01 octobre 2024

Pour réduire la consommation d’électricité liée à l’entraînement des réseaux de neurones artificiels, des chercheurs misent sur des réseaux analogiques. Ces couches de neurones basées sur des systèmes à base de capteurs physiques, donnent déjà de très bons résultats sur des configurations simples.

Depuis les années 1980, les calculateurs sont essentiellement numériques. « Mais ces dernières années, certaines équipes qui travaillent sur les réseaux neuronaux, comme la nôtre, reviennent à l’analogique. C’est plus efficace lors des phases d’entraînement et de calculs », annonce Ali Momeni, doctorant au laboratoire d’ingénierie des ondes à l’École Polytechnique Fédérale de Lausanne (EPFL).

La raison de ce changement de cap ? L’énergie considérable utilisée pour l’intelligence artificielle. Car l’IA basée sur les réseaux de neurones artificiels, si elle est puissante, scalable et flexible, a aussi sa part d’ombre : l’énergie qu’elle nécessite pour entraîner les différents modèles. Des chercheurs développent donc des modèles qui utilisent un autre type de réseaux, basés sur des neurones dits physiques.

Aussi qualifiée d’analogique, cette classe de réseau exploite les propriétés de ces systèmes physiques, à savoir leur capacité à convertir un signal d’entrée de manière non linéaire. C’est le cas de systèmes acoustiques réceptionnant un signal d’entrée envoyé par des micros, passant par une cavité chaotique et finalement capté en sortie. Cela peut aussi être des systèmes optiques qui déforment un signal lumineux.

Comme un réseau de neurones artificiels, les physiques demandent un entraînement avant de pouvoir entrer en phase d’inférence. « C’est le plus gros défi. La phase d’inférence est en revanche facile à réaliser avec un réseau de neurones physiques », explique Ali Momeni.

C’est que l’entraînement d’un réseau de neurones (artificiels ou physiques), sous sa forme la plus répandue, demande une mise à jour des poids des neurones de l’arrière vers l’avant pour atténuer les erreurs de calcul. Si cette rétro-propagation du gradient est facile à implémenter dans les systèmes numériques basés sur des CPU et GPU, elle l’est moins dans des réseaux de neurones physiques lesquels, pour calculer l’erreur et mettre à jour les poids, ont besoin d’un jumeau numérique du réseau.

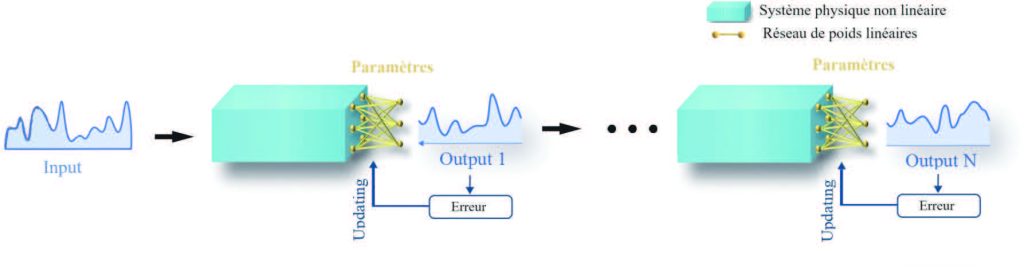

Principe de l’apprentissage physique local dans un réseau de neurones physiques

Le signal d’entrée est transformé de manière non linéaire par un système physique (analogique). En sortie du bloc, l’erreur est calculée et les paramètres du système physique sont adaptés. Puis, le signal de sortie entre dans la deuxième couche du réseau où, de nouveau, l’erreur est calculée et les paramètres ajustés.

Cela pourrait faire perdre l’avantage en termes énergétiques du réseau physique. Heureusement, « nous avons mis au point une méthode qui se passe de cette étape de rétro-propagation », annonce le doctorant.

Elle repose sur un apprentissage physique local : plutôt que de propager l’erreur sur tout le réseau, celle-ci est injectée couche par couche, avant de passer à la suite. Cette méthode met à jour chaque couche (bloc) d’un modèle en utilisant son propre signal d’apprentissage. « La consommation d’énergie en est considérablement réduite, assure-t-il, dans un rapport qui peut aller jusqu’à quatre ordres de grandeur (10 puissance 4) par rapport à un entraînement classique basé sur des GPU. »

Pour l’heure, les chercheurs ont testé leur méthode d’apprentissage pour des tâches de reconnaissance vocale (de voyelles) et visuelle, sur des systèmes physiques acoustique, micro-onde et optique, et sur des réseaux comportant de deux à six couches. La précision est proche de celle obtenue avec des réseaux de neurones numériques. « Mais l’écart devrait se creuser avec des réseaux comportant davantage de couches. Nous devons donc désormais travailler sur la scalabilité, avec des réseaux faits de plus de couches et de paramètres », annonce Ali Momeni.

Les promesses de cette informatique « physique » ne portent pas que sur la réduction de la consommation d’électricité, mais également sur les vitesses de calcul obtenues. « Si on utilise des systèmes optiques, on travaille à la vitesse de la lumière. »

Le chercheur ne fixe d’ailleurs pas de limite aux possibilités offertes, mais leur principale application pourrait d’abord concerner les systèmes embarqués, voire les capteurs. « En localisant l’entraînement et l’inférence sur ces appareils, le modèle peut améliorer sa précision, soutenir l’apprentissage tout au long de la vie et améliorer la protection de la vie privée », conclut-il.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :