Data / IA

Benchmark FrontierMath : Un nouveau défi pour l’IA

Par Laurent Delattre, publié le 15 novembre 2024

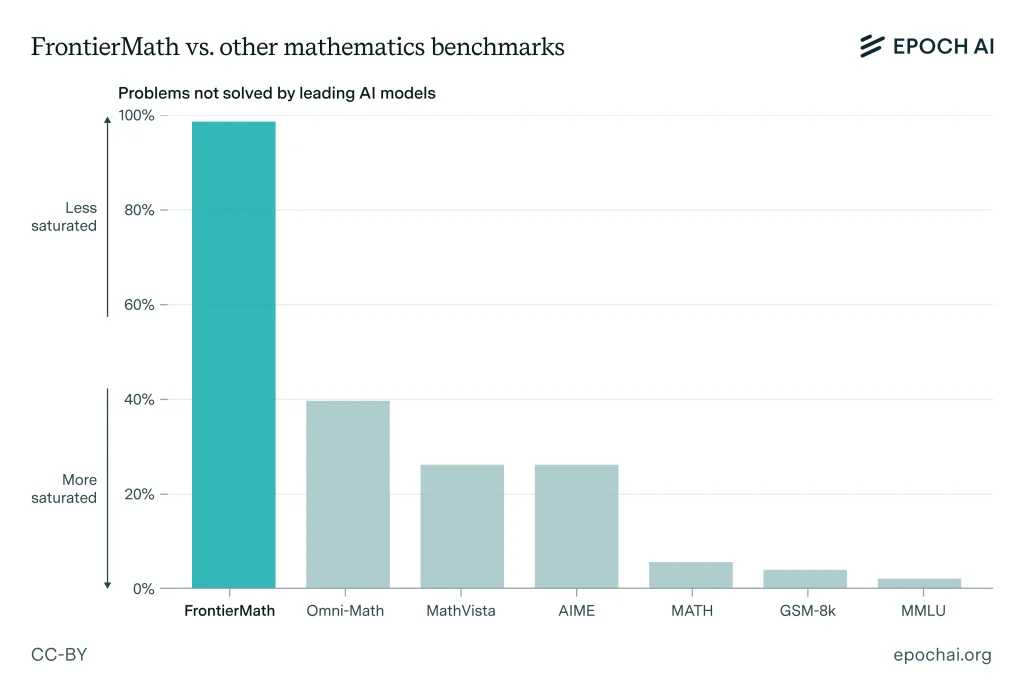

Si les benchmarks actuels ont permis de mesurer les progrès fulgurants de l’IA, leur utilité diminue face à des modèles atteignant leurs plafonds. Un nouveau bench, FrontierMath, propose des défis mathématiques d’un tout autre calibre, visant à tester les capacités de raisonnement des IA sur des terrains encore inexplorés.

D’une manière générale, dans l’univers informatique, les benchmarks jouent un rôle crucial en évaluant les performances et en identifiant les limites des technologies émergentes. Que ce soit dans le domaine du matériel ou des logiciels, ces outils de mesure permettent aux développeurs et aux utilisateurs de comparer les technologies. C’est vrai en informatique classique, en informatique quantique et même en IA. Désormais, tous les LLM comparent leurs performances relatives au travers d’une pléthore de benchmarks désormais bien connus. Et peut-être même trop connus. Aussi imparfaites que soient nos IA actuelles, certaines atteignent déjà des notes maximales sur certains benchmarks. Preuve qu’il est temps d’épicer un peu les challenges.

Si l’intelligence artificielle (IA) a fait des progrès remarquables dans de nombreux domaines, de la compréhension du langage à la génération de texte en passant par la reconnaissance d’images, force est de reconnaître qu’elle pèche encore dans d’autres domaines privilégiant une réflexion approfondie. C’est notamment le cas des problèmes mathématiques avancés, même si les dernières IA affichent désormais de bons scores sur la plupart des benchmarks mathématiques utilisés pour les comparer (MMLU, GSM8K, MathVista, Omni-Math…).

Pour nombre d’experts, il est l’heure de relever la barre et de soumettre aux futures IA de 2025 des tests plus avancés réclamant des raisonnements plus élaborés.

Un Benchmark pour repousser les limites de l’IA

Développé par le groupe de recherche Epoch AI, FrontierMath est une collection de centaines de problèmes mathématiques originaux et inédits. Ces problèmes, élaborés en collaboration avec plus de 60 mathématiciens de renom, couvrent un large éventail de domaines, allant de la théorie des nombres à la géométrie algébrique. Contrairement aux benchmarks existants comme GSM-8K ou MATH, qui sont désormais bien maîtrisés par les modèles d’IA actuels, FrontierMath offre un niveau de difficulté sans précédent qui promet de sérieusement challenger les IA à venir dans les prochaines années.

Des résultats très révélateurs

Et question challenge, les futures IA vont être servies ! Les premiers tests sur FrontierMath sont même plutôt édifiants : les modèles d’IA les plus avancés, y compris GPT-4o et Gemini 1.5 Pro, n’ont à peine réussi à résoudre que 2% des problèmes proposés.

Apparemment ces problèmes sont suffisamment complexes pour exiger souvent des heures, voire des jours de travail de la part de mathématiciens experts. Ils nécessitent des chaînes de raisonnement précises et étendues, où chaque étape se construit sur la précédente, rendant la tâche particulièrement ardue pour les IA actuelles.

L’importance de FrontierMath pour l’avenir de l’IA

FrontierMath ne se contente pas de mettre en évidence les lacunes actuelles des modèles d’IA en mathématiques avancées. Le Benchmark veut surtout servir de baromètre pour mesurer les progrès futurs dans le domaine du raisonnement complexe. En proposant des problèmes « à l’épreuve des devinettes », où une solution correcte ne peut être obtenue que par un raisonnement approfondi, ce benchmark garantit que les IA ne se contentent pas de reproduire des modèles appris, mais développent une véritable compréhension des concepts mathématiques.

Des mathématiciens de premier plan ont salué l’initiative. Terence Tao, médaillé Fields, estime ainsi que « les problèmes proposés par FrontierMath sont extrêmement difficiles. À court terme, la seule façon de les résoudre, à part faire appel à un véritable expert du domaine, est de combiner les efforts d’un semi-expert, comme un étudiant diplômé dans un domaine connexe, avec une IA moderne et de nombreux autres outils algébriques. »

Timothy Gowers, également médaillé Fields, ajoute de son côté que les challenges proposés « semblent être d’un niveau de difficulté différent de celui des problèmes de l’Olympiade internationale de mathématiques, » et donc loin des apprentissages actuels des IA.

Pourquoi les mathématiques sont-elles un défi pour l’IA ?

Les mathématiques, en particulier à un niveau de recherche, exigent un raisonnement logique précis et souvent créatif. Chaque erreur peut invalider une solution entière. Contrairement à d’autres domaines où l’IA excelle grâce à la reconnaissance de modèles et à l’analyse statistique, les mathématiques nécessitent une compréhension profonde et une capacité à élaborer des preuves complexes.

En ce sens, FrontierMath représente donc non seulement un pas important dans l’évaluation des capacités de raisonnement de nos IA mais trace également une sorte de feuille de route à suivre pour les améliorations futures des IA. C’est également une invitation à repenser la manière dont les IA raisonnent et abordent les problèmes complexes. Matthew Barnett, chercheur en IA, en est même convaincu : « Une fois que FrontierMath sera entièrement résolu, les humains vivront aux côtés d’un ensemble entièrement distinct d’êtres intelligents. »

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :