Data / IA

Solitude et dépendance : Les DSI doivent-ils s’inquiéter de l’impact psychologique des chatbots IA sur les collaborateurs ?

Par Laurent Delattre, publié le 25 mars 2025

ChatGPT, Claude AI, Gemini, Le Chat, Copilot Chat, Perplexity… En deux ans, les assistants conversationnels ont envahi aussi bien la sphère personnelle que professionnel. Aides à la productivité, soutiens opérationnels, compagnons du quotidien, ces chatbots dopés à l’IA générative sont devenus omniprésents. Au point d’impacter la santé mentale de leurs utilisateurs intensifs ? Les risques existent, comme tendent à le démontrer deux études du MIT et d’OpenAI.

Les DSI doivent désormais intégrer une réalité sous-estimée dans leurs réflexions sur la transformation numérique par l’IA et le déploiement à grande échelle des IA conversationnelles. L’usage intensif de ces outils peut avoir des effets psychologiques non négligeables sur leurs utilisateurs. On ne parle pas ici directement de l’impact de l’IA sur l’emploi ou le rôle de chacun dans l’entreprise mais bien d’impacts sur le comportement des collaborateurs qui usent et abusent de tels outils.

De nouvelles recherches (ici et ici) menées conjointement par OpenAI et le MIT Media Lab révèlent en effet d’inquiétantes corrélations entre l’utilisation intensive des chatbots comme ChatGPT et certains indicateurs de santé mentale et de bien-être au travail. La première étude a analysé plus de 4 millions de conversations avec ChatGPT auprès de 4 076 utilisateurs consentants, tandis que la seconde a recruté 981 participants pour un essai de quatre semaines avec utilisation quotidienne de l’assistant conversationnel.

Un vrai soutien dont il ne faut pas abuser

Les recherches montrent qu’une utilisation modérée des chatbots notamment via des interactions vocales – qu’elles soient « engageantes » ou « neutres » – peut initialement avoir des effets bénéfiques et apporter une forme utile de soutien psychologique en notamment réduisant la charge mentale. Les employés peuvent en effet ressentir – notamment au début – une réduction de la solitude et une forme de soutien émotionnel qui les aide à traverser les périodes de stress ou d’isolement.

Par ailleurs, la formulation des échanges, notamment le type de conversation (personnelle, non-personnelle ou ouverte), influence ces effets : des échanges plus personnels peuvent atténuer la dépendance émotionnelle au système.

Mais, comme souvent, le rapport avec cette technologie peut ensuite évoluer avec le temps et s’intensifier au point de générer une forme de dépendance aux effets pervers.

Des signaux d’alerte pour les utilisateurs intensifs

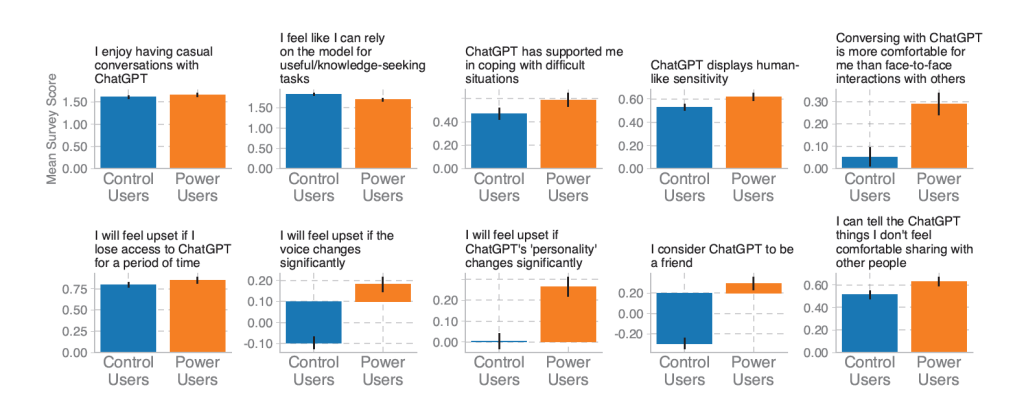

Les résultats montrent que si la majorité des utilisateurs entretient une relation “neutre” avec ChatGPT, l’utilisant comme un simple outil productif, un sous-groupe finit par émerger : les utilisateurs intensifs, ceux qui passent le plus de temps – voire le plus clair de leur temps – à interagir avec les chatbots.

« Généralement, les utilisateurs qui engagent des conversations personnelles avec les chatbots tendent à éprouver une plus grande solitude », notent les chercheurs. « Ceux qui passent plus de temps avec les chatbots tendent à être encore plus solitaires. »

Plus inquiétant pour les organisations : l’utilisation intensive de ChatGPT est corrélée non seulement à une augmentation de la solitude et de la dépendance émotionnelle, mais aussi à une réduction des interactions sociales réelles. Un constat qui pourrait, dès lors, avoir des répercussions importantes sur la cohésion des équipes et la santé mentale au travail.

Évolution des ressentis émotionnels et psychologiques entre les utilisateurs à usages contrôlés et les utilisateurs intensifs. Ces derniers développent un attachement émotionnel plus important.

De la confiance à la dépendance

Sans surprise, l’impact mental des chatbots varie en fonction des caractéristiques personnelles des employés. Des facteurs tels que l’état émotionnel initial, le style d’attachement et la confiance accordée au système modèrent la manière dont ces outils sont utilisés et perçus. Cathy Mengying Fang du MIT Media Lab souligne ainsi que « les personnes ayant des tendances à l’attachement émotionnel fort et à une confiance élevée envers l’IA sont davantage sujettes à la solitude et à la dépendance émotionnelle. »

De même, les utilisateurs ayant tendance à éviter leurs propres émotions ressentent une augmentation significative de la solitude après l’utilisation intensive du chatbot.

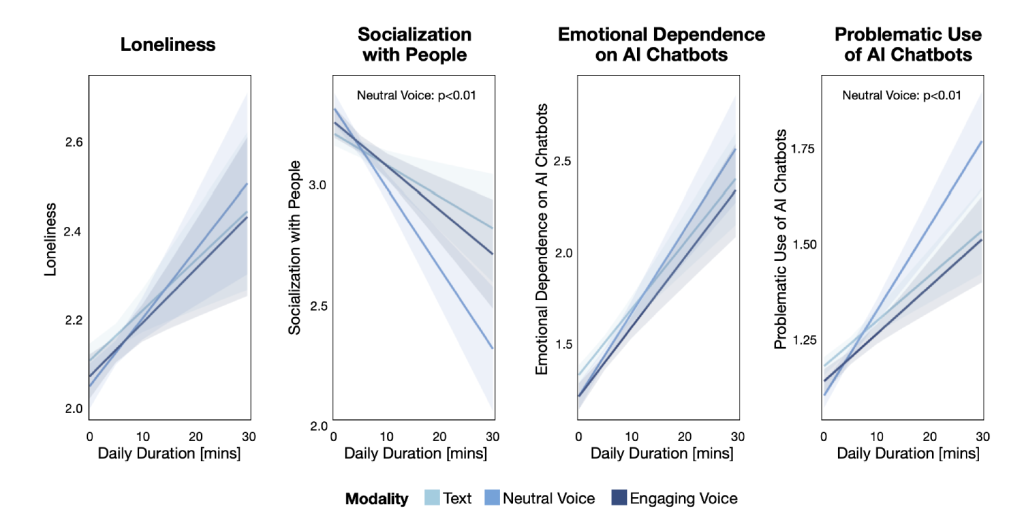

Graphiques de régression montrant l’évolution finale des indicateurs psychosociaux (solitude, socialisation, dépendance émotionnelle et usage problématique) en fonction du temps quotidien passé sur le chatbot (minutes), selon la modalité (texte, voix neutre, voix engageante).

En outre, l’utilisation du mode vocal semble généralement associée à un meilleur bien-être émotionnel, à condition que la durée d’utilisation soit modérée. Dès que la durée s’allonge, les risques de baisse de socialisation et d’utilisation problématique augmentent. Étrangement, ils semblent augmenter plus vite si l’IA utilise un mode vocal neutre plutôt qu’engageant.

Mais, et c’est le plus surprenant, l’étude révèle également des différences significatives entre hommes et femmes. « Après avoir utilisé le chatbot pendant quatre semaines, les participantes féminines étaient légèrement moins susceptibles de socialiser avec des personnes que leurs homologues masculins », indiquent les chercheurs du MIT.

Un autre phénomène troublant a été constaté : Les participants utilisant un chatbot avec une voix de genre opposé au leur sont plus enclins à ressentir une plus grande solitude et une dépendance émotionnelle plus forte !

Vers un “alignement socio-affectif” des chatbots en entreprise

Dit autrement, les DSI ne doivent pas ignorer l’impact psychologique d’un usage intensif des chatbots. Ces études invitent les organisations à encourager une utilisation raisonnée de ces outils IA et promouvoir des dispositifs complémentaires pour favoriser la communication directe et les espaces d’échange entre humains. Tout est toujours une question d’équilibre.

Elles peuvent aussi s’inspirer de l’expérience acquise avec l’usage des réseaux sociaux en mettant par exemple en place des « rappels » réguliers lorsqu’un utilisateur passe plusieurs heures par jour sur ces applications. Et elles peuvent former les responsables RH à reconnaître les signes d’une dépendance excessive aux assistants conversationnels et porter une attention spéciale aux collaborateurs déjà émotionnellement affectés.

Mais, surtout, les chercheurs appellent les entreprises et les éditeurs à une nouvelle approche dans la conception même des assistants conversationnels pour réduire les risques évoqués plus haut. L’objectif est de bien comprendre les dérives d’interactions vocales trop engageantes ou au contraire trop neutres, d’interactions textuelles qui invitent un peu trop l’utilisateur à poursuivre la conversation sur la durée, etc. Pour les chercheurs, il faut aujourd’hui veiller à concevoir des interfaces qui répondent aux besoins des utilisateurs sans les exploiter, ni remplacer les interactions humaines fondamentales.

Reste que, pour les entreprises déployant ces assistants IA, de nouvelles implications émergent : elles doivent reconnaître que la santé mentale de leurs employés est désormais partiellement sous leur responsabilité lorsqu’elles intègrent ces technologies.

Les organisations pourront-elles trouver le juste équilibre entre les gains de productivité promis par l’IA et la préservation du bien-être de leurs employés ? Le débat ne fait que commencer, mais les DSI sont invités à s’y engager dès aujourd’hui.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :