Cloud

À Google Cloud Next 2025, Google peaufine sa vision de l’IA agentique

Par Laurent Delattre, publié le 10 avril 2025

En orchestrant l’interopérabilité des modèles, la scalabilité des agents et l’automatisation des usages métiers, Google affirme à son Google Cloud Next 2025 une vision industrielle de l’IA, où de multiples agents collaborent entre eux autant qu’avec les humains. Voici ce que les DSI doivent retenir des multiples annonces de cette conférence qui se tient cette semaine à Las Vegas…

Pour ouvrir sa grande conférence annuelle dédiée à Google Cloud, le géant américain voulait sans surprise surtout parler « IA ». Difficile de ne pas s’en douter alors que l’IA envahit le paysage des entreprises, bouscule les business de Google et reste le sujet « numéro 1 » de toutes les conférences IT depuis deux ans.

Non sans raison. « Plus de 4 millions de développeurs utilisent Gemini et l’utilisation de Vertex AI a été multipliée par 20 l’an dernier, portée par l’adoption massive de Gemini Flash, Gemini 2.0, Imagen 3.0 et plus récemment de notre modèle avancé de génération vidéo. Sans oublier les 2 milliards d’assistances IA mensuelles réclamées par les utilisateurs professionnels de Google Workspace » s’est ainsi enthousiasmé Thomas Kurian, le CEO de Google Cloud en ouverture de conférence.

Ce Google Cloud Next 2025 a été l’occasion pour l’hyperscaler non seulement d’exposer les multiples nouveautés à ses plateformes et outils IA mais aussi d’exposer et compléter sa vision sur la grande tendance du moment, l’IA Agentique.

« Chez Google Cloud, notre mission est de stimuler votre innovation en vous offrant la plateforme la plus performante, optimisée pour l’IA et prête pour l’entreprise. Notre infrastructure de pointe, nos modèles avancés, nos outils et agents sont à votre service, » souligne ainsi Thomas Kurian avant d’inviter sur scène une pléthore de partenaires et d’entreprises pour démontrer à tous, que oui, clairement, l’IA a dépassé le stade des POCs et commence à réinventer les Business de toutes les organisations dans à peu près tous les secteurs d’activité.

D’autant que désormais, l’IA ne se contente plus de converser. Elle se mute en véritable collaborateur qui agit avec autonomie et s’intègre dans les maillons de l’entreprise grâce à l’IA agentique. Et pour Google Cloud, les agents IA vont non seulement collaborer avec les employés mais aussi entre eux pour mieux résoudre les défis les plus complexes. Et Google construit avec Vertex AI et une série de protocoles ouverts les moyens de concrétiser cette vision en jouant la carte de l’interopérabilité.

Mais pour concrétiser cette vision, il faut des infrastructures, des modèles, des outils, des assistances intelligentes. Et Google Cloud avait beaucoup de choses à annoncer. Voici ce que les DSI doivent retenir de toutes les annonces IA de ce Google Cloud Next.

Des infrastructures pour l’IA de demain

Google a confirmé son intention de continuer à lourdement investir sur ses infrastructures pour servir les besoins des entreprises (et ses propres besoins) en matière d’IA avec un budget d’investissement de 78 milliards de dollars malgré les facéties du gouvernement américain. Plus concrètement, sur ce Google Cloud Next, ces investissements se traduisent par des annonces autour des accélérateurs IA, du concept d’Hypercomputer AI et de la disponibilité de Gemini dans des environnements très contrôlés.

Ironwood TPU : attention, ça décoiffe

L’une des annonces clés de cette édition 2025 aura été celle de la septième génération d’accélérateur TPU de Google : Ironwood TPU. Une puce spécifiquement créée, cette fois, pour « l’ère de l’inférence » et les besoins très particuliers des nouveaux modèles capables de raisonner. Ces modèles sont essentiels à la concrétisation de l’IA agentique mais aussi pour continuer à faire progresser l’IA dans sa capacité à gérer des demandes et problèmes de plus en plus complexes.

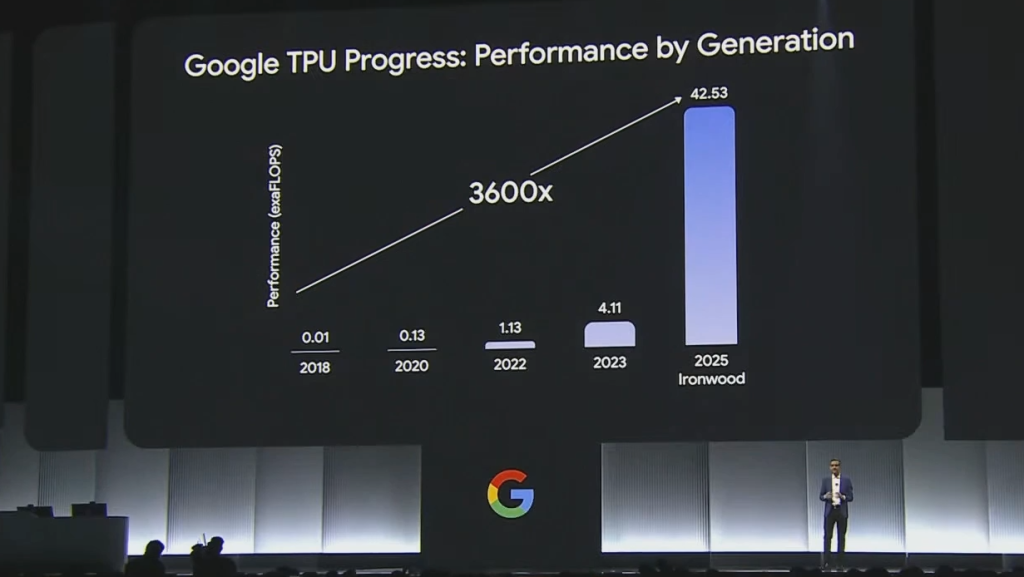

Ironwood est 3600 fois plus performant et 29 fois plus énergie efficient que le tout premier TPU introduit en 2018. Avec une performance par puce de 4614 TFLOPS, Ironwood embarque 6 fois plus de mémoire HBM que la génération précédente (le TPU Trilium sorti l’an dernier) et dispose d’une bande passante près de 5 fois supérieure. Le tout avec une efficacité énergétique doublée par rapport au Trilium.

Ces puces seront mises à disposition des entreprises en fin d’année au travers des « TPU Pods » de Google Cloud avec des configurations embarquant 256 puces Ironwood ou 9216 puces Ironwood. Cette dernière variante affiche une performance de 42,5 exaflops ! Et Google d’affirmer que cela en fait une machine 24 fois plus puissante que « El Capitan » le HPC le plus puissant de la planète, en oubliant de préciser que les exaflops de son TPU Pod Ironwood sont calculés en précision FP8, là où le plus puissant supercalculateur est évalué en FP64. Pas vraiment un détail. Reste que 42,5 exaflops pour animer des IA, c’est déjà beaucoup, mais alors vraiment beaucoup de puissance !

L’Hypercomputer AI : un concept nébuleux mais essentiel

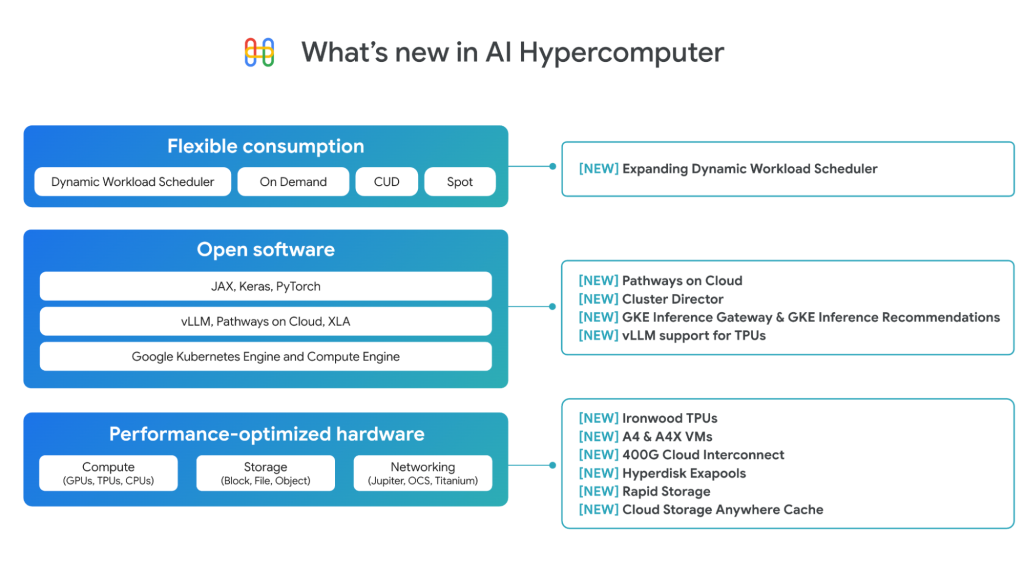

Depuis l’édition 2023 de sa conférence, Google peaufine son concept d’Hypercomputer AI. Il s’agit d’une architecture intégrée comprenant à la fois du matériel et des couches logicielles pour optimiser les performances des workloads IA. « L’AI Hypercomputer est un système de supercalcul intégré issu de plus d’une décennie d’expertise Google en IA. Cette architecture propulse pratiquement tous les workloads IA sur Google Cloud. Elle exécute en coulisses la plateforme Vertex AI et sert de fondation à vos projets IA sur Google Cloud. Conçu pour maximiser l’IA à coût constant, ce système intégré se démarque nettement : c’est grâce à l’AI Hypercomputer que Gemini offre une intelligence 24 fois supérieure par dollar dépensé à GPT-4o » rappelle l’hyperscaler en précisant que cet hypercomputer rend Gemini 5 fois plus performant que DeepSeek R1 pour chaque dollar investi.

Bien évidemment, l’AI Hypercomputer s’enrichira des TPU Ironwood dans un proche avenir. Mais ses couches logicielles évoluent aussi. Elles accueillent trois nouveautés importantes :

* GKE Inferencing : Google Kubernetes Engine s’enrichit de nouvelles fonctionnalités d’inférences qui permettent d’optimiser le déploiement de vos inférences et de simplifier les montées en charge. Selon les benchs internes de Google, ce GKE Inferencing réduit les coûts de service jusqu’à 30%, diminue la latence de 60% et augmente le débit de 40%.

* Pathways : Le runtime ML de Google DeepMind arrive pour la première fois sur le Cloud. Il permet une inférence multi-hôtes dynamique avec des performances exceptionnelles pour un coût optimal.

* vLLM sur TPU : De plus en plus populaire, notamment sous Vertex AI, la bibliothèque vLLM qui tend à standardiser l’inférence LLM, est désormais supportée sur les TPU. Les clients ayant optimisé leurs workloads IA avec vLLM pour GPU peuvent désormais exécuter directement leurs charges de travail sur TPU de façon économique, maximisant leurs investissements et leur flexibilité.

Du déploiement sur site pour les secteurs réglementés

Soucieux des exigences des secteurs régulés tels que la santé, la finance ou le gouvernement, Google propose désormais de déployer ses modèles Gemini on-premises grâce à l’arrivée de ses multiples modèles sur Google Distributed Cloud.

Toujours plus de modèles pour vos applications IA

L’innovation de Google ne s’arrête pas aux infrastructures. La panoplie de nouveaux modèles d’IA présentée lors de Google Cloud Next et disponibles via Vertex AI illustre la diversité des cas d’usage désormais adressables avec les modèles Google :

Gemini 2.5 Flash : Il y a quelques jours, Google dévoilait sa nouvelle famille de modèles hybrides « Gemini 2.5 » avec leur faculté de raisonnement intégrée et introduisait son nouveau modèle frontière « Gemini 2.5 Pro ». À Google Cloud Next 2025, l’éditeur a officialisé l’arrivée de « Gemini 2.5 Flash » destiné à remplacer l’expérimental « Gemini 2.0 Flash Thinking ». Gemini 2.5 Flash est conçu pour les interactions à haut volume, avec des réponses rapides, des résumés en temps réel, et un accès rapide aux documents tout en optimisant les coûts. Il ajuste automatiquement son “budget de réflexion” en fonction de la complexité des requêtes.

Chirp 3 : Ce nouveau modèle permet de créer des voix personnalisées à partir de seulement 10 secondes d’enregistrement audio, ouvrant de nouvelles perspectives pour la communication vocale.

Veo 2 : Destiné à la production et à l’édition de vidéos, ce modèle de génération de vidéos en haute définition simplifie désormais les processus de montage tout en offrant des fonctionnalités avancées, comme le remplissage d’images de fond, la suppression de logos, le recadrage, etc.

Lyria : Selon Google, il s’agit là du premier modèle « text-to-music » pensé et conçu pour les besoins des entreprises. Pratique pour créer des musiques d’attente, des fonds sonores pour les campagnes marketing, des expériences immersives en magasin, des accompagnements musicaux aux podcasts, etc.

Ces modèles offrent aux développeurs et aux entreprises toute une nouvelle richesse fonctionnelle pour couvrir l’ensemble des besoins métiers en matière de génération de contenus multimédias.

L’émergence d’une IA agentique « multi-agents »

Google dévoile une nouvelle ère dans laquelle l’IA ne se contente plus de répondre aux besoins individuels mais agit de manière collaborative et systémique. L’hyperscaler introduit dans Vertex AI de nouvelles briques pour permettre aux agents IA autonomes d’interagir entre eux de façon autonome et sécurisée pour mieux automatiser des processus complexes.

Vertex AI, nouveau cœur de l’IA agentique

Pour concrétiser cette vision, Vertex AI s’enrichit de quatre nouveautés phares :

Agent Development Kit (ADK) est un kit de développement qui facilite la création d’agents intelligents. Il suffit d’une centaine de lignes de code pour produire des agents IA totalement intégrés à l’univers Google Cloud avec toutes les sécurités et mécanismes d’orchestration. Au passage, on remarquera que ADK implémente en standard le protocole ouvert MCP inventé par Anthropic pour standardiser la connexion des LLMs aux différentes sources de données ! Dit autrement, Google (comme OpenAI il y a quelques jours) adopte MCP, en faisant un standard de fait.

Agent Engine permet de déployer facilement vos agents IA en production. Entièrement intégré à Vertex AI, ce service managé et serverless gère l’infrastructure technique (serveurs, authentification), vous permettant de vous concentrer sur les fonctionnalités de vos agents. Fait notable, les agents peuvent utiliser des modèles au-delà de ceux de Vertex AI et, bien qu’actuellement limité à Python, l’Agent Engine supportera d’autres langages à l’avenir.

Le protocole A2A (Agent-2-Agent) : Pour concrétiser sa vision « multi-agents collaborant », Google avait besoin de s’assurer que les différents agents puissent s’échanger des informations dans un cadre commun. Conçu par Google mais ouvert à tous, « A2A » est le premier protocole permettant aux agents IA de communiquer entre eux, quelle que soit leur technologie. Ce protocole sécurise les échanges d’information et coordonne les actions des agents à travers diverses plateformes. Plus de 50 partenaires majeurs comme Salesforce, SAP et ServiceNow participent d’ores et déjà à son développement pour favoriser l’émergence de véritables écosystèmes multi-agents. Reste à savoir si Microsoft et les acteurs européens de l’IA suivront Google et l’adopteront également.

Agent Garden : Complétant le “Model Garden” existant, « l’Agent Garden » enrichit Vertex AI d’une collection d’agents préconfigurés ou personnalisables. Accessible via l’ADK, cette collection d’agents modèles permet aux entreprises de créer rapidement des agents IA sur mesure tout en bénéficiant de plus de 100 connecteurs préfabriqués et du protocole A2A.

Agentspace : le Hub agentique de Google Cloud

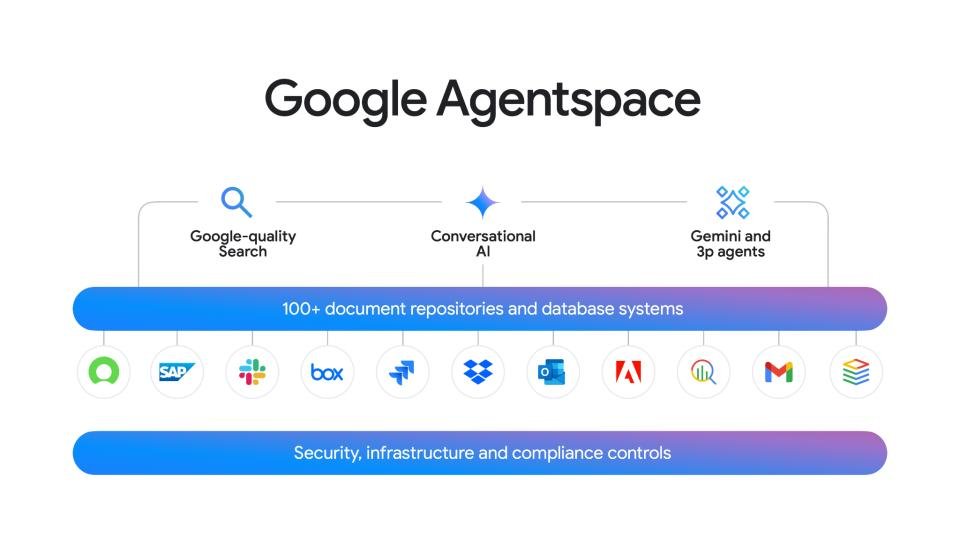

Lancé en fin d’année 2024 mais toujours en preview limitée, Agentspace est un véritable Hub pour créer et orchestrer des agents IA au sein des entreprises. Son interface centralisée permet de facilement découvrir, gérer et déployer de tels agents. Elle vise à les démocratiser en proposant notamment une interface No-Code pour les créer et les agencer.

Cette plateforme combine recherche d’entreprise, IA conversationnelle, Gemini et agents tiers, permettant aux employés de synthétiser l’information, dialoguer avec des agents IA et interagir avec leurs applications professionnelles. C’est l’équivalent Google du Copilot Studio de Microsoft.

Google a ainsi annoncé plusieurs enrichissements à son Hub Agentspace :

* Une intégration à Chrome Enterprise pour accéder aux ressources depuis la barre de recherche

* Une Galerie d’Agents centralisant tous les agents disponibles ;

* Un nouvel « Agent Designer » pour créer des agents personnalisés sans code ;

* Un nouvel agent « Deep Research » dopé par Gemini 2.5 Pro pour explorer automatiquement des sujets complexes ;

* Un nouvel agent « Idea Generation » pour stimuler l’innovation commerciale des collaborateurs.

Intégrer toujours plus d’IA dans les outils d’entreprise

L’IA n’est plus cantonnée aux seuls centres de données ou aux applications spécialisées. Au-delà des assistants traditionnels, elle s’infiltre désormais dans le quotidien des collaborateurs via leurs outils de productivité. Et Google avait plusieurs nouveautés à annoncer :

Gemini Code Assist

L’outil d’aide au codage et d’assistance aux développeurs évolue pour devenir un véritable accélérateur de productivité pour les développeurs. Intégré dans les EDI populaires (Android Studio, VSCode, JetBrains), il va au-delà de la simple complétion de code en permettant désormais de générer des applications complètes depuis des spécifications et de traduire le code entre différents langages. Son interface kanban offre une visibilité en temps réel sur le processus de génération, renforçant la confiance des utilisateurs. En automatisant les tâches répétitives (débogage, documentation, optimisation), il libère du temps pour l’innovation et la résolution de problèmes complexes.

Plus d’IA dans Google Workspace

Google continue d’insuffler toujours plus d’IA Gemini au cœur de sa suite collaborative. On retiendra notamment l’arrivée dans DOCS d’une fonctionnalité audio pour lire vos textes mais aussi automatiquement générer un Podcast à partir d’un document. Autre nouveauté DOCS, « Help me refine » est un coach rédactionnel qui améliore automatiquement votre style, votre plan, vos formulations et même votre mise en forme des documents.

« Help me analyze » dans Sheets fait de n’importe quel collaborateur un virtuose des feuilles de calcul pour faire parler les données, créer des graphiques pertinents, réaliser des analyses avancées.

L’outil Vids est désormais propulsé par le nouveau modèle Veo 2 pour des générations vidéos plus pertinentes. Et l’IA agit comme un conseiller en réunion dans Meet (résumé des discussions pour les retardataires, synthèses des actions à faire, clarification des points essentiels) et comme un assistant dans Chat (suivi des conversations, mise en évidence des points clés et actions à venir).

Workspace Flows fait de la concurrence à Microsoft Power Automate

Probablement l’une des trois principales annonces de ce Google Cloud Next, Workspace Flows est un nouvel outil d’automatisation des processus métiers et des workflows qui se positionne comme concurrent direct de Microsoft Power Automate et comme une alternative IA aux services IFTTT et Zapier. Utilisant les agents personnalisables “Gems” de Gemini et ne nécessitant aucune compétence en programmation, cet outil No-Code automatise les processus complexes, comme le support client, l’analyse documentaire ou la vérification de conformité marketing. Son interface intuitive favorise l’automatisation multi-applications, interconnectant les différents outils d’entreprise. Workspace Flows accède aux fichiers Google Drive pour obtenir du contexte et s’intègre aux services tiers.

On le voit, Google fait feu de tout bois pour imposer ses plateformes et ses modèles dans un univers d’IA d’entreprise qui cherche encore comment tirer de la valeur de ces technologies. L’hyperscaler avance vite, dicte désormais son rythme à la concurrence et avance avec une vision claire et finalement relativement mature dessinant au passage un futur où l’IA repense profondément nos modes de travail, nos outils, nos services, et ouvre des perspectives inédites…

À LIRE AUSSI :