Data / IA

Alain Becoulet (ITER) : « Si une IA sait nous alerter, nous gagnons un temps précieux »

Par Thierry Derouet, publié le 08 avril 2025

À l’occasion de son “Tour de France de l’IA” qui s’est tenu en mars dernier au Palais des Congrès de Paris, Microsoft France a annoncé un partenariat hors normes avec ITER, ce programme planétaire qui ambitionne de recréer sur Terre la fusion nucléaire, source même de l’énergie des étoiles.

«Accélérer 250 ans de recherche scientifique en 25 ans ». L’ambition lancée par Satya Nadella, reprise à son compte par Philippe Limantour (Directeur de la Technologie et de la Cybersécurité chez Microsoft France), résonne comme un cri de ralliement pour tous ceux qui explorent le futur de la science. L’enjeu consiste à affronter la complexité là où la quantité de connaissances croît de manière exponentielle.

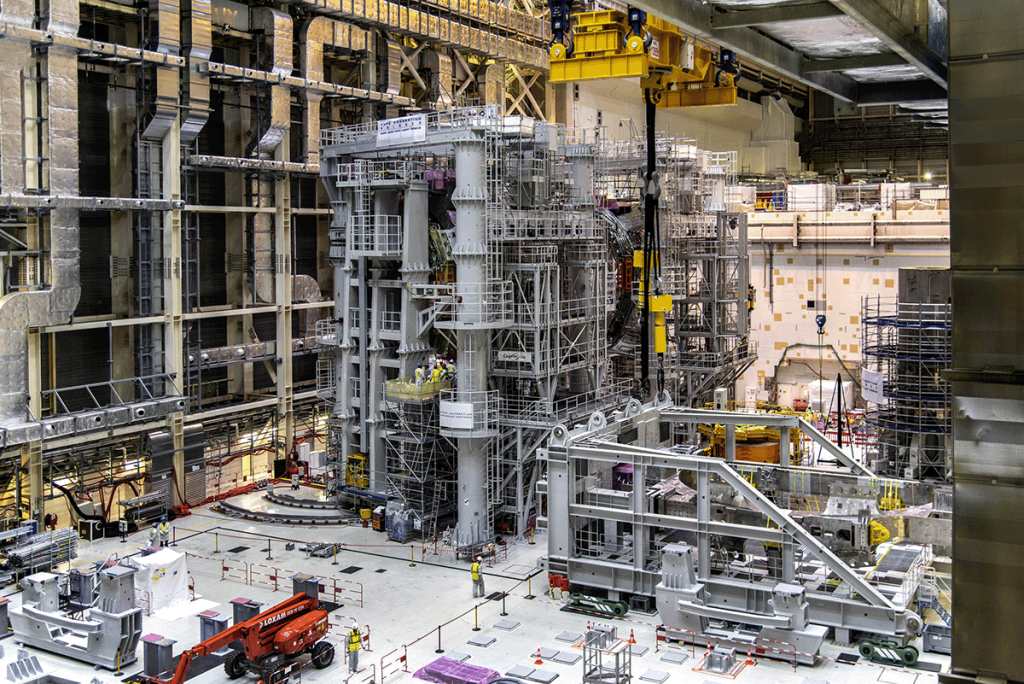

La rencontre entre Microsoft et ITER, officialisée durant le “Tour de France de l’IA” à Paris, cristallise cet élan. Dans ce recoin des Bouches-du-Rhône, au nord d’Aix-en-Provence, les équipes internationales d’ITER s’acharnent depuis plusieurs années à assembler plus d’un million de composants de haute technologie. Le but est de prouver qu’il est possible de faire fusionner des noyaux d’hydrogène pour générer une énergie nettement plus propre que la fission nucléaire classique. Les installations, dressées sur un plateau provençal autrefois dédié aux champs de lavande, couvrent plus de 180 hectares.

Sur le site d’ITER, les composants ne sont pas les seuls à se compter par millions. Les équipes du projet produisent et échangent en effet une quantité considérable de documents techniques, notices, rapports de tests, spécifications d’assemblage, et comptes-rendus de réunions. Les chercheurs, confrontés à de nouvelles découvertes, publient constamment des articles ou des notes internes qui, mis bout à bout, forment une base de données colossale, en croissance permanente. Les recherches se déploient dans plusieurs langues, les partenaires industriels se comptent par centaines. Il faut vérifier à chaque étape qu’une pièce livrée en provenance de Chine ou d’Inde, ou qu’un élément conçu en Europe, respecte les tolérances de fabrication.

« Il y a entre deux et deux millions et demi d’articles scientifiques publiés chaque année dans le monde, soulignait Philippe Limantour, et cette avalanche d’informations se répercute aussi sur les programmes d’envergure comme ITER. Nous ne pouvons plus faire reposer toute l’expertise sur les seules épaules d’ingénieurs passés maîtres dans l’art de fouiller des milliers de fichiers, explique Alain Becoulet. Il faut une vraie collaboration entre l’humain et la machine pour être certain de ne rien omettre ou oublier. »

Microsoft propose d’y contribuer en fournissant des briques d’intelligence artificielle, afin de soulager les cerveaux humains d’une partie de la tâche documentaire, de simplifier les innombrables vérifications, et de lancer des calculs à très grande échelle.

Transformer le flot d’informations en savoir exploitable

« Notre objectif est de métamorphoser l’information brute en une connaissance pleinement vivante, explique Philippe Limantour. Il ne suffit plus d’empiler des documents, il faut sans cesse les actualiser, les relier, les confronter. »

Au sein de Microsoft Research, mille doctorants et une myriade de collaborateurs travaillent déjà sur la gestion de masses documentaires. Ils ont conçu des approches d’intelligence artificielle capables de traiter des millions de pages en quelques secondes, de détecter des liens imperceptibles, de souligner des contradictions.

« Ces nouvelles formes d’IA, poursuit Alain Becoulet, nous aideront à repérer rapidement les divergences, à écarter les redondances inutiles, et à faire émerger de véritables pistes d’innovation. C’est un soulagement mental considérable et un moyen d’aller plus vite. »

Le jeudi 19 décembre 2024, la première instruction a été émise depuis la salle de commande principale d’ITER, une étape décisive vers l’exploitation du tokamak. Une puissante pompe à des centaines de mètres du Bâtiment de contrôle a reçu l’ordre de s’activer, et l’eau s’est engouffrée dans l’une des boucles de refroidissement de l’installation de compensation de la puissance réactive.

Des copilotes pour la “fusion science”

La première brique consiste à déployer chez les « fusion scientists » d’ITER des licences Copilot, l’environnement d’assistance créé par Microsoft. Son rôle dépasse la simple automatisation des emails. Il s’agit d’un outil qui scanne, classe et connecte des documents techniques, tout en tenant compte de leur langue d’origine.

Microsoft ajoute à cela deux agents : Deep Search, qui interagit avec la documentation pour en extraire la substantifique moelle, et Agent Flow, qui applique des protocoles précis de vérification. Ces agents préparent le terrain, sans jamais prétendre remplacer l’expertise humaine.

« En aucun cas, l’agent ne prend la décision finale, souligne Philippe Limantour. Il formule des hypothèses, des diagnostics, puis les ingénieurs et les chercheurs tranchent. »

La question de la propriété intellectuelle illustre le gain potentiel. Avec près d’un millier d’entreprises mobilisées dans le monde, il peut arriver qu’un savoir capital se trouve brevetté par plusieurs entités en parallèle. Retrouver l’origine d’une idée devient un casse-tête. À présent, un agent IA est capable de parcourir la vaste base documentaire pour préciser qui a inventé quoi, et dans quelles conditions, en quelques secondes.

Un monde où la vérité scientifique s’ajuste au fil du temps

« Ce qui est exact aujourd’hui sera peut-être contredit demain, dit Alain Becoulet. Nous vivons déjà dans cette dynamique expérimentale : la science avance par hypothèses et réfutations. »

Face à la crainte des “hallucinations” de l’intelligence artificielle, il rappelle que l’erreur fait partie du processus humain. Les biais cognitifs sont légion parmi les chercheurs. L’IA peut se tromper elle aussi, mais elle compense par un balayage massif de documents, et par des outils de “grounding” capables de vérifier la fiabilité d’une affirmation à sa source.

Microsoft a notamment développé un système de classification, un système qui lit les textes, repère les allégations vérifiables et catégorise ce qui doit être examiné. Dans tous les cas, les ingénieurs d’ITER gardent la main.

« Au fond, explique Alain Becoulet, c’est une intelligence augmentée : l’humain reste la clé de voûte, mais il bénéficie d’un formidable levier pour distinguer la validité des données. »

Moderniser des codes qui tournent à puissance extrême

Au-delà de la documentation, l’accord entre Microsoft et ITER prévoit la refonte d’importants outils de calcul, vitales pour comprendre l’ébullition d’un plasma à 150 millions de degrés. La plupart des codes utilisés, parfois écrits dans le vieux langage Fortran, n’étaient pas conçus pour être exécutés sur des grappes de plusieurs dizaines de milliers de processeurs graphiques (GPU).

« Nous n’avons pas encore d’ordinateur quantique pour résoudre la fusion, sourit Alain Becoulet, alors nous misons sur le calcul massif. Certains scénarios requièrent 20 000 ou 40 000 GPU, sur des durées prolongées, afin de simuler en détail la turbulente danse des particules. »

Peter Kroul, de la section Systèmes et opérations informatiques, présente le Centre de calcul et de données scientifiques, où les données d’ITER seront stockées, sécurisées, traitées et distribuées pendant toute la durée de vie de l’installation. Le stockage et la gestion des informations débuteront en 2025, lorsque le centre commencera à recevoir les flux provenant des différents systèmes d’ITER.

Des outils comme GitHub Copilot peuvent alors documenter ces codes, y injecter des pistes d’optimisation, et aider les chercheurs à tirer pleinement parti des infrastructures de Cloud computing. L’idée n’est pas de rendre l’IA infaillible, mais de pousser la recherche scientifique à un niveau d’exploration inatteignable sans ce concours numérique.

Le rôle de catalyseur

Cet accord n’est pas exclusif. ITER, qui réunit 35 pays et plusieurs organismes de recherche, multiplie les partenariats. Mais Microsoft, grâce à la palette de services Azure et à la démarche AI for Science, constitue un allié précieux pour dépasser des goulots d’étranglement que la seule main-d’œuvre humaine ne parvient plus à franchir.

C’est un échange de bons procédés. ITER, avec ses défis monumentaux, fournit à Microsoft un “laboratoire vivant” où mettre à l’épreuve ses dernières briques d’IA et de calcul haute performance. En retour, ITER bénéficie d’avancées techniques qui pourraient lui faire gagner de longs mois sur la construction et l’assemblage de son réacteur.

« Nous sommes environ 1 200 à travailler directement sur le site de Saint-Paul-lez-Durance, sans compter les partenaires venus d’Asie, d’Europe, d’Amérique, précise Alain Becoulet. Ajouter encore plus de bras ne résoudrait pas le problème. Il faut orchestrer la connaissance et la confrontation des idées, ce que l’IA, heureusement, nous aide à faire. »

Les experts de Microsoft soulignent que ces méthodes pourront, à terme, soutenir d’autres secteurs : le médical, la biologie, l’étude des matériaux avancés…

À la croisée d’une énergie nouvelle et de l’urgence climatique

Si ITER suscite autant d’intérêt, c’est aussi parce qu’il pourrait offrir un moyen de lutter contre le réchauffement climatique. Son réacteur expérimental vise à produire 500 MW de puissance de fusion durant plusieurs heures, un exploit qui serait un jalon décisif vers le réacteur industriel DEMO, capable à terme d’envoyer cette énergie propre dans le réseau.

Au lieu de casser des atomes lourds comme l’uranium (fission), ITER veut faire fusionner de l’hydrogène, comme dans le Soleil. Tout se joue autour de cette “bouteille magnétique” chargée de maintenir le plasma à distance des parois, et de matériaux capables de résister à la chaleur et aux neutrons.

Le réacteur n’est pas prévu pour alimenter directement les foyers de la région, mais pour prouver la faisabilité de la fusion. Tout se déroule sur un site à la surface gigantesque, où des tours métalliques gigantesques côtoient des installations ultra-sécurisées, sous la vigilance d’inspecteurs formés aux normes nucléaires.

« Nous courons après le temps, avoue Alain Becoulet. Le climat se dégrade, et si la fusion ne décolle pas assez vite, nous perdrons un atout majeur dans le futur mix énergétique. Chaque mois gagné compte. »

Vers de nouvelles étapes

La feuille de route commune comprend déjà un déploiement concret des Copilotes documentaires, la mise en action d’agents intelligents comme Deep Search et Agent Flow, et la modernisation du code scientifique. Tout cela ne signifie pas que Microsoft sera le seul acteur technologique : la fusion, dans l’ADN même d’ITER, est une affaire de collaboration internationale.

Le site de Saint-Paul-lez-Durance, une fois modeste bourg provençal, est devenu l’épicentre d’une collaboration scientifique à grande échelle, où se croisent ingénieurs français et chinois, chercheurs indiens et américains, et même des visiteurs curieux de découvrir cette infrastructure hors du commun. Microsoft, en y apportant ses compétences en IA, y trouve un champ d’exploration à la mesure de ses ambitions.

Pour Alain Becoulet, cette alliance illustre l’approche dont la science a besoin : l’agilité du numérique, un sens aigu de la précision, et l’aspiration à maîtriser l’une des énergies les plus prometteuses de l’univers.

ITER, pour recréer un “mini-Soleil” en Provence

ITER, dont le nom signifie “International Thermonuclear Experimental Reactor”, est un vaste projet situé à Saint-Paul-lez-Durance, au cœur des Bouches-du-Rhône. L’expérience vise à démontrer que la fusion nucléaire, ce phénomène qui fait briller les étoiles, peut être reproduite sur Terre à grande échelle.

Dans la fusion, au lieu de briser des atomes lourds, on fait se heurter des noyaux d’hydrogène à très grande vitesse jusqu’à ce qu’ils s’assemblent. Le défi, immense, consiste à chauffer un plasma à 150 millions de degrés tout en lui épargnant le contact direct avec les parois du réacteur. Pour y parvenir, on le confine dans un champ magnétique si puissant qu’il retient la matière en suspension.

ITER ne sera pas branché sur le réseau électrique. Son rôle est expérimental : produire pendant quelques heures une puissance de 500 MW. Si la démonstration est concluante, la marche suivante s’incarnera dans un réacteur industriel, baptisé DEMO, qui pourrait contribuer à la transition énergétique mondiale.

« Au fond, résume Alain Becoulet, nous entendons apprivoiser la même réaction qui fait flamboyer le Soleil, puis offrir cette source inouïe à l’humanité. La Provence accueille ainsi l’une des plus grandes aventures scientifiques de notre temps. »