Data / IA

Build 2024 : Ce que les DSI doivent retenir des annonces IA

Par Laurent Delattre, publié le 24 mai 2024

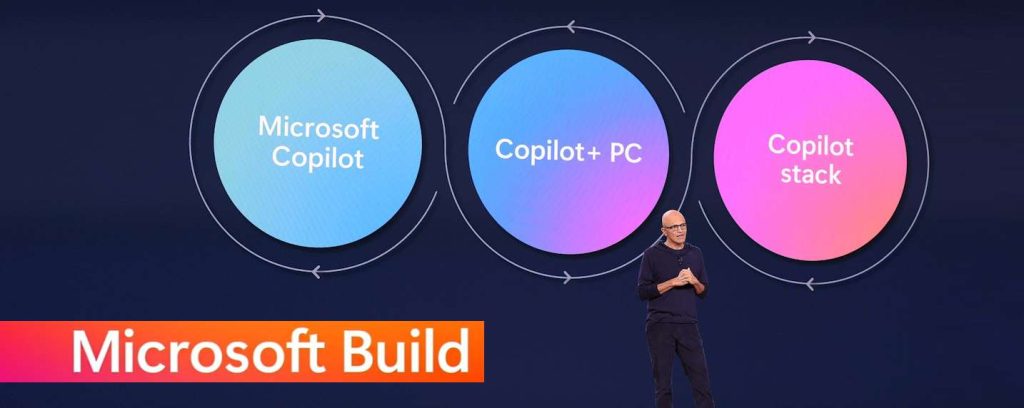

La grande conférence Build 2024 se tenait cette semaine avec sa traditionnelle pluie d’annonces. Voici ce que les DSI doivent retenir des annonces IA de Microsoft alors que ce dernier vient de lancer ses Copilot+ PC et met désormais l’accent sur la fourniture de modèles adaptatifs et d’outils pour aider les entreprises à concrétise les cas d’usage de l’IA.

Microsoft a commencé la semaine en inaugurant une nouvelle ère de Windows et du PC, avec l’annonce des « Copilot+ PC » et d’une version de Windows dotée de fonctionnalités ne fonctionnant que sur ces machines dotées de NPU d’au moins 40 TOPS.

Reste à démontrer le potentiel de ses « Copilot+ PC » et les usages des NPU dans les PC. A défaut de pouvoir encore illustrer l’étendue de ces usages par des apps pratiques, Microsoft s’est évertuée, lors de sa conférence Build 2024, à multiplier les outils, solutions et modèles à même de permettre aux développeurs de concrétiser ces cas d’usage et de démontrer l’intérêt de l’IA au cœur des logiciels et des PC. Sans oublier pour autant le potentiel des IA dans le Cloud et des très nombreux services qu’elle peut et pourra procurer aux entreprises.

Voici un florilège des principales annonces IA de Microsoft à l’occasion de la Build 2024. Nous reviendrons la semaine prochaine, sur les autres annonces Cloud, Windows et Data de cette Build toujours aussi riche en nouveautés, produits et services.

Azure AI Studio enfin disponible

S’il y a un domaine où Google Cloud a réussi à se démarquer sur la concurrence, c’est bien son service de gestion du développement et du déploiement Vertex AI, salué pour son intégration et sa simplicité.

Lors de la conférence Ignite, Microsoft avait lancé une contre-offensive pour remplacer son Azure ML Studio dénommée Azure AI Studio. Ce dernier est désormais en « GA » et accessible à tous.

Ce nouvel environnement GenAIOps & Data-Science, veut inaugurer une nouvelle ère d’efficacité et de simplicité dans le développement d’IA génératives. « Il permet aux développeurs d’explorer, de construire, de tester et de déployer leurs innovations en matière d’IA à grande échelle – en passant plus rapidement de l’idée à l’impact » selon Microsoft. C’est d’abord un environnement MaaS (Model as a Service) qui simplifie l’accès aux derniers modèles fondations pour construire des applications d’IA générative en payant à l’utilisation, sans avoir à gérer l’infrastructure GPU sous-jacente. Mais Azure AI Studio va plus loin. Il permet aux développeurs de choisir ou d’assembler le workflow le plus adapté à leur besoin, de profiter d’une interface visuelle orientée code, d’orchestrer plusieurs API IA, de rendre les modèles interopérables, d’ajuster les modèles en s’appuyant sur les données de l’entreprise sans compromettre leur confidentialité, d’accéder aux derniers outils IA, et de déployer à grande échelle avec une surveillance continue et de débogage en production.

Des modèles, petits et grands

L’IA générative est naissante. Un signe ne trompe pas : chaque semaine on voit apparaître ici et là de nouveaux modèles fondations. Et si les grands modèles continuent d’augmenter leurs capacités multimodales, leurs savoirs et leurs capacités de raisonnement, on assiste également à une multiplication de petits modèles que l’on peut embarquer dans les applications PC, smartphones ou Edge, spécialisés dans des tâches précises et aisément accélérables avec des NPU pour ne pas monopoliser les CPU.

Microsoft continue d’accentuer sa présence sur ces deux axes de développements et a notamment annoncé la mise à disposition de nouveaux modèles pour permettre aux développeurs de rendre leurs applications plus intelligentes et plus multimodales (le texte n’est pas tout).

Commençons par les grands modèles et leur nouvelle star : GPT-4o le nouveau modèle d’OpenAI lancé il y a quelques jours est désormais disponible dans les Azure OpenAI Services sous forme d’API mais également au sein de l’environnement Azure AI Studio. Ce modèle multimodal révolutionnaire intègre le traitement du texte, de l’image et de l’audio au sein d’un seul et même modèle afin d’établir une nouvelle norme pour les expériences d’IA générative et conversationnelle. L’usage d’un modèle unique permet non seulement de gagner en performances de réponse mais aussi en impact de ressource et d’énergie tout en se révélant au final deux fois moins cher pour les clients Azure.

Du côté des petits modèles, les modèles « Phi-3 » arrivent sur Azrue. Les modèles « Phi » sont des petits modèles linguistiques (SLM) et open source créés par Microsoft Research. Ils sont puissants, économiques et optimisés pour les appareils personnels, autrement dit pour un usage local et donc Windows pour Copilot+ PC. La famille des modèles « Phi-3 » (notamment Phi-3-mini, Phi-3-small et Phi-3-médium) est désormais disponible dans l’offre MaaS (Model as a Service) d’Azure.

Surtout, cette famille s’enrichit d’un nouveau modèle multimodal. Avec « Phi-3-Vision » Microsoft démontre à son tour (après Google et son PaliGemma) qu’un SLM est certes petit mais que sa taille ne l’empêche pas d’être multimodal. Phi-3-vision permet de questionner l’IA à partir d’images et de texte et de recevoir des réponses textuelles. Par exemple, les utilisateurs peuvent poser des questions sur un graphique ou poser une question ouverte sur des images spécifiques.

Team Copilot : Un Copilot pour chaque équipe

Microsoft élargit les capacités de Copilot for Microsoft 365, la version la plus évoluée et la plus complète (mais aussi la plus onéreuse) de son assistant personnel IA, pour en faire un membre à part entière des équipes collaboratives. Sous le nom de Team Copilot (à ne pas confondre avec Copilot for Teams), cette nouvelle expérience utilisateur sera intégrée aux outils de travail en équipe de Microsoft 365, tels que Teams, Loop et Planner. Team Copilot pourra dès lors endosser différents rôles au sein de votre équipe humaine : animateur de réunions, collaborateur dans les conversations, ou encore gestionnaire de projets. Son objectif sera d’optimiser la communication et la coordination au sein des équipes en s’appuyant sur les capacités de synthèse et d’analyse de l’IA générative.

Disponible en préversion plus tard dans l’année, Team Copilot marquera une nouvelle étape dans l’innovation, où l’IA devient un acteur proactif au service des individus et des équipes.

Personnaliser modèles et copilotes

Comment répondre vraiment au besoin des entreprises en adaptant les modèles fondation à leurs exigences spécifiques, leur culture, leur vocabulaire ?

C’est désormais le cœur de la problématique IA en entreprise maintenant que les ChatGPT, Gemini, Adobe Firefly, Mistral LeChat et autre ClaudeAI ont popularisé le potentiel de l’IA générative et des LLMs.

Désormais, les Azure OpenAI Services, vous laisse ajuster / fine-tuner les modèles proposés. Il suffit de leur faire absorber des documents significatifs dans la limite de leur fenêtre contextuelle.

Mais Microsoft va plus loin. L’éditeur a annoncé la disponibilité prochaine en Preview des « Custom Generative Models » dans Azure AI. À l’aide d’Azure AI Studio et à partir d’un seul document représentatif, avec un minimum d’étiquetage, ces modèles pourront être très finement personnalisés. Plus besoin de faire appel à des experts en développement ou en data science. Les modèles de langage avancés (LLM) extraient les champs pertinents, et les utilisateurs corrigent les sorties si nécessaire. Le modèle s’améliore continuellement en s’adaptant à chaque nouvel échantillon qu’on lui soumet. Cette avancée permet aux entreprises de créer des solutions d’IA sur mesure, parfaitement adaptées à leurs besoins, quel que soit leur secteur d’activité. Les modèles “custom generative” d’Azure AI révolutionnent ainsi la façon de travailler avec l’IA et libèrent enfin le plein potentiel de vos propres données.

Copilot Studio : Des copilots personnalisés et des agents à votre service

À Build 2024, Microsoft a plus que jamais transformé son assistant Microsoft Copilot en véritable plateforme et rattrape l’écart de fonctionnalités que sépare son IA de ChatGPT.

À Ignite, Microsoft avait lancé Copilot Studio, une Web App combinant les fonctions plugins et GPTs de ChatGPT pour personnaliser « Copilot for Microsoft 365 » au travers d’une interface no-Code.

Microsoft fait évoluer l’expérience Copilot en unifiant tous les concepts d’extensibilité, y compris les plugins et les connecteurs, en une seule construction appelée “Copilot Extensions“. Cette innovation vise à améliorer Microsoft Copilot pour le rendre plus adapté à vos contextes et vos connaissances tout en lui permettant de réaliser de nouvelles actions. Microsoft Copilot peut ainsi être adapté à vos données, systèmes et workflows. Grâce à Microsoft Copilot Studio ou à Microsoft Teams Toolkit pour Visual Studio Code, les développeurs pourront créer des extensions Copilot intégrant des applications de premier plan telles que Jira, Priority Matrix et Mural, actuellement disponibles en preview pour Copilot dans Microsoft 365, ainsi que des extensions Copilot spécifiques à l’entreprise. Les administrateurs informatiques auront la possibilité de contrôler et gérer l’accès aux extensions via le centre d’administration Microsoft 365. Par ailleurs, les développeurs vont pouvoir intégrer des plugins pour appeler leurs propres API permettant ainsi à Copilot de s’interfacer avec leurs services mais aussi de collaborer avec d’autres assistants IA.

En outre, les extensions Copilot construites avec Copilot Studio permettront aux développeurs de personnaliser les copilots avec des instructions, des connaissances provenant de sources de données et des actions à partir de plugins, de flux Microsoft Power Automate, et plus encore. Elles seront simples à construire et permettront l’extensibilité et la personnalisation pour des domaines ou des personas spécifiques, offrant ainsi une expérience copilot plus pertinente et personnalisée. Ces extensions seront publiées via le Copilot Partner Center et son magasin d’apps ainsi que via le Store de Microsoft 365.

Microsoft Copilot Studio intégrait déjà l’ancienne fonctionnalité Power Virtual Agent. Désormais, l’outil accroit davantage ses capacités de conception « d’agents virtuels Copilot ». Les agents virtuels de support ou de vente peuvent désormais réagir de manière proactive aux données et aux événements. C’est essentiel pour les rendre plus autonomes. Ainsi, les « Copilot Agents » pourront bientôt être utilisés comme des employés virtuels que les entreprises pourront affecter à des tâches subalternes et répétitives telles que l’exécution de tâches semi-automatisées, l’aide à la saisie de données, l’accompagnement à l’intégration des employés ou même la surveillance des e-mails, sans qu’il soit nécessaire de leur demander explicitement de le faire. Les Copilot Agents développés pourront désormais gérer de manière autonome des processus métier complexes et de longue durée en s’appuyant sur leur capacité de mémorisation et leurs connaissances afin de contextualiser, raisonner sur les actions et les entrées, apprendre en fonction des retours des utilisateurs. De tels Copilot Agents sauront même demander de l’aide lorsqu’ils rencontrent des situations qu’ils ne savent pas gérer.

Pas de cas d’usage IA sans partenariats

À l’occasion de la Build, Microsoft s’est beaucoup appuyée sur ses partenaires pour montrer comment l’IA peut influer sur l’avenir d’une myriade d’industries, y compris l’éducation.

Et l’éditeur a annoncé deux nouveaux partenariats.

Le premier avec Cognition. Microsoft va désormais proposer sur ses plateformes l’agent logiciel de Cognition, nommé Devin. Devin est un « ingénieur logiciel » virtuel. Il peut aider les IT et les développeurs dans des tâches complexes telles que les projets de migration et de modernisation de code. Devin peut coder, déboguer et même développer des applications et des sites web de manière autonome. Il peut aussi trouver et corriger des bugs. Dans le cadre de cet accord, Devin sera hébergé et animé par Azure.

Le second avec Khan Academy pour explorer comment les IA peuvent révolutionner l’enseignement et aider les enseignants (notamment de mathématique) à délivrer des formations accessibles et adaptées à tous les niveaux. L’accord prévoit également d’offrir gratuitement à tous les enseignants du primaire et du secondaire aux États-Unis l’accès à Khanmigo pour les enseignants. Khanmigo est un assistant d’enseignement dopé à l’IA qui libère du temps pour les enseignants afin qu’ils puissent se concentrer sur ce qui est le plus important – interagir avec et soutenir leurs élèves. Dans le cadre de cet accord, Microsoft fait don de l’accès à l’infrastructure Azure afin d’augmenter la disponibilité de Khanmigo pour les enseignants et l’enrichir des services Azure OpenAI.

Comme on le voit, Microsoft cherche à industrialiser un peu plus ces IA en simplifiant l’accès à leur potentiel mais aussi en facilitant la personnalisation et la transformation de ses modèles et de ses Copilots. Avec d’un côté la volonté d’utiliser le cloud pour faciliter le partage et l’accessibilité des grands modèles, mais aussi celle d’exploiter le potentiel croissant des petits modèles pour une intégration dans les logiciels Windows, les smartphones et les dispositifs Edge. Une Build 2024 qui aura surtout conforté tous les DSI dans l’idée que nous n’avons jusqu’ici de gratter la surface du potentiel de l’IA et que tous ses usages restent encore à inventer. Au moins, désormais, les entreprises disposent d’outils simples et accessibles pour passer à la pratique.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :