Data / IA

Ce qu’il faut retenir des annonces IA d’Oracle Cloud

Par Laurent Delattre, publié le 24 janvier 2024

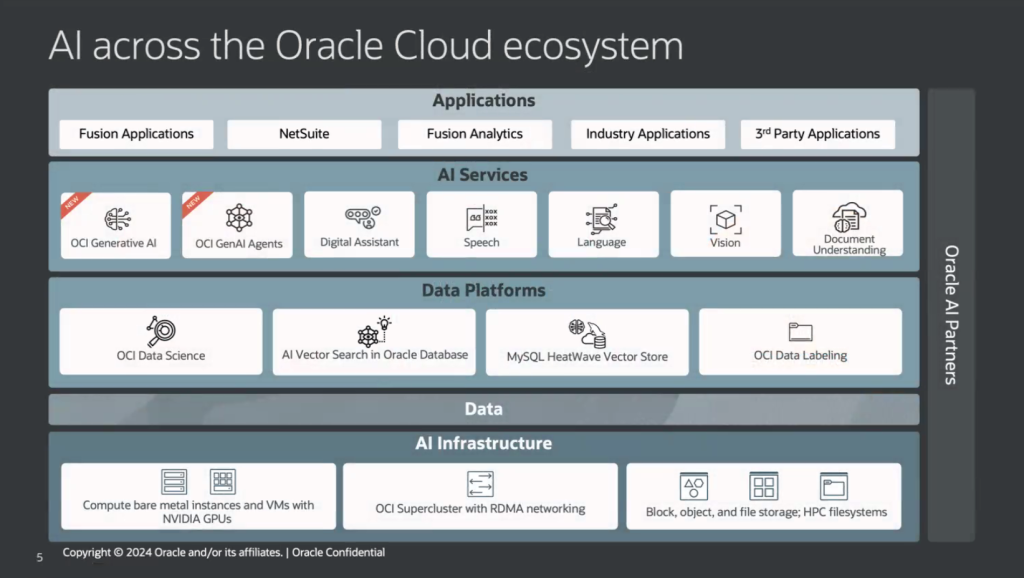

Lancé dans une course de fond pour rattraper les pionniers AWS, Google et Microsoft, Oracle Cloud officialise à son tour ses services dédiés à l’IA générative (OCI Generative AI) pour simplifier le travail d’intégrations des IA dans leurs processus et applications métiers des entreprises.

Oracle Cloud avait dévoilé sa stratégie en matière d’IA générative à l’occasion de son évènement CloudWorld 2023. Une annonce accompagnée de premiers services en bêta et de la mise à disposition d’une infrastructure « OCI supercluster » permettant de déployer jusqu’à 32.000 GPU NVidia H100 au sein d’un réseau RDMA à très faible latence pour entraîner des modèles.

Cette semaine, Oracle a officialisé la disponibilité générale des services en Beta présentés à CloudWorld. Mais l’hyperscaler a surtout lancé en preview un ensemble d’autres services IA pour lui permettre de rattraper son retard en la matière sur les 3 géants américains : Azure avec ses OpenAI Services, Copilot Studio et Azure AI Studio, Google Cloud avec son service Vertex AI et son Gen App Builder, AWS avec BedRock et .

Des modèles multilingues partagés ou sur clusters dédiés

Le cœur de l’offre OCI Generative AI repose sur l’exposition de modèles LLMs sous forme d’API pour en permettre un appel simplifié depuis les processus et applications de l’entreprise afin d’enrichir les expériences utilisateurs et concrétiser de nouveaux cas d’usage. OCI offre également la consommation de ces modèles depuis un CLI, depuis un SDK OCI et depuis le populaire framework LangChain.

Si Google Cloud s’appuie sur ses modèles maison Gemini et si Azure bénéficient de ceux d’OpenAI, Oracle a choisi d’exposer le modèle open source LLama 2 70B de Meta et les modèles commerciaux de Cohere (Command XL 52B, Command Light 6B, Embed).

Et pour convaincre les entreprises, Oracle met en avant la simplicité de ses API, une tarification agressive et simplifiée (consommation mesurée au caractère plutôt qu’au fumeux concept de tokens) et bien évidemment la forte intégration avec les services et applications Oracle.

OCI propose également d’exploiter ces modèles non plus au travers de l’offre managée et partagée mais sur des clusters IA dédiés. Cette offre présente plusieurs avantages. D’abord, les modèles peuvent être « fine-tunés » (finement réglés) pour optimiser leur fonctionnement à vos besoins. Ensuite, la sécurité et la confidentialité des données sont davantage sous le contrôle de votre entreprise. Enfin, le déploiement se fait sur un ‘tenant’ unique où les GPU du cluster n’hébergent que vos modèles. « Le point de terminaison du modèle n’étant pas partagé, le débit du modèle est constant et la taille minimale du cluster est plus facile à estimer sur la base du volume d’appels prévu » explique l’éditeur. Du coût le coût d’exploitation de l’IA en devient plus prévisible. Dans ce mode dédié, les échanges ne sont plus facturés au caractère. Vous payez à l’heure en fonction du type et du nombre d’unités de cluster sélectionnés à la création du cluster IA dédié.

Le « fine tuning » sur les clusters dédiés permet d’optimiser les modèles fondation Command XL et Command Light de Cohere pour une tâche spécifique. Deux stratégies de personnalisation des LLM sont proposées : T-Few (qui permet d’ajuster les poids d’une fraction du modèle au lieu de relancer un apprentissage intégral) ou Vanilla (qui permet d’ajuster les 25 derniers pourcents des couches de poids du modèle pour produire un modèle plus profondément entraîné sur vos données). On retrouve ici les deux techniques proposées par Cohere notamment dans son implémentation sur l’AWS Marketplace. La technique « T-Few » permet à l’entreprise d’exploiter 50 modèles personnalisés sur une même fondation et donc un même cluster IA. La technique « Vanilla » restreint l’hébergement d’un seul modèle personnalisé par cluster IA.

Il est important de signaler qu’OCI Generative AI n’est pour l’instant disponible que sur la région US « ORD » d’OCI, mais Oracle promet d’augmenter sa couverture régionale dans « les prochaines semaines ».

À LIRE AUSSI :

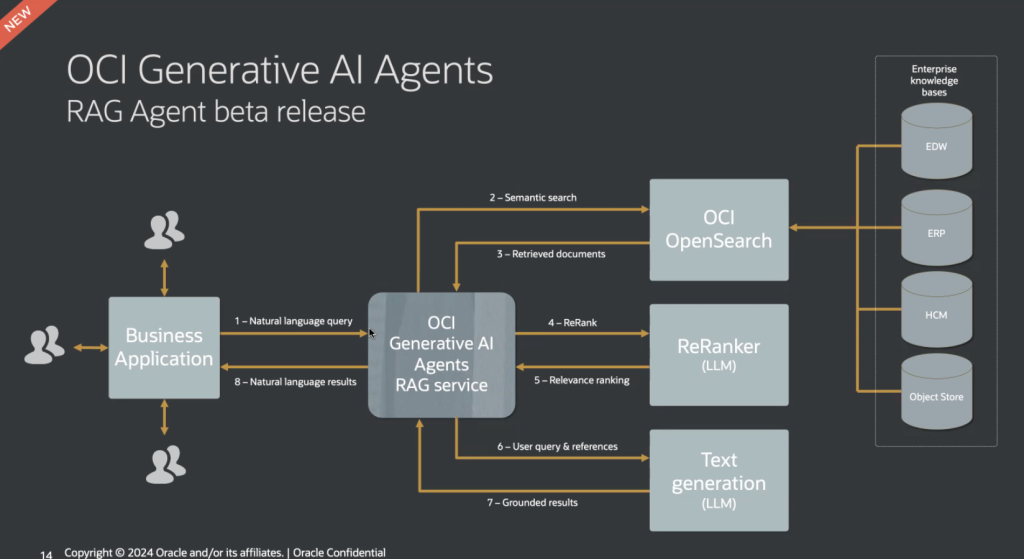

Des agents et du RAG

Par ailleurs, Oracle Cloud a également annoncé en preview un service « Generative AI Agents » dont la première concrétisation est un agent RAG (Retrieval-augmented generation) pour permettre aux différents services d’une entreprise de converser avec leurs bases de connaissance.

Plus concrètement, le service permet de rattacher un modèle LLM à des sources de données de l’entreprise de sorte que les collaborateurs puissent converser très naturellement avec l’IA, poser des questions et obtenir des informations pertinentes assemblées depuis les sources vectorisées (données provenant de l’ERP, du HCM, de data lakes…). Les utilisateurs n’ont pas besoin de savoir où sont les données, il leur suffit d’interagir avec l’IA en langage naturel. Pour l’instant la solution repose sur OCI OpenSearch (fork d’ElasticSearch) mais devrait à terme exploiter les moteurs de recherche vectorielle d’Oracle Database 23c et MySQL HeatWave.

D’autres agents devraient rapidement voir le jour avec une volonté d’en faire des intermédiaires intelligents capables de convertir les interrogations en langage naturel des utilisateurs en tâches spécifiques.

OCI Quick Actions : vélocité et simplicité

Oracle Cloud a lancé il y a quelques mois sa plateforme managée OCI Data Science pour aider développeur et data-scientists à collaborer, construire, entraîner, déployer et gérer des modèles ML à l’aide de Python et divers frameworks et outils open source. La plateforme entre typiquement en concurrence avec AWS SageMaker, Azure AI Studio et Google Cloud Vertex AI.

Cette semaine, l’éditeur a annoncé le lancement prochain de « AI Quick Actions » pour sa plateforme Data Science. Ces « actions rapides » permettent de déployer des modèles réputés de l’univers open source (LLama 2, Mistral 7B, etc.) très facilement et sans expertise technique grâce à une approche « no-code » et une interface conviviale. Ces modèles sont prétestés et optimisés pour l’infrastructure OCI. Les AI Quick Actions cherchent à démocratiser un peu plus l’accès aux modèles IA et rationaliser les modèles Workloads en simplifiant au maximum les étapes et en automatisant l’intégration des fonctionnalités de télémétrie, de visualisation, de navigation, etc.

L’atout prix… la personnalisation en plus…

Au final, toutes ces annonces permettent à Oracle Cloud de s’aligner, dans les grandes lignes, avec les offres IA génératives des 3 leaders de cloud. L’offre s’appuie sur les leviers traditionnels qui démarquent OCI à savoir son infrastructure très automatisée et simple d’accès, la forte intégration à son univers applicatif Fusion Cloud et surtout des tarifs très concurrentiels. Toutes ces annonces démontrent aussi une certaine volonté de bâtir un socle IA solide qui puisse à la fois satisfaire les besoins de ses clients (et notamment des grandes organisations) et ses propres besoins car il paraît évident que l’IA générative sera de plus en plus intégrée aux cœurs des solutions métiers d’Oracle.

Reste que la concurrence est rude et qu’Oracle doit se reposer sur des modèles fondation d’autres acteurs qui n’ont pas (encore ?) l’aura et la pertinence d’un GPT-4 Turbo ou d’un Gemini Ultra. Néanmoins, les options proposées par OCI pour finement régler les modèles de Cohere vont permettre aux entreprises de développer des IA très pertinentes pour leurs besoins métiers avec un maximum de contrôle sur les données et les usages…

À LIRE AUSSI :

À LIRE AUSSI :