Data / IA

ChatGPT serait plus beau parleur que bon développeur ?

Par Thierry Derouet, publié le 26 septembre 2023

Faut-il ou non faire confiance à une IA générative pour ses développements ? Une étude révèle que 52 % des réponses fournies par ChatGPT auprès d’une population de développeurs sont beaucoup trop imprécises. ChatGPT est-il trop beau parleur pour un usage en entreprise ?

Selon une étude publiée par Workday menée auprès de 1 000 décideurs d’entreprises du monde entier, « 73 % [74 % en France, NDLR] des dirigeants d’entreprise se sentent contraints de mettre en oeuvre l’IA dans leur organisation ».

Mais selon GetApp, ils sont aussi 70 % à estimer que « leurs équipes ne sont pas suffisamment qualifiées ».

Impression confirmée par leurs responsables informatiques qui disent à 65 % « ne pas être prêts à mettre en oeuvre de l’IA générative ».

Pourtant, pas un jour ne se passe sans que les acteurs de l’IT, ESN et éditeurs en tête, n’invitent à basculer vers des solutions d’IA. Ainsi, Sopra Steria suggère une « intégration rapide des technologies d’IA dans tous les métiers de l’ingénierie logicielle afin d’optimiser le développement et la maintenance des logiciels », tout en encourageant « la vérification des conformités éthiques et réglementaires nécessaires à la mise en oeuvre de solutions d’IA ».

Encore faudrait-il qu’un ChatGPT, ou toute autre IA basée sur de grands modèles de langage (LLM), n’« hallucine » pas – expression singulière qui ne doit pas occulter qu’une IA procède de l’analyse statistique et non de la recherche d’une certaine forme de véracité.

C’est ce que nous rappelle une étude publiée par quatre jeunes étudiants chercheurs de l’Université Purdue de West Lafayette aux États-Unis qui ont comparé, dans le domaine de l’ingénierie logicielle, 517 réponses humaines à celles de ChatGPT aux questions de Stack Overflow. Les conclusions de cette étude sont sans appel : « Notre examen a révélé que 52 % des réponses de ChatGPT contiennent des inexactitudes et que 77 % sont trop vagues. Ces résultats soulignent la nécessité d’une correction méticuleuse des erreurs dans ChatGPT, tout en sensibilisant les utilisateurs aux risques associés à des réponses apparemment exactes. »

À LIRE AUSSI :

Pour examiner comment les caractéristiques linguistiques des réponses générées par ChatGPT diffèrent des réponses humaines, une analyse linguistique approfondie a été menée conjointement.

Il apparaît que ChatGPT utilise un langage plus formel et analytique, et exprime moins de sentiments négatifs.

Dans cette étude, douze programmeurs ont été bernés par 39 % des réponses de ChatGPT au seul motif que les caractéristiques linguistiques plus riches des réponses les ont conduits à négliger les inexactitudes et incohérences sous-jacentes.

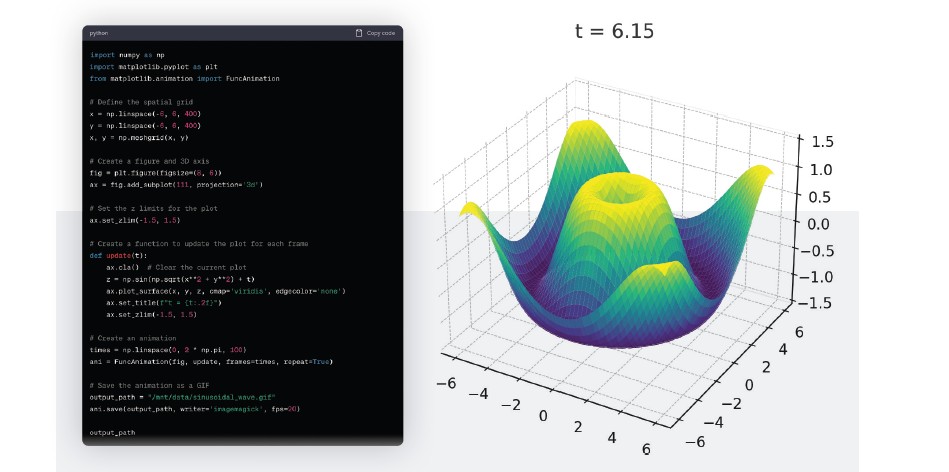

Si une IA générative est enfermée dans un monde fini – tout l’inverse des mathématiques –, des options comme Advanced Data Analysis, disponible avec la version 4 – donc payante – de ChatGPT ouvre d’autres horizons. Il est ainsi possible, à partir de tous types de fichiers, d’alimenter ChatGPT avec des données et de lui demander également de résoudre une équation ou d’afficher des courbes, par exemple sous forme d’un gif animé. Trouverez-vous le prompt que nous avons rédigé pour obtenir ce code python et cette courbe ?

ChatGPT serait ainsi accusé de leurrer son monde grâce à la qualité linguistique de ses réponses, même si d’aucuns disent que ses réponses manquent souvent « d’un petit supplément d’âme ».

Marie Fontaine, AI lead consultant chez WEnvision, a même noté que certains développeurs restaient réticents face à des IA génératives. Mais pas forcément pour le bon motif : « Ne suis-je pas là en train d’entraîner la machine qui va supprimer mon poste ? »

Pour l’heure, on aimerait effectivement que les IA – qui sont loin d’être des baguettes magiques – baratinent moins. J’hallucine aussi ?

Vers des IA remodelées à vos données

Le problème des études ci-dessus, c’est qu’elles sont toutes réalisées avec ChatGPT qui reste un modèle fondation sans véritable connaissance du contexte de l’entreprise.

Ces résultats doivent ainsi encourager les entreprises à reproduire le même genre de tests non plus sur Bard ou ChatGPT mais avec des IA génératives remodelées avec leurs propres jeux de données (ou leurs propres codes sources dans le cas des IA génératives de code).

Ce qui est désormais rendu possible au travers :

– des solutions Chatbot “next gen” de Google et Microsoft,

– de reparamétrages de modèles LLM (Azure OpenAI Services, AWS BedRock, Google Vertex AI),

– de solutions open source comme LangChain (pour associer un LLM à vos données),

– d’un entraînement de modèles open source avec vos données (soit en interne soit via les services des Clouds),

– de nouvelles offres IA “Entreprise” comme Microsoft 365 Copilot (disponible à partir du 1er novembre) et Google Duet AI For Workspace.

Si la première partie de l’année a été dominée par les premiers usages des IA génératives, la deuxième partie de l’année devrait ainsi être animée par les retours d’expérience des entreprises ayant utilisé ces IA remodelées à leurs jeux de données.

À LIRE AUSSI :

À LIRE AUSSI :