Data / IA

De l’AGI à la Super-Intelligence : OpenAI redéfinit ses ambitions

Par Laurent Delattre, publié le 08 janvier 2025

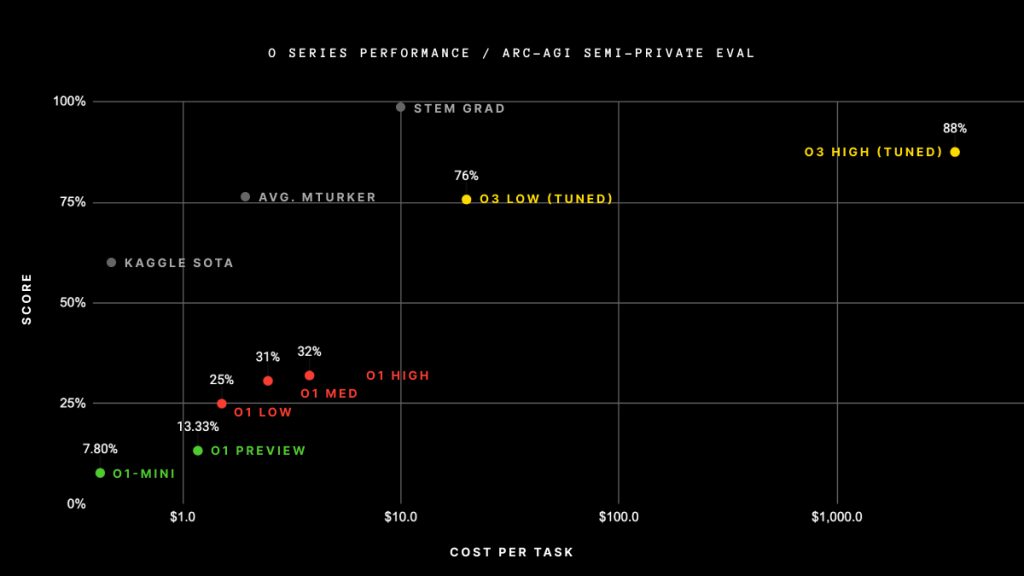

En atteignant des performances inédites sur le test ARC-AGI-1, le modèle « o3 » d’OpenAI redéfinit les perspectives autour de l’AGI et propulse les ambitions vers la super-intelligence. Cependant, ces résultats prometteurs s’accompagnent de limitations techniques et financières qui soulignent l’urgence d’établir des cadres de développement responsable plus aboutis.

Sans vraiment en avoir l’air, OpenAI est en train de relancer le débat sur l’intelligence artificielle générale (AGI), son objectif avoué depuis sa création, grâce à son nouveau modèle à raisonnement baptisé « OpenAI o3 ». Selon la startup, ce modèle, dévoilé fin décembre et encore en phase d’évaluation et de tests de sécurité, aurait déjà surpassé la performance de la plupart des humains, du moins sur le test de référence ARC-AGI (version 1), devenant ainsi le premier système à atteindre le seuil théorique de l’AGI. Bien que les scores de « o3 » sur ARC-AGI (version 2, encore en cours de formalisation) ne soient pas tout à fait au même niveau, les progrès apparaissent, selon Sam Altman, PDG d’OpenAI, suffisamment significatifs pour qu’il déclare désormais viser la « super-intelligence ». Un concept qui dépasse largement l’AGI telle qu’on la définit aujourd’hui.

Un jalon important : la réussite au test ARC-AGI

Créé par François Chollet, le test ARC-AGI-1 (Abstract and Reasoning Corpus for Artificial General Intelligence) évalue la capacité d’une IA à raisonner de manière flexible et à s’adapter à des tâches inédites. Consistant à identifier des motifs et à résoudre des puzzles basés sur des exemples donnés, cet ensemble de tests cherche à mesurer la capacité d’une IA à acquérir de nouvelles compétences et à résoudre des problèmes ouverts de manière efficace. Sa particularité est notamment de proposer des exercices faciles pour les humains mais typiquement complexes pour les IA actuelles. Les créateurs de ce benchmark estiment qu’un score de 85 % marque le seuil de l’intelligence artificielle générale (AGI), la majorité des humains parvenant en moyenne à résoudre 80 % de ces problèmes.

Dans un post blog publié fin décembre, François Chollet confirme que le modèle o3 d’OpenAI a bien dépassé ce cap et atteint la note de 87,5% !

Deux bémols cependant. D’abord, pour atteindre ce score, le modèle « o3 » a dû être utilisé dans son mode « High Compute », avec un coût d’exécution total du test dépassant largement plusieurs centaines de milliers de dollars ! En mode « Low Compute », le modèle n’atteint qu’un score de 75,7 %, pour un coût d’exécution qui s’élève tout de même à 2 000 dollars. Ensuite, François Chollet reconnaît que « o3 » échoue encore sur des tests triviaux pour les humains.

On peut également ajouter un troisième bémol : le créateur principal de ce test admet que le futur benchmark ARC-AGI-2 pose des difficultés significatives au modèle « o3 », qui, pour l’instant (et de manière non officielle, le benchmark n’étant pas finalisé), n’atteint qu’un score de 30 %, là où des humains un peu futés obtiennent en moyenne 95 %.

Néanmoins, ces résultats significatifs (après tout, le modèle GPT-4o atteint péniblement les 5% sur ARC-AGI-1) suscitent déjà un engouement considérable dans la communauté de la recherche en IA.

Des ambitions qui vont au-delà de l’AGI

Dans une récente publication de blog, Sam Altman a déclaré : « Nous sommes maintenant convaincus que nous savons comment construire l’AGI telle que nous l’avons traditionnellement comprise. » Dès lors, il explique même n’avoir guère de doute sur le fait que « des agents IA » pourront vraiment intégrer le monde du travail dès 2025 et bouleverser la productivité des entreprises.

Une façon aussi pour lui, de redéfinir les ambitions de sa startup qui jusqu’ici tenait un discours assez focalisé sur l’AGI. Ainsi, la véritable ambition d’OpenAI serait désormais de passer rapidement à la « super-intelligence », autrement dit une IA dépassant largement les capacités cognitives humaines. Altman se dit conscient du caractère « fou » que cela peut sembler revêtir ; selon lui, « des outils super-intelligents pourraient accélérer massivement les découvertes scientifiques et l’innovation bien au-delà de ce que nous sommes capables de faire par nous-mêmes. »

Ainsi, si l’AGI est généralement perçue comme une forme d’intelligence comparable à celle d’un humain, la « super-intelligence » évoque un système IA aux aptitudes intellectuelles qui nous dépassent de loin.

Sam Altman rappelle toutefois la nécessité de faire preuve de prudence : « Nous sommes assez confiants que dans les prochaines années, tout le monde verra ce que nous voyons, » ajoutant que ces développements doivent s’effectuer « with great care » (avec le plus grand soin) pour maximiser leurs bénéfices et surtout éviter tout dérapage.

Il se pourrait même qu’il soit bien plus long de tester et contrôler une telle IA avant de la déployer que de la développer ! Après tout, OpenAI vit déjà comme un défi notable l’évaluation de son futur modèle « o3 ». Déjà opérationnel depuis plusieurs semaines, l’éditeur a ressenti le besoin de multiplier les tests et le nombre de testeurs. La startup a ainsi ouvert des candidatures (qui sont triées sur le volet) et en accepte encore jusqu’au 10 janvier pour expérimenter o3 en avant-première. L’idée reste d’appréhender au mieux les risques et de mettre en place des garde-fous avant une intégration plus large.

Reste qu’OpenAI et son CEO semblent convaincus d’avoir déjà atteint l’AGI et finalement de pouvoir « relativement » arriver rapidement à la super-intelligence — un changement potentiellement aussi crucial qu’historique. Tout est dans le « relativement ». OpenAI a eu besoin de 10 ans (elle a commencé en 2015) pour passer de rien à l’AGI. Il pourrait falloir moins de temps pour passer de l’AGI à la « super-intelligence ». Sam Altman reconnaît cependant que « il y a encore tellement de choses à comprendre, encore tant de choses que nous ne savons pas, et il est encore si tôt. Mais nous en savons beaucoup plus que lorsque nous avons commencé. »

À LIRE AUSSI :

À LIRE AUSSI :