Cloud

Des datacenters bientôt en rupture d’électricité ?

Par Laurent Delattre, publié le 15 janvier 2025

La consommation énergétique des centres de données explose, portée par l’IA et le cloud, tout en mettant sous tension des réseaux électriques déjà fragilisés. Pour pallier ces défis et éviter la rupture des flux d’énergie, les hyperscalers misent sur la fusion nucléaire et les infrastructures vertes, tout en réinventant l’efficacité énergétique de leurs datacenters. Un nouveau rapport de JLL Research fait le point de la situation en 2025.

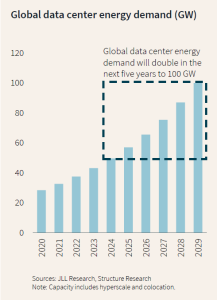

Le secteur des centres de données connaît une transformation rapide, stimulée par l’essor de l’intelligence artificielle (IA) et la demande croissante en puissance de calcul. Selon le rapport « 2025 Global Data Center Outlook » de JLL Research, le marché mondial des centres de données devrait ainsi enregistrer une croissance annuelle de 15 % à 20 % jusqu’en 2027.

Des chiffres alignés sur ceux du ministère de l’Énergie américain qui a récemment révélé que la consommation énergétique des data centers aux US a augmenté de 7 % de 2014 à 2018, puis de 18 % entre 2018 et 2023 et prévoit une augmentation entre 13 % et 25 % d’ici 2028.

Cette croissance fulgurante s’explique principalement par l’essor de l’intelligence artificielle (IA) et la montée en puissance des services en cloud.

Cette trajectoire inquiète de plus en plus le secteur de l’énergie : certains spécialistes craignent que, d’ici 2027, la moitié des nouveaux serveurs IA ne dispose pas de l’alimentation requise pour fonctionner pleinement.

Pour autant, le rapport JLL annonce des chiffres dans la fourchette basse des estimations généralement véhiculées par les médias. Ainsi, les centres de données devraient représenter environ 2 % de la consommation mondiale d’énergie en 2025. C’est beaucoup, mais c’est moins que les 4 % généralement avancés.

Reste que ce chiffre mondial ne veut pas dire grand-chose et cache d’immenses disparités selon les régions. D’ailleurs, le ministère de l’énergie américain anticipe déjà que la consommation énergétique des data centers US pourrait représenter jusqu’à 12 % de l’approvisionnement énergétique total des États-Unis d’ici la fin de la décennie (2030) !

Des datacenters trop regroupés

Le problème principal actuel soulevé par le rapport, c’est la multiplication des goulets d’étranglement dans la transmission d’énergie. Ces défis sont exacerbés par la tendance des centres de données à se regrouper dans des clusters géographiques spécifiques, souvent près des sources d’énergie ou dans des hubs technologiques bien établis. Les opérateurs de réseau, généralement habitués à prévoir la demande électrique sur des décennies, peinent à faire face à l’explosion quasi exponentielle des besoins. Des zones comme la Virginie du Nord (États-Unis), Londres (Royaume-Uni) et Tokyo (Japon) sont des exemples typiques de marchés saturés. À titre d’exemple, en Irlande, les centres de données consomment environ 21 % de l’électricité nationale, et en Virginie, ils représentent 26 % de la demande énergétique de l’État. Cette concentration perturbe la capacité des réseaux locaux à s’adapter à la croissance rapide de la demande.

Dans ces régions, la densité des installations provoque des retards dans la livraison d’électricité aux nouveaux projets. Des retards qui peuvent aller jusqu’à 4 ans ! Ces délais sont principalement dus à des obstacles réglementaires, à des problèmes d’acquisition de terrains pour les lignes électriques (droits de passage) et à des processus d’approbation longs. Ils sont également aggravés par une production et livraison de composants essentiels – tels que les transformateurs et les équipements de commutation – confrontée à des problèmes de chaîne d’approvisionnement.

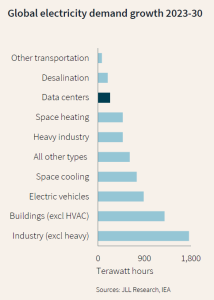

Des réseaux qui ne peuvent satisfaire la demande

Les réseaux électriques traditionnels, déjà soumis à des demandes croissantes pour d’autres usages, comme les véhicules électriques (VE) et le chauffage, peinent de plus en plus à répondre aux besoins spécifiques et exponentiels des centres de données. À cela s’ajoute une autre dynamique complexe : le décalage entre le rythme effréné de l’industrie numérique et la lenteur relative des projets de production et de transmission d’énergie.

Construire et mettre en service une centrale électrique de grande envergure peut prendre plusieurs années, en raison des processus d’autorisation, des contraintes d’approvisionnement en matériel et des complexités logistiques. Même les initiatives visant à accélérer l’adoption des énergies renouvelables, comme le solaire ou l’éolien, se heurtent à des défis d’interconnexion. Ces sources, bien qu’elles soient souvent plus rapides à déployer, nécessitent des infrastructures robustes pour acheminer l’électricité produite vers les centres de consommation. Or, les délais pour la construction ou la mise à niveau des lignes de transmission peuvent s’étendre sur plusieurs années, exacerbant les goulets d’étranglement.

De plus, les réseaux électriques doivent répondre à une demande non seulement croissante, mais également fluctuante, notamment dans les centres dédiés à l’entraînement de modèles IA. Ces installations, capables de consommer des quantités massives d’électricité en un temps réduit, nécessitent une flexibilité et une réactivité que les infrastructures actuelles peinent à offrir. Cette imprévisibilité complique encore la planification des investissements dans les infrastructures énergétiques.

Les hyperscalers en quête de solutions

Face à la pression croissante sur les réseaux énergétiques et aux défis environnementaux, les hyperscalers explorent de nouvelles pistes pour répondre à leurs besoins énergétiques colossaux. Dominant le marché des centres de données, elles se tournent vers des alternatives durables, comme les réacteurs nucléaires modulaires (SMR) et les énergies renouvelables pour garantir un approvisionnement fiable et réduire leur empreinte carbone. Les SMR, bien que toujours en phase de développement, promettent une production d’énergie verte modulable et adaptée à leurs besoins.

Parallèlement, la demande pour des installations spécifiques à l’entraînement et à l’inférence des modèles IA les conduit de plus en plus à séparer les centres de données pour l’IA (afin de les rapprocher des sources d’énergie) des autres centres de données Cloud (qui sont situés près des utilisateurs finaux).

Enfin, les hyperscalers investissent dans des partenariats stratégiques avec des opérateurs énergétiques et signent des accords d’achat d’énergie à long terme (PPA) pour sécuriser des ressources durables.

Microsoft soutient la relance d’un réacteur nucléaire à la tristement célèbre (et à l’arrêt depuis plus d’une décennie) centrale Three Mile Island en partenariat avec le fournisseur Constellation. Parallèlement, la firme a signé un accord avec Helion Energy pour construire une centrale de fusion nucléaire d’ici 2028 dans l’état de Washington.

Google s’est engagé dans des projets solaires et éoliens totalisant plus de 20 milliards de dollars afin d’alimenter plusieurs vastes complexes de serveurs. La firme a également conclu un accord avec la start-up Kairos pour 500 MW d’électricité décarbonée d’ici la fin de la décennie.

Amazon/AWS envisage de construire des réacteurs modulaires en Virginie et dans l’État de Washington et soutient des projets de fusion nucléaire avec General Fusion en Colombie-Britannique.

Parallèlement, ces hyperscalers multiplient aussi les initiatives pour optimiser leur consommation énergétique et leur impact carbone. Ils ont commencé à généraliser le refroidissement liquide dans tous les datacenters dédiés à l’IA et ont développé leurs propres NPU basse consommation.

Amazon utilise déjà l’hydrogène pour alimenter certains équipements, et Microsoft a testé avec succès un générateur à grande échelle fonctionnant avec des piles à hydrogène. Les pistes de recherche sont nombreuses. Et Amazon dispose d’un datacenter affichant un PUE record de 1,04 ! Toute la difficulté de ses recherches et expérimentations est de pouvoir ensuite les passer à l’échelle.

Le défi consiste donc désormais à concilier la localisation des sites et l’implantation des installations énergétiques. Même les réacteurs nucléaires de nouvelle génération, plus compacts, suscitent des interrogations quant à leur implantation en milieu urbain. De leur côté, les énergies renouvelables requièrent des surfaces considérables et des lignes de transport supplémentaires, dont la construction est un processus long et complexe. Le secteur est donc à la croisée des chemins : il lui faut trouver un équilibre entre l’ambition de l’IA, l’essor du cloud et la réalité d’une infrastructure électrique encore trop rigide pour suivre le rythme de cette révolution numérique.

L’IA soigne aussi sa consommation énergétique

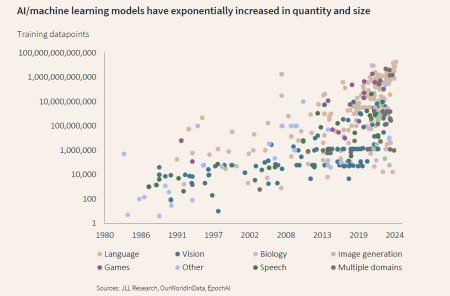

Ce graphique traduit la transition vers des systèmes de plus en plus généralistes (multidomaines) et une adoption massive de techniques de deep learning exigeant d’énormes corpus d’entraînement. La rapide augmentation du volume de données d’entraînement et la diversification des domaines d’IA abordés expliquent l’explosion des consommations énergétiques des datacenters dédiés à l’IA.

Selon JLL, les GPU modernes permettent d’entraîner les modèles de langage beaucoup plus rapidement – certaines tâches passant de 32 heures à une seconde. Cette puissance accrue permet l’utilisation de jeux de données toujours plus grands, au point que les experts anticipent une pénurie de données de qualité dans les prochaines années. Ces avancées technologiques catalysent aujourd’hui l’innovation dans tout l’écosystème de l’IA. Et laissent entrevoir d’importantes améliorations quant à la consommation énergétique des datacenters IA de demain.

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :