Cloud

Google I/O 2023 : Ce que les DSI doivent en retenir

Par Laurent Delattre, publié le 12 mai 2023

De l’IA partout et à tous les étages… Google a fait de l’IA sa priorité du moment et refait peu à peu son retard sur OpenAI et Microsoft tout en innovant de son côté. C’est ce que l’éditeur a cherché à prouver tout au long de sa conférence Google I/O 2023. Voici les annonces phares que tout DSI doit garder en tête…

« Comme vous l’avez probablement remarqué, l’IA connaît une année 2023 très active. Et nous avons beaucoup à dire à ce sujet » annonce d’emblée Sundar Pichai, CEO de Google, en ouverture de sa grande conférence annuelle orientée développeurs, la Google I/O 2023. « Sept ans après le début de notre parcours en tant qu’entreprise axée sur l’IA, nous nous trouvons à un point d’inflexion passionnant. Nous avons aujourd’hui la possibilité de rendre l’IA encore plus utile pour les gens, les entreprises et les communautés, encore plus utile pour tous. Avec l’IA générative, nous passons vraiment à l’étape suivante ».

Le ton est donné d’emblée. Google veut nous parler d’IA et veut chasser cette sensation de suivre le mouvement avec un temps de retard depuis l’embrasement médiatique généré par ChatGPT et alors même que ses chercheurs sont à l’origine de bien des découvertes algorithmiques au cœur des LLMs et de l’intelligence conversationnelle d’OpenAI.

Et si le moindre doute subsistait encore après une telle entrée en matière, Sundar Pichai confirme que « Google est en train de réinventer tous ses produits et services pour et grâce à l’IA ».

À LIRE AUSSI :

Dans un tel contexte, l’éditeur a pris soin de noyer les participants à sa conférence dans un flot ininterrompu de nouveautés et de démonstrations IA. Voici les annonces clés que tout DSI doit retenir de cette édition 2023 de Google I.A… oups, pardon… de Google I/O…

Android 14 et des tablettes Pixel

En temps normal, Google I/O est la grande messe Google de l’écosystème Android. Mais 2023, n’est pas une année « normale ». Nous passerons donc rapidement sur les annonces Android. Retenons simplement qu’Android 14 arrivera bien en fin d’année comme le veut la tradition. Et que les principales nouveautés mises en avant portent sur l’intégration de l’IA au sein des applications phares et dans la personnalisation du système (pour par exemple générer des fonds d’écran.). Google veut aussi soigner les expériences utilisateur sur les écrans élargis. L’univers tablettes d’Android souffrent d’applications peu adaptées à ce format. Un défaut que Google compte régler avec Android 14. Les Apps ont été optimisées pour ces écrans et l’OS acquiert quelques trouvailles ergonomiques pour mieux exploiter le multitâches. Et pour marquer ces efforts, Google lance sa propre tablette sous sa marque Pixel. Une tablette 11 pouces très classique qui se démarque par son support de charge qui fait office d’enceinte Google Home. Son prix démarre à 649 € (avec le support). L’éditeur lance aussi son premier smartphone pliable, le Pixel Fold, qui se transforme en tablette une fois déplié. Mais ce dernier ne devrait pas connaître de distribution en France.

La Pixel Tablet est la première tablette officielle de Google sous Android. Elle est animée par Android 13 (mais prévue pour un upgrade Android 14) et le même processeur Tensor G2 qui équipe les smartphones Pixel 7, 7 Pro et 7a. Elle aura fort à faire face aux tablettes bon marché de Lenovo et Xiaomi et aux tablettes Pro de Samsung et Apple.

Mais elle peut aider l’écosystème à réviser les Apps Android pour les optimiser au format tablette.

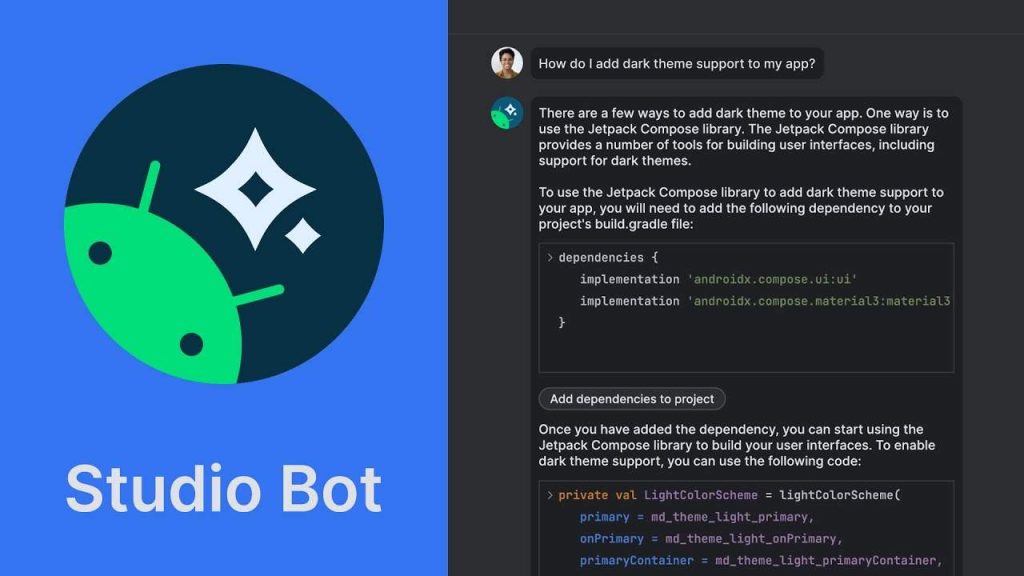

Android Studio se booste à l’IA

Pour rester dans l’univers Android, Google I/O célébrait cette année les 10 ans de l’outil de développement Google « Android Studio ». La nouvelle version intègre « Studio Bot », une IA conversationnelle qui peut être utilisée à tout moment par les développeurs pour analyser un code source, analyser un bug dans un code ou même générer le code d’une fonction à partir d’une expression des besoins.

L’IDE officiel de développement d’apps Android, Android Studio, se dote d’un assistant conversationnel qui rappelle GitHub Copilot. Dénommé Studio Bot, il aide les développeurs à trouver des réponses à leurs questions de développement et peut automatiquement générer du code contextualisé.

En vidéo : Meet Studio Bot

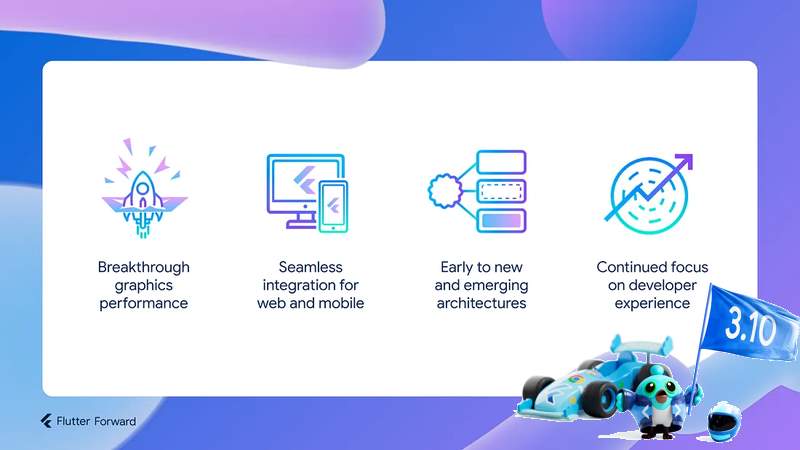

Flutter 3.10 convertit les entreprises au cross-plateform

Flutter est un des frameworks cross-plateformes les plus appréciés du moment notamment du côté des entreprises en quête d’outils universels évitant d’avoir à réécrire chaque application métier pour différents environnements. Typiquement, l’application SNCF Connect a été écrite avec Flutter comme nous l’a récemment confirmé le DSI de l’entreprise.

À LIRE AUSSI :

Flutter 3.10 améliore encore le support des plateformes Android, iOS, Web, Windows, macOS et Linux avec de nombreuses améliorations portées au nouveau moteur de rendu dénommé « Impeller ». L’outil supporte désormais la version 3.0 du langage Dart et supporte également WebAssembly (pour optimiser l’exécution des applications Flutter sur les navigateurs Web).

Flutter 3.10 s’impose comme l’une des principales plateformes de développement pour créer des apps universelles.

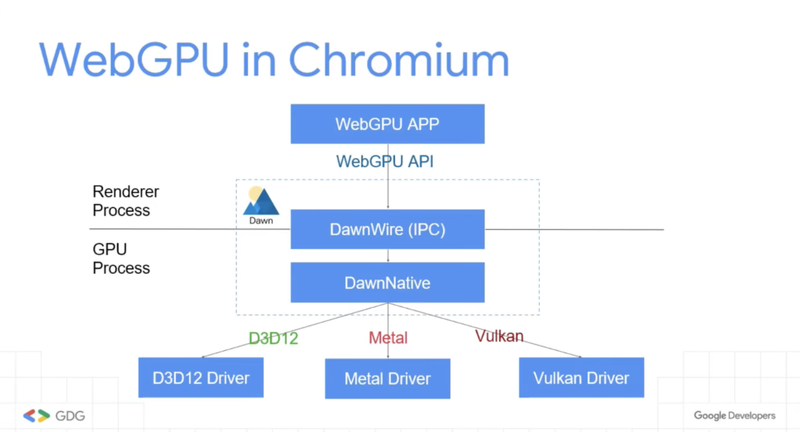

WebGPU, pour la 3D et l’IA sur le Web

WebGPU est une nouvelle API développée dans le cadre du W3C et introduite par Google dans la toute dernière version de Chrome. Son objectif est d’offrir un accès plus direct au GPU.

Même si cette API peut être perçue comme concurrente à WebGL, elle vise un usage plus généraliste des potentiels des GPU. « WebGPU rend le web prêt pour l’IA » explique ainsi Matt Waddell, qui dirige les évolutions de Chrome. L’objectif vise à permettre l’exécution d’inférences IA directement sur les navigateurs (et applications mobiles) notamment pour réduire la charge sur les serveurs et datacenters. Google explique que de telles exécutions locales sont essentielles à certaines entreprises manipulant des données ultra-sensibles ou exigeant de hauts niveaux de sécurité et confidentialité (pour les secteurs de la santé et de la défense notamment).

Contrairement à WebGL, WebGPU permet d’exploiter pleinement la puissance des GPU dans une variété d’usages : Métavers, Gaming, IA.

Déporter les IA sur les devices permettra de soulager les infrastructures cloud et rendre les IA plus autonomes.

WebGPU devrait être rapidement décliné sur les navigateurs dérivant de Chrome (à commencer par Microsoft Edge) ainsi que sur Firefox.

Duet AI for Google Workspace

Nous en avons déjà parlé, Google ambitionne d’intégrer des IA génératives au cœur de sa suite collaborative. Microsoft a maintes fois démontré comment son IA « Copilot » allait augmenter le potentiel de chaque collaborateur au sein de sa suite Microsoft 365. L’équivalent Workspace chez Google se nomme « Duet AI ».

« Workspace a été conçu pour vous permettre de collaborer en temps réel avec d’autres personnes. Désormais, vous pouvez collaborer en temps réel avec l’IA », s’enthousiasme Aparna Pappu, VP Workspace chez Google.

Duet AI vient intégrer de l’IA générative dans chaque composante de Google Workspace.

Animée par le modèle multimodal PaLM 2 de Google, Duet AI – la nouvelle IA conversationnelle qui sera intégrée au cœur de la suite Workspace – ne se contente pas de générer des textes. L’IA sait aussi générer des images à partir d’une description en langage naturel.

Dans Gmail, Duet AI résume et traduit des emails, génère des actions et ajoute une option « Help Me Write » permettant de rédiger une réponse contextualisée à un courriel reçu.

Sous Google Docs, Duet AI reformule ou résume un texte, génère des « listes à puce », génère des paragraphes pour enrichir un texte, trouve des titres ou rédige des introductions et conclusions.

Sous Google Sheets, Duet AI aide les utilisateurs à analyser et agir sur les données, à classer les informations, à créer des tableaux à partir de sources Web, et même à automatiser certaines actions.

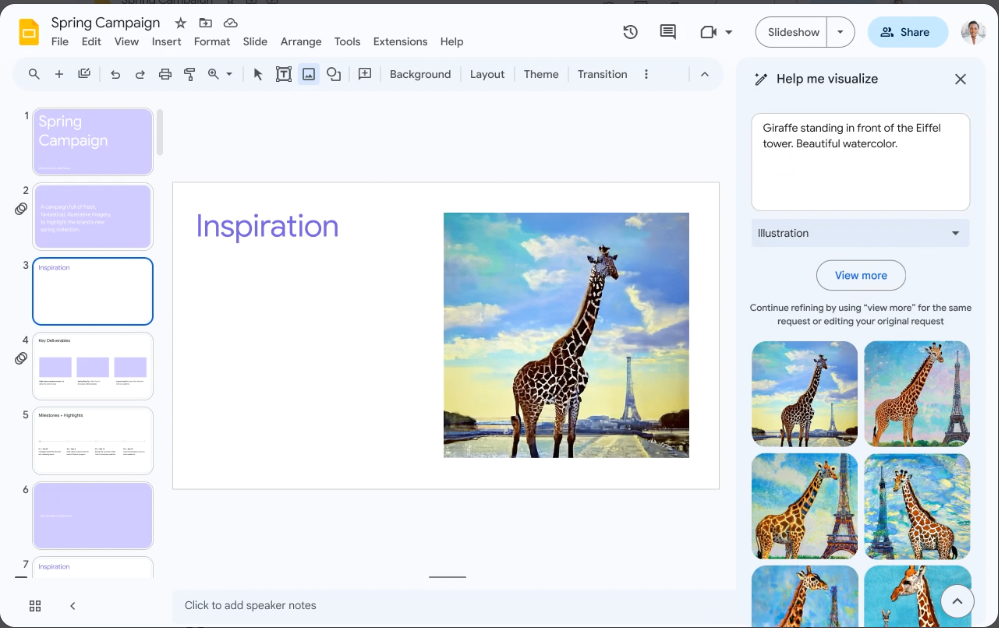

Sous Google Slides, Duet AI peut générer des images pour illustrer vos slides et vous épargner des heures à chercher des images libres de droits dans les bibliothèques Web.

Sous Google Meet, Duet AI peut générer un fond d’écran en fonction de votre humeur du moment.

Duet AI for Google Cloud

Microsoft met du Copilot partout ? Google y répond en mettant aussi du Duet AI partout… Et à commencer par son cloud. Profitant que Microsoft n’ait justement pas encore pensé à Azure Copilot, Google se démarque et prend de l’avance sur les autres Cloud en lançant une IA conversationnelle à même d’accompagner les développeurs et IT dans leur prise en main du Cloud.

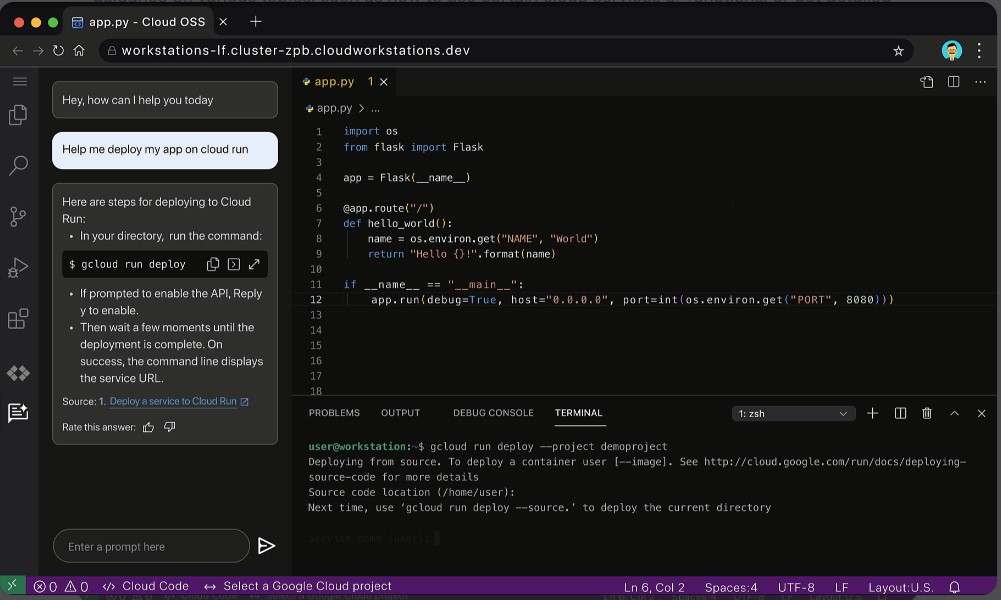

Intégrée à la console comme à l’interface de Google Cloud, Duet AI est une aide conversationnelle qui vous aide et vous guide dans toutes vos opérations sur le cloud Google en vous indiquant pas à pas quoi faire ou en générant des scripts pour vous.

Duet AI for Google Cloud est un assistant conversationnel qui aide les utilisateurs Google Cloud au quotidien quel que soit leur niveau de compétence. « Avec Duet AI, nous avons pour mission d’offrir une nouvelle expérience Cloud, plus personnalisée et axée sur les intentions, qui peut comprendre en profondeur votre environnement pour vous aider à créer des applications sécurisées et évolutives, tout en vous fournissant des conseils d’expert », justifie Michael Weingartner, VP écosystème Google Cloud.

Prochainement intégrée à toutes les interfaces Google Cloud, à commencer par GC Console et l’IDE ; Duet AI aide à résoudre les problèmes de prise en main et de paramétrage des services et seconde les développeurs dans l’écriture de codes notamment sur Google Cloud Functions.

Vertex AI, le nouveau cœur de l’IA générative sur Google Cloud

Peu à peu, Vertex AI s’impose comme une pièce centrale et un atout phare de Google Cloud. La plateforme née pour simplifier le développement et le déploiement de modèles ML devient au fil du temps le véritable centre névralgique de développement et d’utilisation de l’IA pour les développeurs et data-scientists.

En mars dernier, Google avait annoncé la prise en charge de modèles d’IA génératives au cœur de Google Cloud non seulement au travers d’un API PaLM (pour permettre d’intégrer des LLMs dans n’importe quelle application) mais également au travers de Vertex AI afin de permettre aux entreprises et à leurs data-scientists de personnaliser les modèles génératifs proposés, d’en construire de nouveaux (à partir de ceux proposés) et de les déployer en utilisant le même service que celui qu’ils utilisent déjà pour les modèles ML classiques.

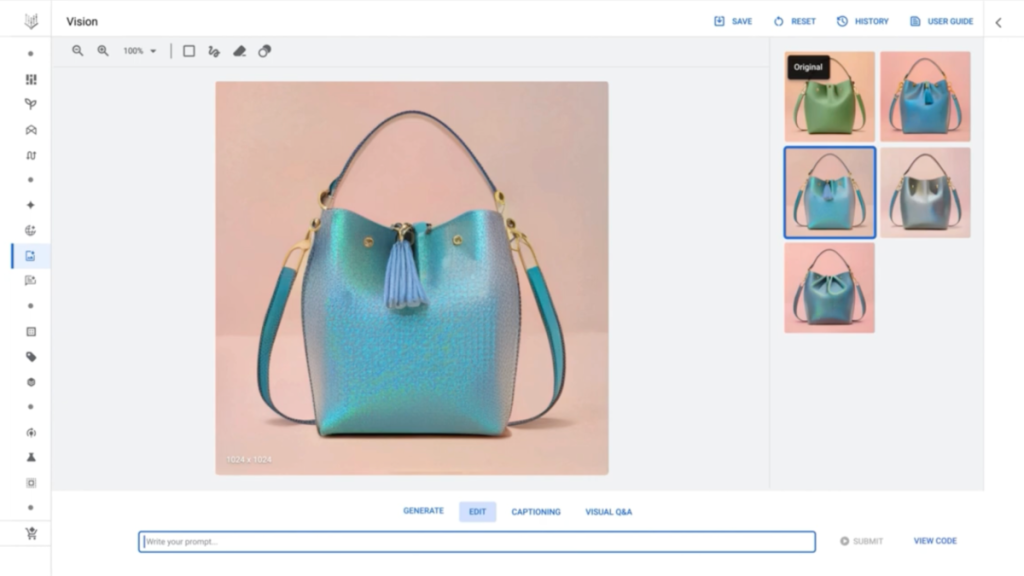

Vertex AI s’enrichit de nouveaux modèles génératifs que l’on peut expérimenter directement depuis Generative AI Studio. Ici, une illustration du fonctionnement du modèle Imagen.

À Google I/O 2023, l’éditeur a annoncé l’arrivée de trois nouveaux modèles de base (foundation models) dans Vertex AI. Ces modèles peuvent être simplement appelés via une API, personnalisés et reconfigurés via l’interface conviviale de Generative AI Studio (dans Vertex AI), ou déployés dans un notebook de data-science pour être retravaillés et réentraînés.

1/ Codey est le dernier modèle “text-to-code” de Google. C’est lui qui anime le nouveau « Studio Bot » d’Android Studio par exemple. Il permet d’intégrer de la génération et de la complétion de code en temps réel dans les environnements de développement. Codey peut être vu comme la réponse de Google à Codex d’OpenAI (au cœur de GitHub Copilot).

2/ Imagen est un modèle de génération d’images à partir d’expression textuelle en langage naturel. C’est l’équivalent Google d’un modèle Dall-E ou Stable Diffusion. Il permet de générer, modifier ou enrichir des images à partir de description textuelle.

3/ Chirp est le nouveau modèle « Speech To Text » de Google, capable de transcrire les flux audio en texte. Chirp est une alternative à Whisper d’OpenAI.

PaLM2 & Bard, en attendant Gemini

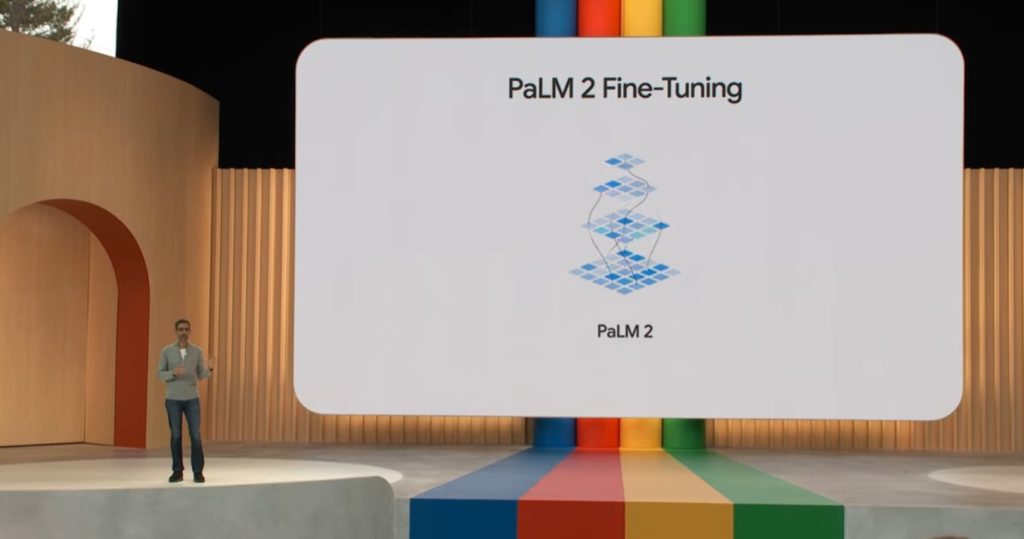

Après LaMBDA et PaLM, les deux dernières générations de LLM issus des laboratoires de recherche en IA de Google Research, Google a confirmé la mise en production de PaLM 2, nouvelle itération de ses recherches sur les grands modèles linguistiques.

PaLM 2 est intégré au service Google Cloud « PaLM API » et devient le nouveau moteur de BARD, l’assistant conversationnel expérimental de Google destiné à concurrencer ChatGPT et Bing Chat.

Par la même occasion, Google a décidé d’ouvrir l’accès à BARD. Plus besoin de s’inscrire à une liste d’attente et plus besoin d’être américain. Les internautes peuvent désormais y accéder en anglais depuis 180 pays… mais pas la France ! Google préfère attendre le support prochain du Français et de 39 autres langues pour donner accès à son IA depuis l’Hexagone. Il va donc falloir encore patienter quelques semaines.

« Les modèles PaLM 2 sont plus forts en logique et en raisonnement grâce à un large entraînement sur des sujets scientifiques et mathématiques“, a expliqué Sundar Pichai, lors de l’événement. « Ils sont également formés sur des textes multilingues (plus de 100 langues), ce qui leur permet de comprendre et de générer des résultats nuancés. »

Et si Sundar Pichai parle de modèles PaLM2 au pluriel, c’est parce que Google en propose différentes déclinaisons pour des besoins spécifiques que ce soit en termes d’empreinte mémoire, de performance ou de spécialisation. Typiquement, Google dérive PaLM 2 en quatre modèles dénommés en interne Gecko, Otter, Bison et Unicorn. Le plus compact, Gecko, fonctionne sur smartphone et traite une vingtaine de mots par seconde. Ce sont ces différents modèles qui sont notamment utilisés pour animer Duet AI for Workspace.

PaLM 2 est le nouveau modèle LLM multimodal de Google qui anime désormais BARD mais aussi Duet AI ainsi que 25 autres services et logiciels d’IA de Google.

Mais PaLM 2 est aussi conçu pour être spécialisé pour un domaine spécifique. Typiquement, Google utilise Sec-PaLM pour aider les équipes de cybersécurité dans l’analyse des codes malveillants et des journaux de sécurité au travers de son nouvel outil Cloud Security AI Workbench. De même, le modèle « Med-PaLM 2 » a été développé pour aider les médecins dans l’analyse des radiographies et des données de santé. Pour expliquer tout l’intérêt d’une telle spécialisation d’un modèle de base, Google révèle que Med-PaLM 2 se montre neuf fois plus pertinent que PaLM 2 sur les questions médicales.

PaLM 2 est une étape clé pour Google. Cette itération se montre aussi douée que LaMBDA pour mener des conversations (c’est pourquoi LaMBDA avait été préféré à PaLM 1 pour animer BARD au début) mais se révèle bien moins sensible aux hallucinations. Dit autrement, PaLM 2 est l’arme actuelle de Google pour refaire son retard sur OpenAI et GPT-4.

Mais l’éditeur travaille déjà à son successeur. Google a fusionné son centre de recherche IA avec celui de sa filiale DeepMind afin d’accélérer le développement d’un nouveau modèle nativement multimodal dénommé « Gemini ». Selon Google, Gemini est entraîné avec une grande variété de sources audio, photos et vidéos en plus des sources textuelles. Il est conçu pour être hautement efficient et permettre des fonctionnalités comme la mémorisation et la planification. Gemini est destiné à remplacer PaLM 2 une fois qu’il aura été suffisamment entraîné, testé, filtré et paramétré.

Des outils pour repérer les contenus de l’IA

Sans véritablement rentrer dans les détails, Sundar Pichai a confirmé les efforts de Google pour lutter contre les « fakes » générés par l’IA. Même si les efforts se portent pour l’instant plus autour des images et vidéos générés par IA, la volonté est d’intégrer directement aux modèles des moyens d’identifier les contenus produits par les IA de Google.

L’éditeur poursuit les mêmes pistes qu’IBM ou OpenAI en la matière. L’idée est de combiner à la fois les technologies de marquage et les métadonnées. Le marquage en filigrane (ou Watermarking) consiste à masquer des informations dans le contenu généré, informations qui puissent être conservées même si le contenu est édité ou redimensionné. Les métadonnées ajoutent des informations sur l’origine du contenu dans les fichiers générés.

On ne sait pas encore quand ces technologies seront effectivement intégrées aux contenus générés par les IA de Google.

Des VM pour l’IA

Bien que Google I/O ne soit pas un événement Google Cloud, et pour rester dans sa logique « Tout pour l’IA », l’éditeur a profité de sa conférence pour annoncer le lancement de nouvelles machines virtuelles HPC – les VM A3 – au sein de GCP. Elles sont animées par des processeurs Intel Xeon Scalable de dernière génération et supportent jusqu’à 8 GPU NVidia H100 et 2 To de RAM. Dit autrement, ces VM sont particulièrement destinées à animer des clusters d’apprentissage d’IA. Elles sont disponibles sous GCE, sous GKE et sous Vertex AI.

Google Search se booste à l’IA

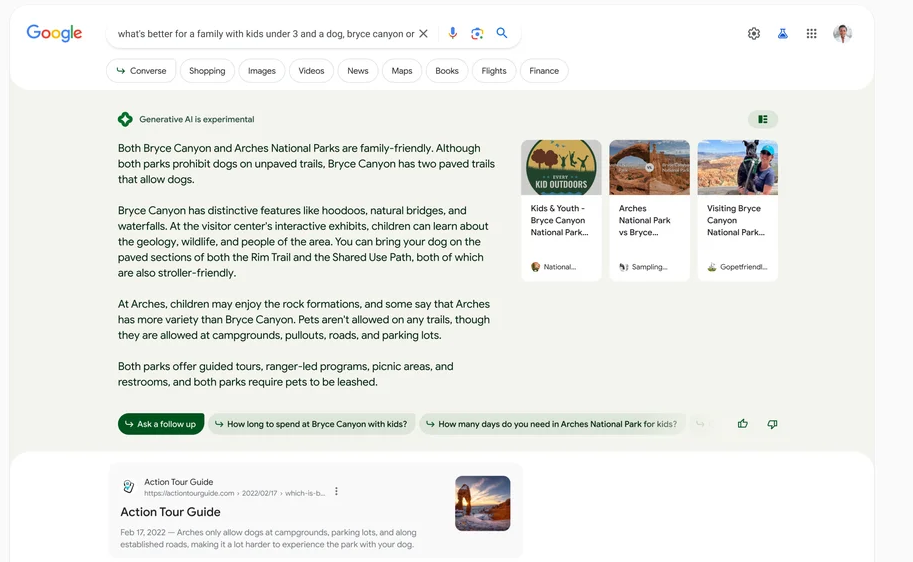

Bien évidemment, Google Search n’échappera pas non plus à la vague IA générative. A l’occasion de Google I/O, l’éditeur a dévoilé sa nouvelle “Search Generative Experience” (SGE) qui n’est pas sans rappeler ce que YOU.COM a mis en place et ce que BING propose désormais à tous. Si le moteur continue de répondre avec ses occurences et publicités habituelles, il ajoute en entête une section générée par l’IA qui synthétise les informations trouvées et les regroupe sous une forme à la fois visuelle et interactive.

L’IA arrive également sur Google Search.

Google expérimente une nouvelle expérience (Search Generative Experience) où l’IA vient synthétiser les résultats et proposer d’étendre la discussion en basculant en mode chat.

Par ailleurs, l’IA propose automatiquement des questions connexes et un bouton “follow up” qui permettent de poursuivre l’expérience de recherche en mode conversationnel. Pour profiter de l’expérience SGE, il faut s’inscrire sur une liste d’attente et être américain. Google n’a pas précisé de deadlines quant à la mise en production de cette nouvelle expérience qui pour l’instant est estampillée “Search Labs”, laissant supposer que l’éditeur est encore loin d’officialiser une nouvelle expérience Google Search.

Au final, on appréciera les efforts de Google pour reprendre la main sur la hype du moment et sa capacité à rattraper son retard. Mais on notera aussi que la plupart de ces annonces sont en réalité au futur. Car si Google les démontre, l’éditeur ne les met pas encore entre toutes les mains. La plupart des IA annoncées sont en beta fermée, réservée à des clients et partenaires fidèles, de confiance, et triés sur le volet. Une approche prudente à la fois motivé par une envie de se montrer “responsable” mais également de limiter les coûts opérationnels de toutes ces IA gourmandes le temps de les optimiser…

À LIRE AUSSI :