Newtech

Google Willow, l’innovation quantique et les fantasmes du marketing

Par Laurent Delattre, publié le 19 décembre 2024

Google vient d’annoncer son nouveau processeur quantique Willow à 105 qubits, accompagné de déclarations spectaculaires sur ses performances. Mais qu’en est-il réellement ?

A la Une du Web en ce moment : « Google révolutionne l’informatique quantique », « Willow, une puce surpuissante », « Willow is a game changer », « Willow résout en 5 minutes un problème qui prendrait 10 septillions d’années à un ordinateur classique », « avec Willow, l’avenir du Bitcoin est condamné », « Willow démontre la réalité des multivers »…

Le marketing américain a toujours tendance à en faire des tonnes. Particulièrement dans l’univers quantique, où chaque petit pas vers l’arrivée de l’ordinateur quantique est présenté comme une révolution intersidérale. Ce qui se traduit irrémédiablement par des titres de presse encore plus éloignés de toute réalité. Et plus l’Europe et les Chinois démontrent qu’en matière quantique les Américains ne sont pas aussi en avance qu’ils le souhaiteraient, plus le marketing US en rajoute et fait mousser sa sauce.

Stratégie d’intox ou simplement excitation disproportionnée ? Chacun jugera. Mais Google qui nous avait déjà fait le coup avec sa « suprématie quantique » en 2019, nous rejoue le même sur-enthousiasme marketing et médiatique pour faire remarquer « bruyamment » qu’ils ont avancé de leur côté comme pour mieux « passer sous silence » leur retard sur leur propre roadmap.

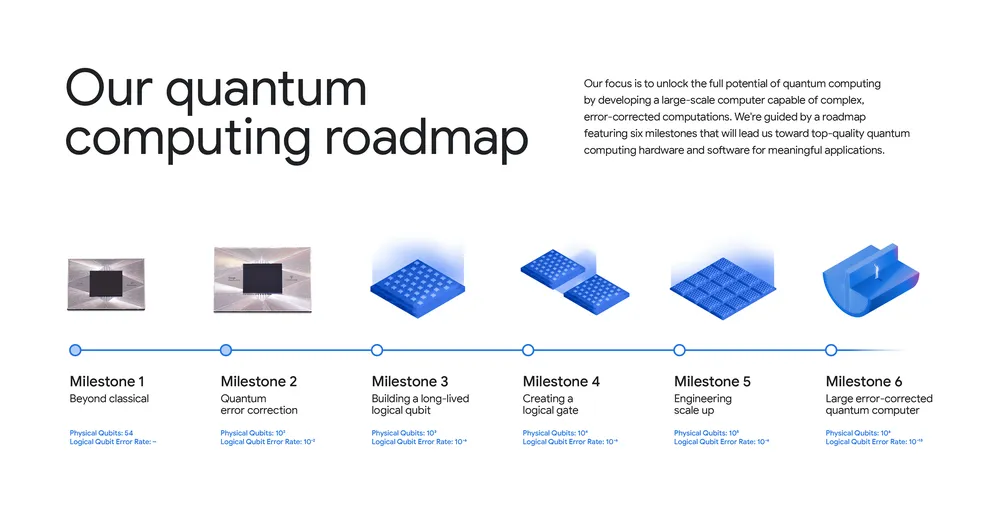

Car si le nouveau processeur « Willow » est très intéressant à bien des égards, il ne justifie aucun des titres dithyrambiques publiés depuis quelques jours. Il marque une très nette progression dans l’agenda R&D de Google et un nouveau petit pas en avant dans la quête d’une informatique quantique fiable et utile, mais le chemin qui reste à parcourir est toujours aussi long et complexe comme le démontre d’ailleurs la toute nouvelle roadmap quantique de Google.

Une étape technique importante

Dans les faits, Google a effectivement franchi une étape significative dans le domaine de la correction d’erreurs quantiques. Le processeur Willow permet de créer des « qubits logiques » dont la fiabilité dépasse celle des qubits physiques sous-jacents, et ce sans recourir à des techniques de post-sélection comme le font d’autres acteurs du secteur.

Pour les non-initiés, un qubit logique est une unité de calcul quantique plus fiable construite à partir de plusieurs qubits physiques. C’est une brique essentielle pour construire des ordinateurs quantiques vraiment utiles.

Les qubits logiques assemblent les qubits physiques au travers de techniques avancées de correction d’erreurs. Les chercheurs explorent de multiples pistes différentes. Typiquement, les équipes de recherche de Microsoft et Quantinuum travaille sur un mécanisme de virtualisation des qubits physiques produisant des qubits logiques présentant des taux d’erreurs 800 fois inférieurs à ceux des qubits sous-jacents. Mais la technique semble avoir du mal à permettre de réutiliser les mécanismes de correction d’erreurs plusieurs fois sur les mêmes qubits logiques. Les chercheurs d’IBM explore des mécanismes de correction d’erreurs radicalement différents permettant de protéger 12 qubits logiques pendant environ un million de cycles de vérification d’erreurs en utilisant 288 qubits physiques. Il existe des dizaines de recherches sur comment créer les mécanismes de correction d’erreurs capables de monter à l’échelle.

Mais autant il est assez simple de comprendre qu’un qubit logique est un qubit virtuel formé de plusieurs qubits physiques réels, autant il s’avère très complexe de réaliser des qubits logiques plus fiables que des qubits physiques à partir de techniques avancées de correction d’erreurs surtout lorsque l’on multiplie les qubits physiques.

En 2022, Google avait ainsi déjà publié des résultats montrant comment créer un qubit logique avec un code de surface « distance 5 » (une forme de code de correction d’erreur qui encode l’information quantique sur une grille bidimensionnelle de qubits) à partir de 49 qubits physiques sur leur puce Sycamore. Mais à l’époque, ce qubit logique n’était pas encore meilleur que les qubits physiques pris isolément.

C’est justement sur ce sujet que Google a véritablement progressé avec Willow. Non sans mal, et en « trichant un peu » (Il a fallu plusieurs tentatives et améliorations de la puce pour atteindre ces performances et même en réalité deux puces différentes pour atteindre deux objectifs différents), Google a démontré que sa technique de correction d’erreurs permettait de réduire exponentiellement les erreurs des qubits logiques à mesure que le nombre de qubits physiques augmente.

On notera au passage que si, en théorie, la technique de Google permet de créer des Qubits logiques disposant d’une longue durée de vie, même ses chercheurs reconnaissent qu’ils ne sont pas encore à ce stade avec Willow, un stade qui correspond au « Milestone 3 » de leur nouvelle roadmap quantique.

Ce qu’il faut retenir, c’est que Google a réussi à réaliser des calculs (des portes quantiques logiques) sur des qubits logiques avec de meilleures performances que les mêmes portes sur les qubits physiques. Par ailleurs, ils ont démontré qu’il était possible d’ajouter plus de qubits physiques tout en améliorant de manière exponentielle la stabilité des qubits logiques (ce qui n’était jusqu’ici pas vrai). Enfin, ils ont démontré que leur technique de correction pouvait être réappliquée à grande échelle, en l’occurrence Willow permet 909.000 cycles de correction d’erreurs par seconde!

De quoi montrer que l’informatique quantique progresse et qu’il existe apparemment un chemin qui permet d’obtenir des qubits logiques toujours plus fiables alors même que l’on augmente le nombre de qubits physiques… C’est clairement un pas dans la bonne direction.

Suprématie quantique versus Avantage Quantique

En 2019, Google annonçait avoir atteint la suprématie quantique en réalisant un échantillonnage de circuits aléatoires (RCS – Random Circuit Sampling) évalué via une métrique appelée Cross-Entropy Benchmarking (XEB). Grosso modo, Google a fait exécuter à sa puce un ensemble de portes quantiques aléatoires sur 53 qubits, puis a mesuré le résultat. Le taux de réussite était faible (0,14 %), mais en répétant l’expérience des millions de fois, ils ont pu obtenir une distribution de résultats caractéristique de l’évolution du circuit quantique. Google affirmait alors que son résultat obtenu en 5 minutes aurait pris « 10.000 ans » à un supercalculateur HPC.

Ce à quoi IBM a rétorqué qu’en réalité il fallait à son HPC « Summit » 2,5 jours pour parvenir au même résultat. Depuis, il a été démontré qu’il fallait en réalité 6 secondes pour réaliser le même test sur un ordinateur classique « Frontier » soit moins de temps que l’ordinateur Sycamore de Google.

Histoire de récupérer sa suprématie quantique, Google annonce que Willow explose les scores de Sycamore : « Les performances de Willow sur ce benchmark sont étonnantes : il a effectué un calcul en moins de cinq minutes qui prendrait l’un des supercalculateurs les plus rapides d’aujourd’hui 1025 ou 10 septillions d’années. Si vous voulez l’écrire, c’est 10 000 000 000 000 000 000 000 000 000 ans. Ce nombre ahurissant dépasse les échelles de temps connues en physique et dépasse largement l’âge de l’univers. Cela donne du crédit à l’idée que le calcul quantique se produit dans de nombreux univers parallèles, conformément à l’idée que nous vivons dans un multivers, une prédiction faite pour la première fois par David Deutsch. »

Bien sûr on attend avec impatience la réponse d’IBM ou HPE/Cray expliquant que les machines hyperscale d’aujourd’hui n’ont pas besoin de 10 septillions d’années pour atteindre le même résultat. Mais comme le souligne Scott Aaronson, les affirmations de Google soulèvent un problème : elles sont invérifiables. Car pour vérifier avec un ordinateur classique que ce que l’ordinateur quantique Willow a pondu est vrai, il faudrait également 10 septillions d’années. Quant aux affirmations d’univers parallèles, on nage bien plus dans la science-fiction que dans la science.

Reste que le problème fondamental de tout ceci n’est pas réellement cette guerre de chiffres. Le problème, c’est que le Benchmark RCS/XEB n’a aucune utilité scientifique, informatique ou pratique. Il n’utilise pas de données d’entrée utiles et il ne produit pas de résultat exploitable. À mesure que les chercheurs repoussent la difficulté pour la simulation classique, ils démontrent l’efficacité potentielle de la puce quantique, mais ne fournissent aucune solution concrète à un problème réel.

Dans un papier de blog, Brian Hopkins et David Mooter du Forrester rappelle ainsi que la suprématie quantique revendiquée par Google n’a aucun intérêt et que le véritable Graal, c’est « l’avantage quantique », ce point d’inflexion qui fera que les ordinateurs quantiques surpasseront les ordinateurs classiques sur des tâches pratiques. Et là on n’y est pas encore. « L’avantage quantique fait référence à un système quantique capable de résoudre un problème pratique et réel plus rapidement et à moindre coût qu’un problème classique. Malheureusement, il nous faudra peut-être encore une décennie pour y parvenir » écrivent-ils.

Tempérons l’enthousiasme…

Il est donc l’heure de refroidir les fantasmes médiatiques et marketings.

Le chemin reste encore très long : pour réaliser des calculs quantiques utiles, il faudrait assembler plusieurs milliers de qubits logiques eux-mêmes composés de dizaines, centaines ou milliers de qubits physiques. On est donc encore très loin du compte avec les 105 qubits de Willow.

En outre, les performances techniques affichées par Willow ne sont pas si exceptionnelles que ça : 105 qubits, c’est loin d’être un record. Et les caractéristiques des qubits de Willow (temps de cohérence, fidélité des portes, connectivité moyenne, taux d’erreur sur les portes à deux qubits) sont en fait inférieures à celles d’autres processeurs comme ceux d’IBM, d’IonQ ou de Quantinuum.

Enfin, pour arriver à un ordinateur quantique véritablement utile, Google et ses concurrents ont encore bien des défis à relever à commencer par :

– Implémenter une correction d’erreurs pour tous les types de portes quantiques;

– Construire des puces beaucoup plus grandes (10 000+ qubits physiques);

– Développer des solutions d’interconnexion entre puces qui tiennent la charge;

– Résoudre les problèmes d’erreurs corrélées;

– Gérer le passage à l’échelle du câblage et de l’électronique cryogénique (dans le cadre des qubits supraconducteurs de Google);

– Créer des algorithmes quantiques utiles et pratiques capables d’être déployés à l’échelle.

Même chez IBM, qui espère toujours disposer d’un « quantique commercialisable à l’horizon 2029 », il faudra encore au moins une décennie de développement avant d’avoir des ordinateurs quantiques capables de résoudre des problèmes pratiques utiles ou capables de craquer les systèmes de cryptographie actuels. L’enthousiasme est une chose… Le fantasme en est une autre… Il est enthousiasmant de voir l’informatique quantique sans cesse progresser. Mais il nous faut encore garder patience avant de la voir concrétiser ce pour quoi on est en train de l’inventer !

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :