Newtech

Intel Vision 2024 : les 5 annonces à retenir

Par Laurent Delattre, publié le 15 avril 2024

Alors que Google Cloud Next 2024 bâtait son plein à grand coup de chips maison et d’IA génératives dans tous les recoins, Intel tenait sa conférence Vision 2024 tentant de faire survivre l’ère du x86 à la nouvelle vague de l’IA et de la sobriété numérique.

L’ère Wintel paraît bien révolue. Non seulement Intel parle chaque année un peu moins de Windows, mais l’univers de Windows lui-même est en train de se préparer à une nouvelle ère ARM. D’ailleurs, un événement presse « spécial Windows on ARM » est annoncé par Microsoft pour le 20 mai, veille de l’ouverture d’une conférence Build 2024 qui promet un monde refaçonné par l’IA et les NPU.

Les temps sont ainsi difficiles pour Intel qui doit trouver de nouvelles voies, de nouveaux moteurs de croissance, pour demeurer un acteur majeur dans un monde de concepteurs de puces qui n’a clairement plus peur de défier l’ancien ogre et lui taille même des croupières dans tous les domaines : ARM s’impose sur tous les fronts de la mobilité, Microsoft suit Apple et réinvente Windows pour ARM avec Qualcomm, AMD fait le forcing dans l’univers du HPC, NVidia dévore tout dans le monde des GPU et de l’IA.

A l’occasion d’Intel Vision 2024, l’entreprise américaine a cherché à définir sa vision d’un monde où « l’IA est partout », à redéfinir sa stratégie à la fois en temps que créateur de puces et fabricant de puces (Intel a splitté ses activités en deux entités distinctes), et à expliquer comment son portfolio et son architecture x86 allait s’adapter à cette vision et ce nouveau monde.

Voici ce que les DSI – de plus en plus invités à se réintéresser aux moteurs qui animent leurs infrastructures, serveurs et PC – doivent retenir de cette conférence.

1/ Gaudi 3 : Intel veut exister face aux GPU IA de NVidia

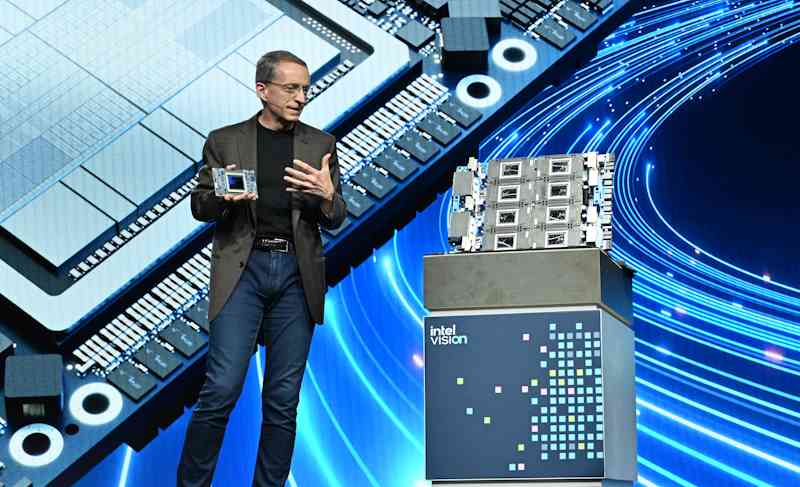

Bien évidemment, alors que sa conférence portait le titre « AI Everywhere », Intel a accordé beaucoup de temps et d’énergie à déchiffrer les fondations de son nouveau GPU accélérateur d’IA « Gaudi 3 » et à chiffrer ses performances.

Pour Pat Gelsinger, les fournisseurs de cloud, entreprises et centres de R&D sont aujourd’hui en quête « d’une alternative à NVidia » : « Le monde a besoin de plus de fournisseurs et nous sommes pleinement investis pour lui procurer du choix » a ainsi expliqué le CEO d’Intel.

Un choix notamment en terme de prix. Sans réellement entrer dans les détails tarifaires, Intel a expliqué que le Gaudi 3 disposerait d’un TCO « extrêmement bon » et « d’un prix très inférieur » aux accélérateurs concurrents de NVidia.

Voilà qui promet d’être intéressant, si Intel veut vraiment entrer dans une guerre de prix sur ce marché du GPU pensé pour l’IA.

Très grosse puce, l’Intel Gaudi 3 est un GPU accélérateur d’IA pensé pour la scalabilité et la mise en cluster à l’aide de noeuds dotés chacun de 8 puces Gaudi 3.

Avec Gaudi 3, Intel dispose d’un vrai concurrent aux GPU NVidia H100, H200 et AMD MI300 series. En revanche, le GPU ne semble pas jouer dans la même catégorie que les futurs NVidia « Blackwell » récemment dévoilés.

Le Gaudi 3 est une puce bi-céphale où chacun des deux cerveaux embarque 4 moteurs de multiplication matricielle et 32 « Tensor Cores » programmables, soit 8 moteurs matriciels et 64 cœurs Tensor par puce. Au total, le Gaudi 3 développerait une performance de 1835 TFLOPS (en FP8). De quoi se montrer 40% plus véloce qu’un NVidia H100 dans l’apprentissage d’un LLM comme GPT 3.5 et ses 175 milliards de paramètres ou encore 1,7 fois plus rapide que le H100 sur l’entraînement d’un petit LLM comme LLama 2 8B. En matière d’inférence (et non plus d’entraînement), Gaudi 3 se montrerait en moyenne 50% plus performant qu’un NVidia H100. Surtout, le Gaudi 3 serait 2,3 fois plus efficient (puissance par rapport à l’énergie consommée) qu’un NVidia H100.

Autre atout selon Intel, Gaudi 3 est pensé pour la scalabilité. Il sera livré soit sous la forme d’une carte accélératrice OAM (HL-325L), soit sous la forme d’une carte PCIe (HL-338), soit au travers d’une carte mère (HLB-325) comportant 8 puces Gaudi 3. Cette carte mère sert de « nœud » à des clusters de calculs IA qui peuvent comporter de 64 (soit 512 puces Gaudi 3) à 1024 nœuds (soit 8192 puces Gaudi 3).

Intel propose toute une stack logicielle optimisée pour Gaudi 3 et promet qu’une migration d’un code vers Gaudi peut souvent se limiter à 3 lignes de codes à modifier dans le cadre de développements existants reposant sur PyTorch et ses API.

Intel assure avoir signé des partenariats avec Dell, HPE, Lenovo et Supermicro mais aussi avec Red Hat et VMware pour pousser l’adoption de sa plateforme. Reste maintenant à convaincre les vrais acteurs de l’IA.

2/ Pas de CPU sans NPU : Lunar Lake a l’IA en ligne de mire

Au-delà de l’annonce phare du Gaudi 3, Intel a commencé à lever le voile sur ses ambitions IA sur les PC. Avec la gamme « Core Ultra », Intel a commencé à embarquer des NPU dans ses processeurs PC. Des débuts pour l’instant assez timides mais qui ont permis d’initier la vague des « AI PC » dont on ne sait pas réellement encore ce qui les différencie vraiment des PC classiques si ce n’est la présence d’une touche Copilot sur le clavier. Les cas d’usage sont encore à inventer.

Le problème, c’est que le NPU embarqué dans l’actuelle génération « Meteor Lake » des Intel Core Ultra plafonne à 11 TOPS, très loin des 45 TOPS annoncés sur le Qualcomm Snapdragon Elite X.

“Lunar Lake” la prochaine génération des processeurs “Intel Core Ultra” fera un véritable bond en performances IA avec un NPU quatre fois plus performant.

Une concurrence qui va obliger Intel à bouger vite. Le fondeur a ainsi déjà levé le voile sur « Lunar Lake », sa prochaine génération de processeurs « Core Ultra ». Ces nouveaux processeurs seront dotés de NPU de 45 TOPS. Intel affirme même que les « Lunar Lake » dépasseront les 100 TOPS en combinant NPU, GPU et CPU. Ils sont attendus pour la fin de l’année.

Cette guerre aux TOPS (Tera opérations par seconde) est devenue particulièrement importante depuis que Microsoft a plus ou moins officiellement annoncé que les fonctionnalités IA sur lesquelles planchent les ingénieurs Windows nécessiteraient une puissance minimale de 40 TOPS.

3/ Xeon 6 : l’arme de la résilience pour Intel

Sur le front des datacenters, Intel a levé le voile sur la prochaine génération de processeurs Intel Xeon. Cette prochaine génération abandonne la marque « Xeon Scalable » (née en 2017) au profit d’une appellation plus simple : « Xeon 6 ». Plus simple ? Pas si sûr…

Car les « Xeon 6 » existeront en deux variations : Les « Xeon 6 P » (nom de code Granite Rapids) dotés exclusivement de cœurs « P » pour la performance et les « Xeon 6 E » (nom de code Sierra Forest) dotés exclusivement de cœurs « E » centrés sur l’efficacité énergétique.

Intel a déjà révélé plancher sur un « Xeon 6 E » embarquant 288 cœurs ! Ces versions « efficience » du Xeon 6 doivent débarquer dès le second trimestre de cette année alors que les versions « performance » sortiront, quant à elles, plus tard dans l’année.

Avec son Xeon 6 “Sierra Forest” intégralement composé de cœurs “E”, Intel veut inaugurer une nouvelle ère de Datacenters bien plus efficients.

Les Xeon 6 « E » sont annoncés avec une performance par Watt améliorée de 2,4 fois par rapport à la précédente génération de Xeon. Objectif rendre tous les datacenters moins énergivores sans perdre en performance.

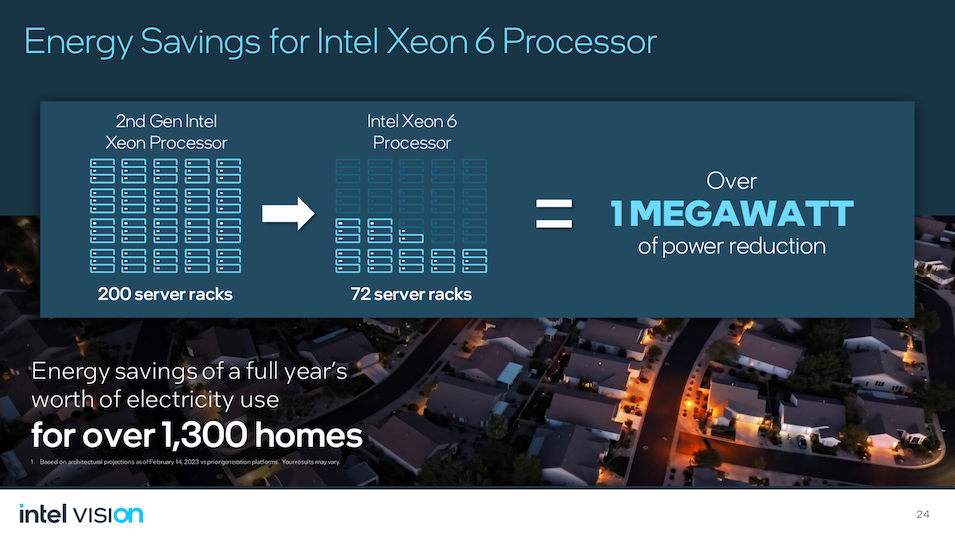

Selon Intel, les datacenters vont pouvoir remplacer 200 serveurs rack d’Intel Xeon Scalable de 2ème génération par seulement 72 serveurs racks. Une telle migration entraînera une réduction de 1 Megawatt, soit l’équivalent de la consommation de 1300 foyers en un an.

La firme s’est montrée plus discrète sur les Xeon 6 « P ». Apparemment le design de ces processeurs est essentiellement motivé par le marché des supercalculateurs et de l’IA : cette nouvelle génération prend en charge le format de données MXFP4 et doit pouvoir exécuter en local des modèles LLama-2 70B. Il sera intéressant de voir les réels scénarios d’usage pour lesquels ces Xeon 6 « P » se révèleront plus pertinents que leurs déclinaisons « E » ou des architectures à base d’accélérateurs IA. Sur la papier, ça ne paraît pas très évident.

4/ Intel Tiber : Intel se cherche de nouveaux horizons

Autre annonce – et pas des plus aisées à déchiffrer –, Intel a dévoilé « Tiber », une nouvelle marque qui regroupe un portfolio assez disparate de services, logiciels et solutions d’entreprise pour l’IA, le cloud, le Edge et la sécurité.

Tiber est un grand méli-mélo de solutions qui visent à accélérer l’adoption de solutions comme l’IA générative (via Tiber AI Studio), l’informatique confidentielle (avec Tiber Trust Services), le Edge Computing (Tiber Edge Platform) et l’optimisation des usages du cloud (Tiber App-Level Optimization).

Intel Tiber regroupe tout un portfolio de logiciels, plateformes et services Cloud pour simplifier le parcours des entreprises vers le Edge, l’informatique confidentielle, l’IA générative…

Un grand méli-mélo de technologies logicielles et de services portés par Intel et sur lequel vient se rattacher une initiative qui a fait long feu, « l’Intel Developer Cloud », désormais renommé « Tiber Developer Cloud ». Ce cloud est destiné à offrir aux développeurs un moyen d’accéder en avance de phase aux derniers processeurs Intel et aux outils de développements qui les accompagnent, le tout sous forme de service.

Sur le papier « Intel Tiber » vise à aider les entreprises à surmonter la complexité qui freine leurs initiatives qu’elles portent sur le Edge, la Gen AI, la sécurité ou la migration vers le cloud. Mais Intel s’aventure ici sur un nouveau terrain à mi-chemin entre fournisseur de cloud/services, éditeur de logiciels, consulting et fournisseur de plateformes.

5/ Le réseau à l’ère de l’IPU et de l’IA

Enfin, Intel a annoncé un « AI NIC » et une série de chiplets spécialisés dans la gestion de réseaux Ethernet optimisés pour l’IA et destinés à intégrer ses futurs XPU.

On sait Intel très actif au sein de l’UEC, l’Ultra Ethernet Consortium, un groupement d’industriels visant à moderniser Ethernet pour l’adapter aux infrastructures très réparties et aux besoins de l’IA. L’idée sous-jacente étant d’apporter une vraie alternative ouverte et basée sur Ethernet pour concurrence la technologie réseau InfiniBand de NVidia.

Les spécifications de l’UEC ne sont pas encore finalisées mais Intel annonce déjà centrer ses efforts « réseau » autour des travaux en cours. On en saura plus d’ici la fin de l’année.

Intel joue la carte de l’ouverture et de l’Ethernet en misant tout sur l’UEC afin de concurrencer NVidia et sa technologie InfiniBand…

Au final, cette édition 2024 de l’Intel Vision aura dévoilé le visage d’un Intel combatif sur tous les fronts et d’une entreprise consciente que l’IA va tout changer mais exige des besoins et des technologies différentes selon qu’elle s’applique sur les terminaux, dans le Edge ou dans le Cloud et selon les cas d’usage et les scénarios. Des cas d’usage et des scénarios qui restent encore à inventer et à imaginer, le potentiel de l’IA n’étant pour l’instant qu’effleuré par les entreprises comme par ceux qui créent les grands modèles fondation. Le défi pour la société Intel est désormais de se montrer aussi pertinente à l’ère de l’IA qu’elle ne l’a été jusqu’ici. Pas simple, car la concurrence est désormais plurielle, farouche et audacieuse…

À LIRE AUSSI :

À LIRE AUSSI :