Data / IA

Les paradoxes de l’IA dans la cybersécurité

Par Laurent Delattre, publié le 27 novembre 2024

Outil critique mais à double tranchant, l’IA générative redessine les frontières de la cybersécurité. C’est ce que dévoile et chiffre le dernier rapport très instructif du Capgemini Research Institute.

Le nouveau rapport du Capgemini Research Institute, intitulé « Nouvelles défenses, nouvelles menaces : ce que l’IA et l’IA générative apportent à la cybersécurité », met en évidence le rôle complexe que jouent l’intelligence artificielle (IA) et l’IA générative dans la sécurité des systèmes informatiques.

Si ces technologies apportent de nouvelles vulnérabilités, elles sont également perçues par une majorité des organisations comme des outils essentiels pour améliorer la détection et la réponse aux menaces.

Le paradoxe de l’arme à double tranchant…

C’est une tendance de fond autant qu’une réalité : l’intelligence artificielle s’impose comme un outil incontournable en cybersécurité, tout en créant de nouvelles vulnérabilités qui inquiètent les RSSI.

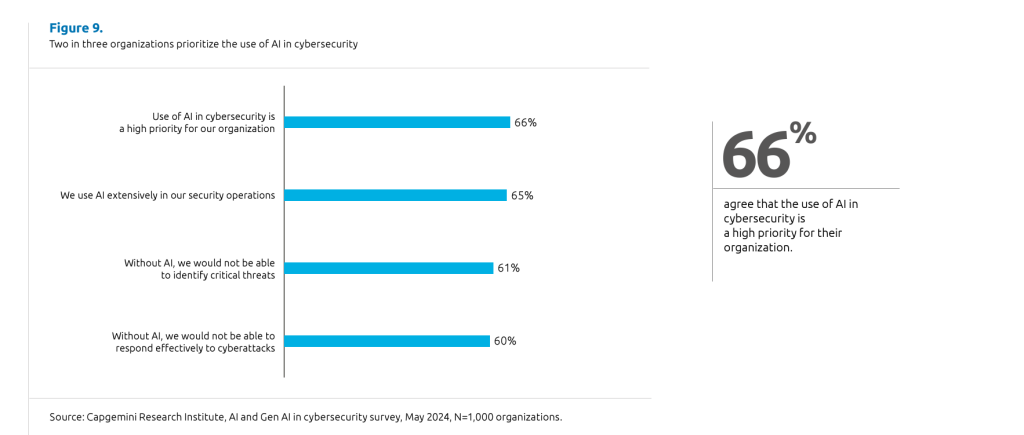

Le rapport souligne que deux tiers des organisations interrogées considèrent l’IA comme un élément critique de leur stratégie de cybersécurité. En effet, malgré les risques induits par la prolifération de l’IA générative — tels que des fuites de données provoquées par des utilisateurs insuffisamment sensibilisés et la Shadow IA, des attaques plus sophistiquées, une surface d’attaque élargie et une augmentation des vulnérabilités tout au long du cycle de vie des solutions —, ces technologies permettent aussi à long terme de prévoir, détecter et répondre aux menaces avec une efficacité accrue.

Du coup, le rapport illustre à quel point les RSSI aujourd’hui naviguent entre inquiétudes et espoirs.

Des risques multiples

L’IA générative présente des risques significatifs devenus bien réels : 97% des organisations interrogées ont déjà fait face à des incidents de sécurité liés à l’IA générative au cours de l’année écoulée.

Les principales inquiétudes concernent les attaques par injection de données malveillantes, les « hallucinations » du modèle, et la production de contenus biaisés ou nuisibles.

En outre, la capacité de l’IA générative à produire des contenus artificiels très réalistes, comme les deepfakes, a conduit 43 % des organisations à subir des pertes financières directes.

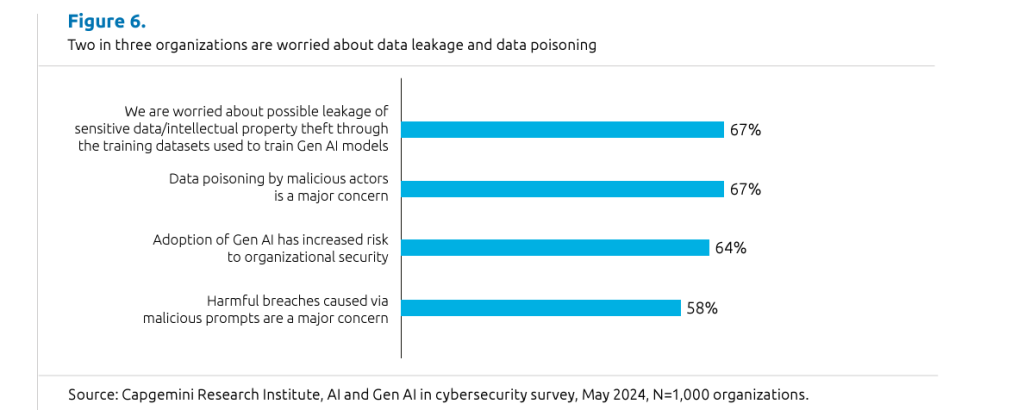

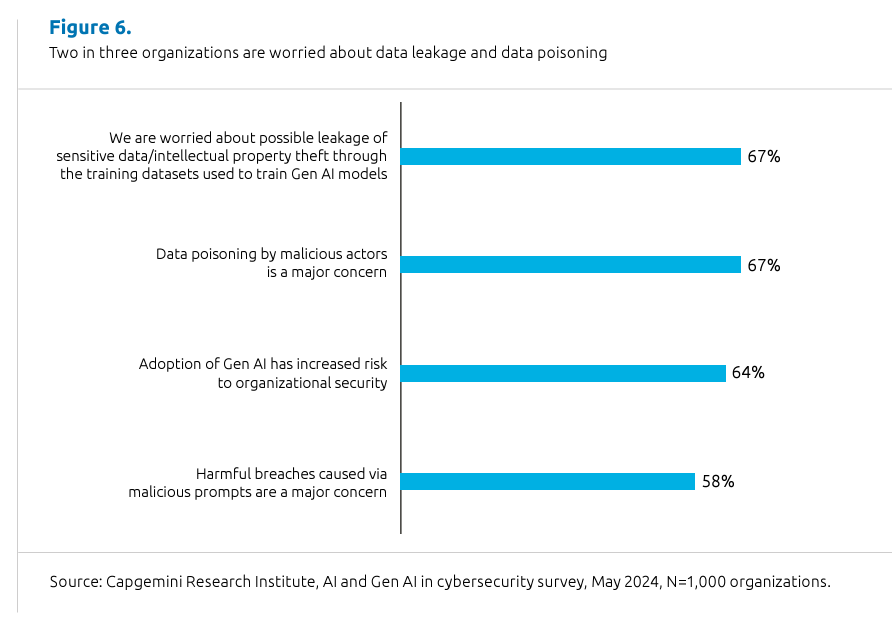

Enfin, 67% des organisations s’inquiètent spécifiquement des risques de contamination et de fuite de données notamment via les jeux d’entraînement des modèles d’IA générative. Cette préoccupation impose de repenser les stratégies de gouvernance de la data et de protection des données sensibles.

La Shadow IA est ainsi pointée du doigt comme une responsable inquiétante de l’augmentation de la surface d’attaque et des fuites de données. Ce terme désigne l’utilisation non autorisée d’applications ou d’outils d’IA par les employés, souvent en dehors du cadre des politiques IT existantes. Par exemple, des collaborateurs peuvent télécharger des solutions génératives pour automatiser certaines tâches, mais en partageant, parfois involontairement, des données sensibles sur des plateformes non sécurisées. Selon le rapport, 39 % des organisations ayant mis en place des restrictions sur l’usage de l’IA constatent tout de même des violations fréquentes de ces règles.

Bien évidemment, face à la complexité croissante des menaces, les organisations ne peuvent ignorer le facteur humain dans leur stratégie de cybersécurité. Le rapport souligne que la formation des équipes internes sur l’utilisation responsable de l’IA et de l’IA générative est un levier crucial pour minimiser les risques. Les employés doivent être sensibilisés aux bonnes pratiques, notamment éviter le partage d’informations sensibles sur des plateformes non autorisées et comprendre les implications des modèles d’IA mal configurés ou biaisés. En outre, l’instauration de politiques claires, couplée à des simulations régulières d’incidents, aiderait à construire une culture organisationnelle où chacun joue un rôle actif dans la réduction des vulnérabilités.

Ce graphique offre une autre vision des risques selon les RSSI qui se montrent très inquiets face aux fuites d’information liées notamment à la Shadow IA mais aussi face au « data poisoning » alors que les IA s’alimentent de données.

Performance opérationnelle vs risques

S’il y a paradoxe, c’est parce que, parallèlement, les résultats opérationnels sont aussi au rendez-vous. Plus de 60% des organisations utilisant l’IA dans leurs SOC constatent une réduction d’au moins 5% des temps de détection des incidents. Pour 40% d’entre elles, le temps de remédiation a également diminué d’au moins 5%. Ces gains d’efficacité expliquent pourquoi deux tiers des organisations font désormais de l’IA une composante centrale de leur stratégie de cybersécurité.

Et pour la plupart des RSSI, l’IA est désormais indispensable pour affronter le flot de cybermenaces. Corence Kop, CISO de Rabobank témoigne ainsi dans le rapport : « sur l’année écoulée, notre banque a fait l’objet de 90 millions d’attaques. Cette tendance ne cesse de s’accentuer, ce qui rend les technologies comme l’IA absolument cruciales. Nous devons faire preuve de plus d’intelligence dans nos stratégies de défense face à cette multiplication des attaques. »

Selon le rapport, les organisations affrontent en moyenne dans le monde 30 tentatives d’intrusion ou incidents de sécurité par jour, avec des moyennes de l’ordre de 50 cyberattaques par jour dans certains secteurs comme la banque. Pas étonnant, dès lors, que les rapporteurs s’inquiètent de la croissance des entreprises ayant connu une brèche de cybersécurité : de 51% en 2021 elles sont désormais 92% en 2023.

Impact budgétaire et adaptation des stratégies

Face à cette dualité entre opportunités et menaces, 58% des organisations prévoient d’augmenter leur budget cybersécurité.

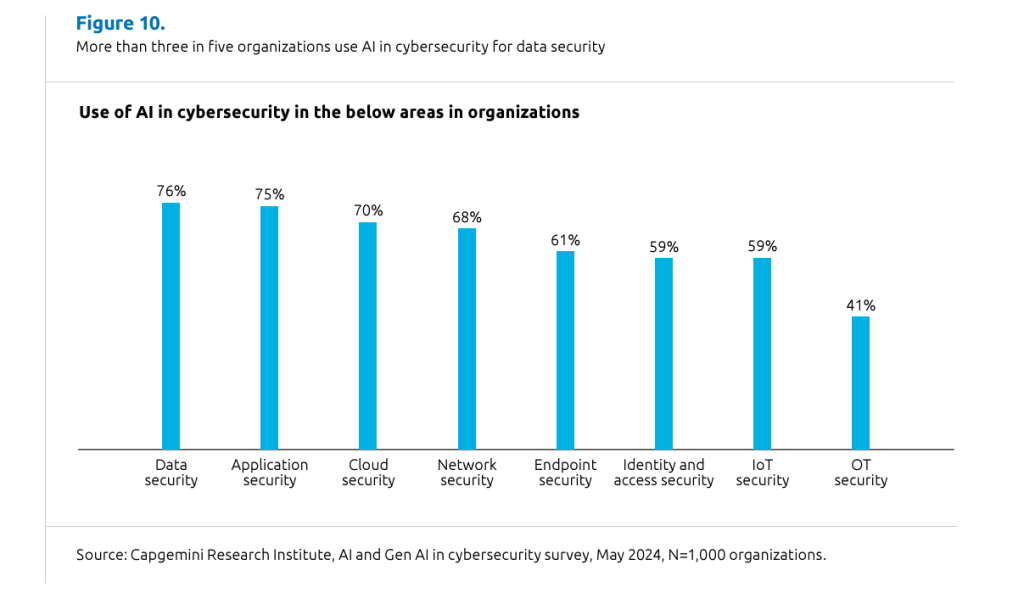

Ainsi, l’adoption de l’IA et de l’IA générative est considérée comme une évolution nécessaire pour les DSI et RSSI. Ces technologies permettent d’automatiser la détection des anomalies, d’améliorer la précision des analyses et d’aider les analystes en cybersécurité à se concentrer sur des tâches à plus forte valeur ajoutée, notamment la stratégie de défense proactive.

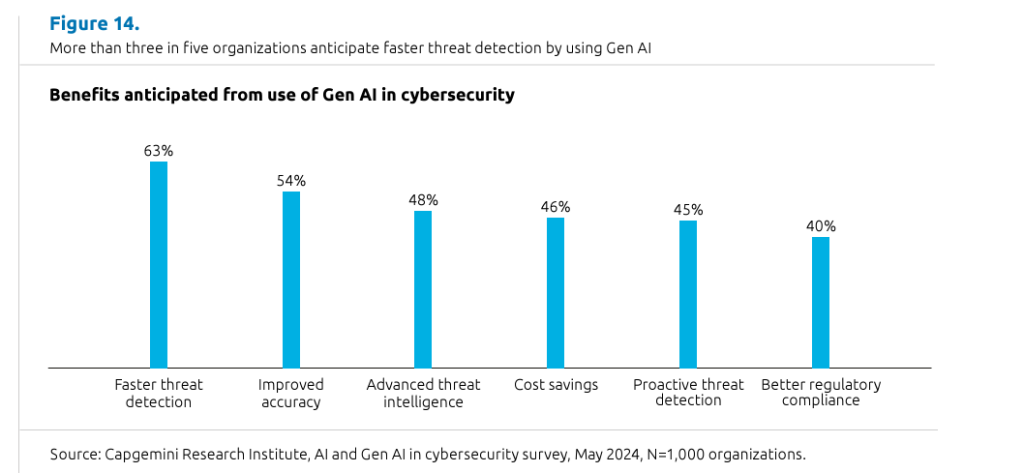

Plus de 61 % des répondants prévoient désormais que l’IA générative renforcera la cybersécurité à long terme, et 62 % s’attendent à ce qu’elle joue un rôle proactif dans la détection des vulnérabilités. Et 58% des organisations pensent que la Gen AI améliorera l’analyse des incidents cyber.

Ces chiffres reflètent une confiance croissante dans l’IA au service des mesures de sécurité préventives. Hélio Cordeiro Mariano, directeur de l’information à la Cooperativa Central Ailos, estime ainsi que « l’interaction et la capacité de la Gen AI à en apprendre davantage sur ce que nous faisons, et à répondre aux questions en fonction des invites, pourrait accélérer l’identification des problèmes dans l’environnement. »

Il n’est pas le seul. L’enquête révèle qu’une large majorité de RSSI estime que la capacité de la Gen AI à anticiper et à neutraliser les cybermenaces sophistiquées renforcera leur résilience organisationnelle face à un paysage de menaces numériques en constante évolution. Frédéric PégazFiornet, responsable de la santé numérique et de la cybersécurité pour la France, la Belgique et le Luxembourg chez Siemens Healthineers, témoigne ainsi dans le rapport : « Nous avons commencé à utiliser la Gen AI pour le diagnostic et d’autres applications. Je suis convaincu que dans les mois ou années à venir, l’IA et l’IA générative progresseront de manière significative. Il existe de nombreuses applications potentielles pour l’IA générative, notamment pour renforcer les mesures proactives contre les attaques. Actuellement, de nombreux directeurs de l’information sont réactifs plutôt que proactifs, manquant de plein engagement avec leurs outils de surveillance pendant les cyberattaques. »

Une ombre vient cependant ternir ce tableau extraordinairement positif : Moins de 50 % des organisations sont convaincues du potentiel de l’IA générative en matière de réduction des coûts. « Les frais liés à l’entraînement des modèles et les coûts opérationnels associés suscitent des inquiétudes légitimes et peuvent constituer un frein significatif à l’adoption de cette technologie » notent les rapporteurs.

Pour les DSI et RSSI, l’enjeu est donc bien d’équilibrer innovation et sécurité en adaptant leurs stratégies aux mutations rapides de l’IA et de l’écosystème numérique. Business as usual en somme…

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :

À LIRE AUSSI :