Data / IA

Mistral AI lance deux nouveaux modèles : Codestral Mamba et Mathstral

Par Laurent Delattre, publié le 17 juillet 2024

La startup phare de l’IA en France, Mistral AI, poursuit ses efforts de recherche aussi bien dans le domaine de l’amélioration des capacités de raisonnement des IA que dans celui de l’efficience des modèles.

Qu’on se le dise, les IA génératives sont encore balbutiantes. Nous n’avons jusqu’ici qu’effleuré leur potentiel. Et plus les chercheurs comprennent le fonctionnement intime des réseaux de neurones, plus ils progressent dans la maîtrise des IA pour à la fois en améliorer les performances, en réduire les consommations de ressource, en augmenter les capacités d’analyse et de raisonnement.

Preuve en est les annonces cette semaine par Mistral AI de nouveaux modèles démontrant les capacités de la jeune pousse française à faire évoluer les technologies Gen AI sur tous ces axes.

Codestral Mamba 7B

Le T de GPT, signifie « Transformer » et désigne le type d’architecture fondamentale qui donne vie à la plupart des LLM (Large Langage Model) avec lesquels on discute depuis la sortie de ChatGPT.

Fin 2023, une équipe de chercheurs de Carnegie Mellon et de l’Université de Princeton a imaginé une toute nouvelle approche, une toute nouvelle architecture de LLM dénommée Mamba.

Mamba se distingue radicalement des architectures traditionnelles comme les Transformers en s’appuyant sur l’utilisation de modèles d’espace d’état structurés (SSM) qui permettent de traiter efficacement de longues séquences de données, alors qu’en la matière les Transformers ont déjà atteint leurs limites. En remplaçant les blocs d’attention complexes des Transformers par un seul bloc SSM cohérent, Mamba parvient à réduire considérablement la complexité de calcul. Dit autrement, Mamba traite les longues séquences plus rapidement avec une complexité de calcul réduite.

Il en résulte à la fois une architecture plus simple mais aussi plus performante grâce à un parallélisme optimisé pour les GPU modernes.

Et c’est justement sur le potentiel de cette nouvelle architecture que les chercheurs de la startup française Mistral AI ont planché ces derniers mois. Et les fruits de leurs recherches commencent à se concrétiser.

L’éditeur vient en effet de dévoiler un nouveau modèle basé sur Mamba : Mistral Codestral Mamba 7B. Pour rappel, il y a quelques semaines, Mistral lançait son premier modèle dédié à la génération de code informatique : Codestral 22B.

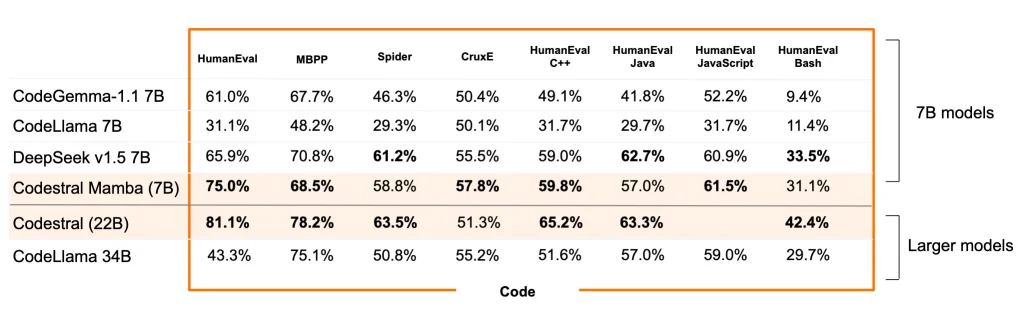

Codestral Mamba 7B en est une variation basée sur une architecture Mamba afin d’obtenir un modèle de génération de code suffisamment performant pour une utilisation en local. Il n’est pas aussi « pertinent » que Codestral 22B mais offre une fenêtre contextuelle de 256.000 tokens et affiche des résultats de qualité supérieure à celle de tous les autres modèles 7B du marché ou de CodeLlama 34B.

Codestral Mamba est publié en open source sous licence Apache 2.0 mais peut être directement testé et évalué sans effort de déploiement depuis « La Plateforme » Mistral et ses API.

Mathstral a la bosse des maths

Outre Codestral Mamba, Mistral AI a également lancé cette semaine un nouveau modèle spécialisé dans la résolution des problèmes mathématiques avancés démontrant les progrès réalisés par ses chercheurs en matière d’implémentation de raisonnements complexes par-dessus des LLMs classiques.

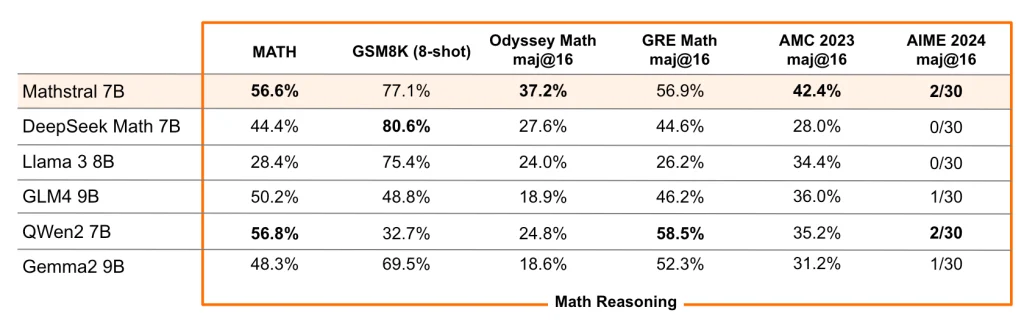

MathΣtral atteint des performances de pointe dans sa catégorie sur divers benchmarks standards du monde scientifique. Le modèle « instruit » atteint 56,6% sur MATH et 63,47% sur MMLU. Mais avec un peu de fine-tuning et d’optimisations sur l’inférence, il peut atteindre des scores de 68,37% sur MATH.

MathΣtral s’appuie sur le modèle LLM le plus populaire de Mistral, Mistral 7B, mais le spécialise sur les sujets STEM (Science, Technologie, Ingénierie et Mathématiques). MathΣtral est ainsi un modèle de 7 milliards de paramètres, conçu spécifiquement pour le raisonnement mathématique et la découverte scientifique. Selon Mistral AI, il illustre l’efficacité des « modèles spécialisés » et le potentiel des nouvelles fonctionnalités de « fine-tuning » mis à disposition des entreprises via « La Plateforme » de Mistral AI.

MathΣtral dispose d’une fenêtre de contexte de 32 000 tokens et est publié en open-source sous licence Apache 2.0.

En suivant des pistes un peu différentes d’OpenAI (ChatGPT) et Anthropic (Claude AI), Mistral AI ne ralentit pas le rythme du côté des innovations et poursuit sa quête d’Intelligences artificielles toujours plus pertinentes et plus utiles au quotidien, mais aussi plus efficientes et moins énergivores. Avec une volonté de proposer la plupart de ses innovations en open-source. Aux DSI maintenant de suivre le rythme et d’imaginer les applications pratiques de ces technologies au sein de leurs entreprises…

À LIRE AUSSI :

À LIRE AUSSI :