Data / IA

NVidia GTC 2025 : ce que les DSI doivent en retenir

Par Laurent Delattre, publié le 24 mars 2025

Avec ses AI Factories, ses modèles à agents, et ses robots dopés à la physique, Nvidia a transformé, à l’occasion de sa conférence GTC 2025, l’IA en moteur industriel planétaire. La firme a dévoilé aux DSI et aux développeurs, un futur qui n’est plus seulement une révolution logicielle mais qui trace dès aujourd’hui les voies d’une mise en production d’une IA future, autonome, distribuée et incarnée.

Qu’on le veuille ou non, et même si les annonces ont paru parfois trop prématurées pour être utiles, la GTC 2025 n’a fait qu’enfoncer le clou sur une réalité incontestable : Nvidia ne domine pas simplement le monde de l’IA d’entreprise, elle en redéfinit constamment les frontières, laissant ses concurrents dans une course perpétuelle à un rattrapage qui doit leur paraître bien impossible.

L’entreprise dirigée par Jensen Huang a déployé une stratégie d’occupation systématique de l’écosystème IA qui s’apparente à un échiquier où chaque case est méticuleusement contrôlée pour s’assurer qu’aucun espace de manœuvre n’est laissé libre à la concurrence. Des processeurs aux clusters de calcul, des infrastructures logicielles aux modèles, des outils de développement aux logiciels, aucun territoire n’est laissé vacant.

« Chaque industrie est ici à la GTC 2025, chaque pays est ici, et chaque entreprise est ici parce que nous sommes devenus une entreprise fondamentale sur laquelle d’autres entreprises sont construites » s’est ainsi enflammé Jensen Huang durant la conférence de presse post-keynote.

Ce qui distingue véritablement Nvidia de ses concurrents n’est pas seulement tant sa supériorité technologique que sa vision stratégique à long terme déjà dessinée depuis plusieurs années. Au point que l’entreprise se permet de dévoiler sa roadmap et ses objectifs de performance IA pour les 3 ans à venir sans craindre d’inspirer ses poursuivants. Cette transparence n’est pas de la témérité, mais la manifestation d’une confiance dans sa capacité à exécuter et à maintenir son avance technologique.

La multiplication des partenariats stratégiques avec des acteurs comme HPE, Dell, Nutanix, Google Cloud, Oracle, Microsoft ou GM renforce encore cette position dominante en créant un écosystème où Nvidia devient chaque jour un peu plus l’infrastructure incontournable de l’IA d’entreprise. Chaque nouvelle alliance est un verrou supplémentaire dans un système où les alternatives deviennent de plus en plus difficiles à envisager.

À la GTC 2025, Jensen Huang a surtout cherché à démontrer à quel point son entreprise a évolué d’un fournisseur de puces à un fabricant d’usines à IA (AI Factories).

Un faiseur d’AI Factories

« Le monde traverse une transition de plateforme, passant des logiciels codés manuellement fonctionnant sur des ordinateurs à usage général aux logiciels d’apprentissage automatique fonctionnant sur des accélérateurs et des GPU » a rappelé en introduction le CEO de NVidia.

Nous assistons à une révolution complète du modèle informatique dans lequel les « AI Factories » jouent un rôle essentiel et transformateur. « Ces usines d’IA ont une et une seule mission : générer ces incroyables tokens que nous reconstituons ensuite en musique, en mots, en vidéos, en recherche, en produits chimiques ou en protéines… Nous les reconstituons en toutes sortes d’informations de différents types » explique ainsi Jensen Huang.

Ces AI Factories reposent sur plusieurs briques à commencer par les puces NVidia et la désormais célèbre et incontournable plateforme NVidia AI Enterprise notamment connue pour sa capacité à simplifier les déploiements d’IA en local comme dans le cloud et pour sa conception NIM qui permet l’exécution des modèles sous forme de micro-services. Mais deux nouvelles briques ont également été anoncées : NVIDIA AI Data Platform et Dynamo AI Factory OS.

NVidia AI Data Platform est une référence d’infrastructure de stockage personnalisable et conçue pour embarquer la plateforme « AI Enterprise » au cœur du stockage. Elle s’appuie sur les technologies de stockage de partenaires certifiés et sur les GPU Blackwell, les DPU BLueField-3 ke réseau Spectrum-X et la plateforme « AI Enterprise » avec ses modèles NIM, sa technologie NeMo Retriever (pour le RAG). DDN, Dell Technologies, Hewlett Packard Enterprise, Hitachi Vantara, IBM, NetApp, Nutanix, Pure Storage, VAST Data et WEKA ont déjà signé des partenariats avec NVidia dans le but de proposer des solutions « AI Data Platform » aisées à déployer.

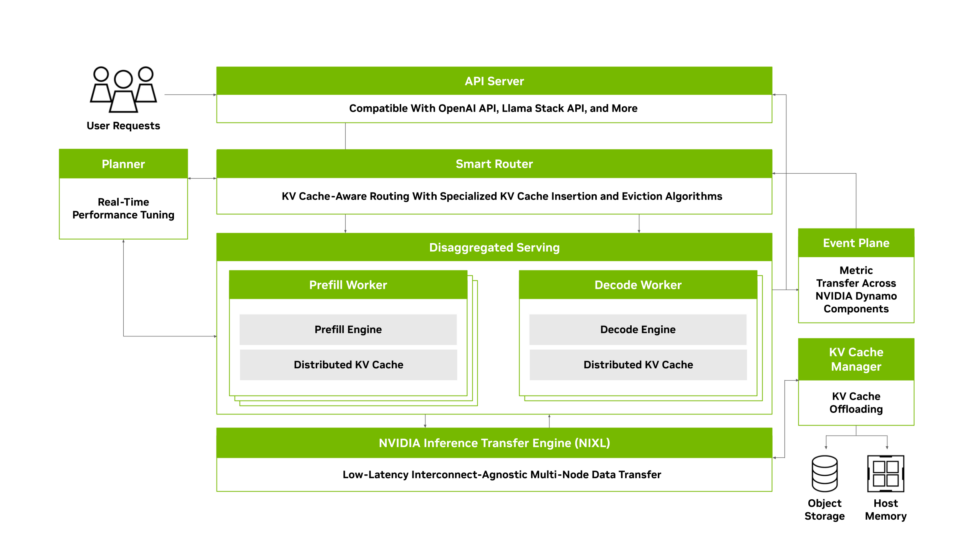

Dynamo AI Factory OS est une autre nouveauté et l’une des couches sur lesquelles reposent « AI Data Platform ». Cette bibliothèque open-source est conçue pour accélérer et étendre l’inférence des modèles d’intelligence artificielle (IA) dans des environnements distribués à grande échelle. Elle est compatible avec des outils open-source tels que PyTorch, SGLang, NVIDIA TensorRT-LLM et vLLM, permettant aux développeurs et chercheurs de déployer efficacement des modèles d’IA dans des environnements distribués. Dynamo combine notamment un « Planificateur GPU » (qui ajuste dynamiquement l’allocation des GPU en fonction de la demande), un « Routeur intelligent » (qui dispatche les requêtes vers les GPU les plus appropriés), un « Gestionnaire de cache KV distribué » (qui décharge les caches moins fréquemment utilisés vers des solutions de mémoire et de stockage plus économiques pour augmenter le débit du système), un mécanisme de transfert d’inférence NIXL.

« Dynamo, c’est essentiellement le système d’exploitation d’une usine d’IA. Par le passé, notre système d’exploitation était quelque chose comme VMware… mais demain, l’avenir de l’informatique n’est plus l’application c’est agent. Et le système d’exploitation n’est plus quelque chose comme VMware. C’est quelque chose comme Dynamo » explique Jensen Huang. Dynamo OS est conçu pour coordonner l’ensemble des tâches d’un centre de données dédié à l’IA. Il gère la complexité des inférences, du batching, de la parallélisation (tensor, pipeline, expert), et de la gestion de la mémoire (KV cache) sur un grand nombre de GPU interconnectés.

En pratique, Dynamo succède à NVIDIA Triton Inference Server et introduit une architecture modulaire plus adaptée aux modèles d’IA générative et de raisonnement d’aujourd’hui.

Au passage, on retiendra également que la plateforme « AI Enterprise » s’enrichit de nouveaux modèles à raisonnement avec la famille de modèles « Llama Nemotron », dotés de capacités de raisonnement et bien adaptés à l’ère agentique, disponibles sous forme de microservices NIM en tailles Nano, Super et Ultra. Au passage, NVidia a présenté sa référence « Blueprint AI-Q » pour aider les entreprises à développer des agents IA et des systèmes pour les orchestrer, qui repose notamment sur les modèles Nemotron, sur NeMo Retreiver et sur l’AgentIQ Toolkit (bibliothèque open-source pour connecter et optimiser des équipes d’Agents IA).

Pour les DSI, les solutions comme la NVIDIA AI Data Platform et Dynamo illustrent la fusion croissante entre l’infrastructure de données et les capacités d’IA. Les équipes vont devoir s’adapter à cette transformation et être capables de maîtriser cette convergence plutôt que de maintenir des silos techniques distincts.

Une roadmap de GPU et de CPU

Et pour suivre l’évolution rapide des besoins, des usages et des technologies IA, NVidia s’engage à mainteneur un rythme annuel d’innovations qui va imposer aussi aux DSI d’adopter une approche plus agile et évolutive dans leur planification technologique. Pour les y aider, la firme de Jensen Huang a dévoilé sa feuille de route jusqu’en 2028 afin de permettre aux DSI d’aligner leurs investissements d’infrastructure sur cette projection à moyen terme et de comprendre la pérennité de leurs choix technologiques.

Alors que les GPU Blackwell commencent tout juste à être livrés, l’entreprise annonce déjà le Blackwell Ultra B300 pour mi-2025, offrant une augmentation de 50% des performances en FP4 (30 PétaFLOPS) grâce à l’optimisation des unités de calcul pour les modèles d’IA à précision réduite.

Cette nouvelle génération se déclinera en plusieurs configurations impressionnantes à commencer par une plateforme modulaire HGX B300 NVL16 avec 16 GPU et surtout le système rack GB300 NVL72 intégrant 72 GPU et 36 CPU.

Le summum sera atteint avec le DGX SuperPOD Blackwell Ultra, combinant 8 racks NVL72 pour une puissance totale de 11,5 ExaFLOPS.

L’avenir s’annonce encore plus prometteur avec l’architecture CPU Vera (en remplacement des réputés CPU « Grace ») prévue pour 2026, qui marque le passage aux cœurs Arm personnalisés (88 cœurs par socket) s’éloignant des designs officiels Neorverse d’ARM, puis les GPU Rubin fin 2026 (50 pétaFLOPS en FP4), suivis du Rubin Ultra en 2027 atteignant 100 pétaFLOPS avec 1 To de mémoire (et qui seront combinés en un rack NVL567 avec 576 GPU par rack). Ils seront suivis de la génération Feynman.

Les robots arrivent, et les DSI doivent anticiper

Enfin, Jensen Huang a invité les entreprises à se projeter dès à présent dans la prochaine phase de l’IA, celle qui viendra après l’ère agentique (l’IA qui interagit avec notre univers numérique) : celle de « l’IA Physique » autrement dit celle qui évolue et interagit avec notre monde physique, autrement dit l’ère des robots intelligents pour répondre aux défis physiques et de pénurie de la main-d’œuvre humaine! Nvidia croit en l’avènement prochain de la robotique généraliste et le développement de robots humanoïdes et autres robots polyvalents, capables d’effectuer un plus large éventail de tâches dans divers environnements et en autonomie.

Et Nvidia poursuit plusieurs pistes. À commencer par la fusion de la simulation et de l’apprentissage. La firme mise sur ses outils comme Omniverse et Isaac Lab pour générer de vastes volumes de données synthétiques, permettant d’entraîner des politiques robotiques. Ces environnements virtuels, renforcés par Cosmos (une plateforme de modèles fondation conçus pour l’IA physique, des véhicules autonomes aux robots), permettent de simuler des scénarios variés et de tester la robustesse des comportements des robots en situation réelle.

NVidia adopte déjà une vision industrielle avec une volonté de démocratiser et perfectionner les technologies robotiques de l’automatisation industrielle aux robots autonomes, en passant par les robotaxis et autres applications. De quoi révolutionner les chaînes de production, la logistique et bien des domaines de la santé aux loisirs en passant par la construction…

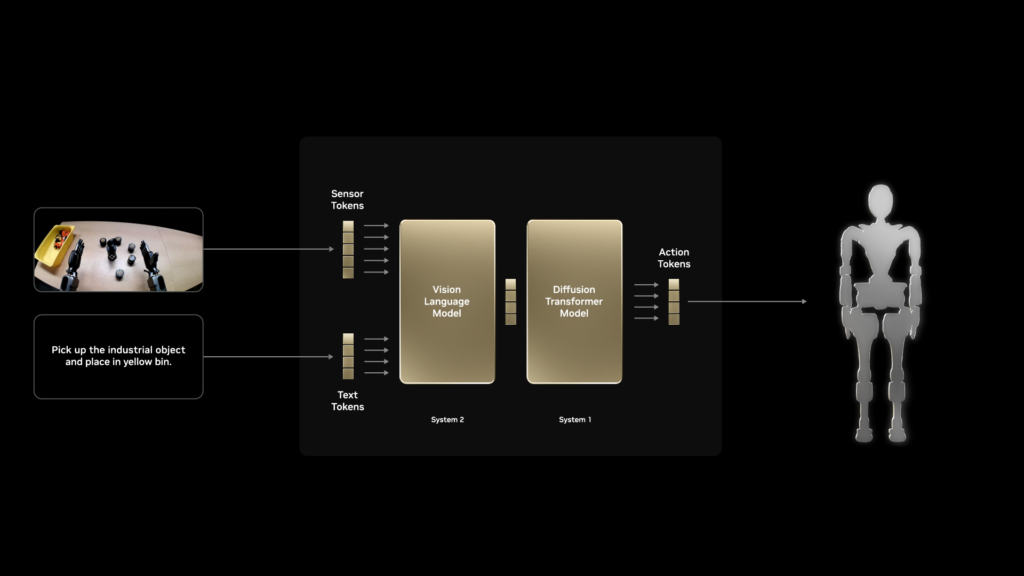

Autre piste active de R&D, celle des modèles fondation pour robots humanoïdes. NVidia a ainsi dévoilé son modèle fondation « GR00T N1 » doté d’une architecture à double système : Un système « lent » (pour la perception et le raisonnement permettant d’analyser l’environnement et de planifier des actions) et un système « rapide » (qui traduit ces plans en actions précises et continues).

Cette approche favorise la manipulation d’objets et l’exécution de séquences d’actions complexes dans des environnements réels.

Et histoire de ne pas se montrer trop théorique et mettre en pratique sa R&D en la matière, Nvidia a présenté « Blue », un robot de recherche alimenté par l’IA, inspiré de Star Wars et fonctionnant à l’aide du moteur physique Newton. Ce moteur est conçu pour des simulations très fines (rigide et souple, avec retour tactile), essentiel pour entraîner les robots à interagir de manière fiable avec le monde physique.

Blue peut répondre à des commandes vocales et interagir en temps réel, démontrant les progrès réalisés dans le domaine de l’IA incarnée. Le robot contient deux ordinateurs Nvidia et a été développé en collaboration avec Disney Research et Google DeepMind.

Dans un même ordre d’idées, NVidia a également levé le voile sur Jetson Thor, une plateforme de calcul spécialisée pour la robotique humanoïde. Jetson Thor est doté d’une architecture Blackwell de nouvelle génération avec des fonctions de sécurité intégrées et un calcul haute performance pour des interactions sûres et efficaces dans des environnements réels. Jetson Thor est utilisé notamment comme plateforme de développement de GR00T.

Au final, la dynamique générale de Nvidia, telle qu’illustrée lors de la GTC 2025, témoigne d’une volonté farouche de redéfinir en continu les frontières de l’IA. En passant d’un simple fournisseur de puces à un véritable fabricant d’AI Factories, Nvidia orchestre l’ensemble de l’écosystème, de l’infrastructure de stockage et des systèmes d’exploitation spécialisés (comme Dynamo OS) jusqu’aux modèles d’IA générative et aux solutions robotiques avancées. Cette stratégie, solidement ancrée dans une roadmap ambitieuse et transparente jusqu’en 2028, positionne l’entreprise non seulement comme leader incontesté de l’IA d’entreprise, mais également comme le catalyseur d’une révolution numérique globale. Une révolution IA que rien ne semble pouvoir arrêter et qui entrevoit déjà un monde où l’IA ne se contentera plus d’interagir avec le monde numérique, mais prendra aussi vie dans le monde physique grâce à des robots intelligents et polyvalents. Apparemment, NVidia est déjà près pour ce futur proche. Pas sûr que nos entreprises, nos politiques et nos civilisations puissent l’être à temps…

À LIRE AUSSI :

À LIRE AUSSI :