Secu

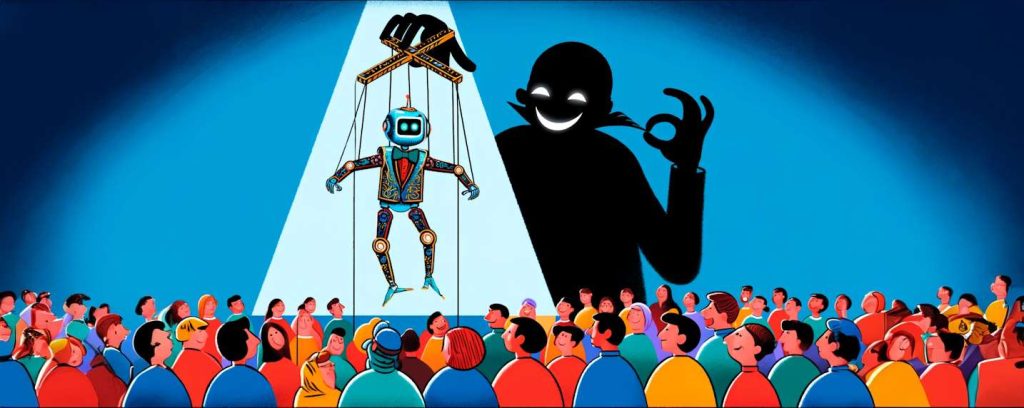

OpenAI décrypte comment ChatGPT est utilisé pour des opérations d’influence d’opinion

Par Laurent Delattre, publié le 31 mai 2024

Avant de remettre en question l’éthique de l’IA, il serait bon de remettre en question l’éthique de ceux qui l’utilisent. En cette année exceptionnelle où près de 4,1 milliards de personnes dans le monde seront amenées à voter dans des élections majeures, OpenAI met à jour plusieurs cybercampagnes d’influence d’opinions utilisant ses IA comme outil.

De tout temps, des acteurs malintentionnés ont cherché à manipuler l’opinion publique ou influencer des résultats politiques. Mais avec les réseaux sociaux et leur viralité, ces manipulations ont pris une tout autre dimension mettant en péril l’idée même de la démocratie. Une seule barrière freinait encore quelque peu les capacités d’action de ces acteurs : les barrières de la langue. Mais ChatGPT et les IA génératives ont fait exploser ces dernières barrières tout en rendant les efforts malveillants plus prolifiques, plus efficaces, plus dangereux.

Une équipe d’OpenAI vient de publier un rapport déchiffrant plusieurs campagnes d’influence réalisées en utilisant ses modèles d’IA pour générer du contenu trompeur ou manipulateur.

Utilisation de ChatGPT dans les Opérations d’Influence

Ce n’est pas la première fois que la startup à l’origine de la vague des IA génératives s’intéresse aux usages malveillants ou pernicieux de ChatGPT et de ses autres modèles génératifs. Jusqu’ici cependant, les enquêtes portaient surtout sur l’utilisation de ChatGPT dans les campagnes de Phishing et sur l’utilisation des capacités de génération de code pour échapper aux détections ou améliorer l’efficacité des malwares.

Mais c’est le premier rapport à s’intéresser spécifiquement aux campagnes d’influence d’opinions en cette exceptionnelle année d’élection pour les Américains (élection présidentielle), les Européens (élections du parlement de l’UE), en Inde (élection générale pour la Lok Sabha), au Venezuela (élection présidentielle), etc.

Parmi les opérations notables identifiées dans le rapport, on trouve des acteurs attachés de près ou de loin aux services gouvernementaux de la Russie, de la Chine, de l’Iran ou encore à une entreprise commerciale israélienne. Ces campagnes ont bien évidemment des objectifs distincts, mais partagent des méthodes communes d’utilisation de l’IA pour générer et diffuser du contenu en ligne.

Plusieurs campagnes sont ainsi passées au crible dans ce rapport. On retiendra notamment :

Bad Grammar : Une opération originaire de Russie, utilisant des modèles d’IA pour créer des commentaires en anglais et en russe sur Telegram, ciblant des audiences aux États-Unis, en Ukraine, en Moldavie et dans les États baltes.

Doppelganger : Un acteur persistant russe publiant du contenu anti-Ukraine sur Internet, utilisant des modèles d’IA pour générer des commentaires et des articles dans plusieurs langues européennes dont le Français.

Spamouflage : Provenant d’un groupe chinois publiant du contenu pro-Chine et critiquant ses détracteurs, utilisant des modèles d’IA pour générer des articles et des commentaires en chinois, anglais, japonais et coréen.

International Union of Virtual Media (IUVM) : Cet acteur iranien génère du contenu pro-Iran, anti-Israël et anti-États-Unis, utilisant des modèles d’IA pour produire des articles, des titres et des tags de sites web.

Zero Zeno : Cette campagne est menée par l’entreprise israélienne STOIC réputée pour créer du contenu sur divers sujets politiques, notamment le conflit de Gaza et les élections indiennes, en utilisant des modèles d’IA pour générer des commentaires et des articles.

À LIRE AUSSI :

Méthodes et tactiques employées

Contrairement à ce que l’on pourrait penser, les campagnes mises ici en évidence sont loin d’être entièrement automatisées à l’IA. En réalité les modèles IA sont davantage utilisés en complément d’actions manuelles humaines. Et les contenus générés sont quasiment systématiquement retouchés manuellement pour encore gagner en réalisme.

Néanmoins, l’utilisation de l’IA change la donne en permettant de réaliser des contenus dans de multiples langues étrangères, mais surtout de se montrer plus productif et viral : l’objectif est d’utiliser l’IA pour produire suffisamment de quantité de contenus afin de noyer « les voix authentiques » et créer de fausses impressions d’engagement.

OpenAI constate néanmoins que la plupart du temps, l’impact de telles campagnes s’est révélé relativement limité même si certaines ont pu avoir une audience au sein de communautés bien identifiées (comme les complotistes par exemple).

Parmi les autres tactiques mises en avant dans le rapport, on retiendra la création de faux profils sur les réseaux sociaux pour simuler l’engagement et l’utilisation de commentaires générés par l’IA pour répondre à leurs propres publications. D’autres opérations ont manifestement utilisé massivement l’IA pour gagner en productivité dans des tâches telles que la traduction ou l’analyse de sentiments sur les réseaux sociaux.

À LIRE AUSSI :

La balle est aussi dans le camp d’OpenAI

La startup ne se contente pas d’observer. Son rapport est aussi un moyen pour elle de dévoiler comment OpenAI lutte contre ces usages contraires à l’éthique et à sa licence d’utilisation.

L’éditeur explique notamment que ses modèles embarquent des systèmes de sécurité pour mettre des obstacles et battons dans les roues des acteurs malveillants. Typiquement, les modèles refusent de générer des textes ou des images lorsqu’ils détectent un risque potentiel ou une volonté de nuire.

L’éditeur explique également avoir développé des modèles IA propriétaires pour améliorer l’analyse et la détection des campagnes d’influence qui exploitent ses IA publiques. Selon OpenAI, ces IA permettent de repérer en quelques heures ou jours des débuts de campagne, là où il fallait avant des semaines ou des mois avant de repérer et réagir.

OpenAI explique aussi que si l’IA peut compléter et améliorer les outils utilisés par les cyberattaquants, elle ne les change pas eux-mêmes. Ainsi, les enquêtes menées par la startup ont montré que les faiblesses et erreurs humaines d’avant l’IA n’avaient pas disparu avec l’IA. Typiquement, à trop vouloir automatisé par l’IA certains profils ont publié sur les réseaux sociaux non pas un message d’influence, mais le message d’erreur généré par le modèle d’OpenAI utilisé. Parfait pour griller définitivement un profil !

En outre, OpenAI insiste bien évidemment sur l’importance d’une collaboration avec les partenaires industriels et les acteurs de la cyberdéfense. La startup affirme régulièrement partager ses découvertes et ses indicateurs de menace avec ses pairs.

Enfin, OpenAI rappelle que pour avoir la moindre influence, les messages générés par l’IA doivent être distribués à un large public avec en sous-entendu que le contrôle de la cette diffusion reste du ressort des plateformes des réseaux sociaux et de leurs IA qui contrôlent l’affichage des murs de messages.

À LIRE AUSSI :

À LIRE AUSSI :