Data / IA

Yann LeCun : «L’AGI dans quelques années ? C’est simplement faux !»

Par Thierry Derouet, publié le 10 février 2025

Il y a dix ans, un petit groupe de chercheurs emmenés par Yann LeCun s’installait dans la capitale française pour fonder FAIR (Fundamental AI Research) sous l’égide de Meta (ex-Facebook). Depuis, ce laboratoire a semé des graines qui ont germé dans l’ensemble de l’écosystème européen : cadres open source, viviers de doctorants, innovations en robotique ou en traduction multilingue.

Il y a dix ans, l’idée d’un grand groupe américain ouvrant un laboratoire de recherche fondamentale en intelligence artificielle à Paris semblait audacieuse au possible. Aujourd’hui, Yann LeCun, qui a contribué à sa fondation, avoue : « L’impact de FAIR Paris ne peut pas être compris… ou plutôt, il est gigantesque ». Il sourit, amusé. À l’époque, personne ne soupçonnait que ce centre deviendrait un carrefour majeur pour la communauté IA ni que ses recherches sur les réseaux de neurones façonneraient l’écosystème européen.

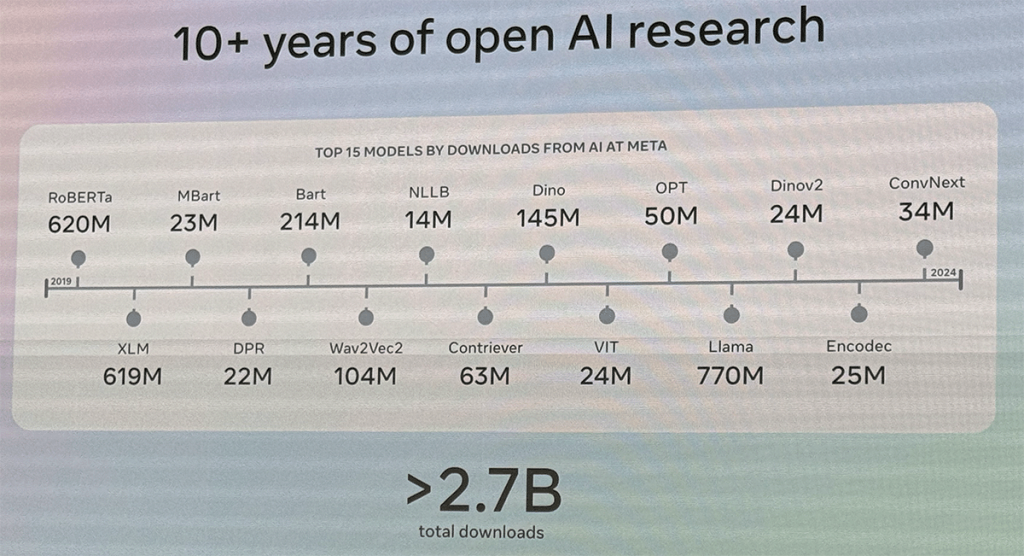

Le principal fait d’armes du laboratoire s’appelle PyTorch. Conçu dans ces murs et rapidement rendu open source, ce framework de deep learning a été adopté par la plupart des secteurs. « Tout le monde l’utilise, sauf Google, qui a ses propres outils », rappelle LeCun. OpenAI, Microsoft, NVIDIA, Amazon : tous s’appuient sur cette plate-forme pour faire tourner leurs modèles de reconnaissance d’images, de génération textuelle ou d’analyse vidéo.

Ce souffle d’ouverture a inspiré d’autres initiatives, comme LLaMA, un large language model désormais décliné par des armées de développeurs à travers le monde. Pour LeCun, il est évident que cette culture de l’open source est dans l’ADN de Meta. Il insiste sur le fait que l’ouverture n’est pas qu’une façade : dès le premier jour, FAIR a accueilli un flux de doctorants et de postdoctorants, formant un véritable vivier de talents en IA. « Il y a dix ans, beaucoup de jeunes n’avaient d’autre choix que de partir à l’étranger ; aujourd’hui, ils peuvent rester ici, se spécialiser, puis rejoindre des start-up locales ou même fonder la leur. »

L’essor du laboratoire ne se limite pas à la sphère francilienne : Meta a progressivement étoffé la structure en Europe, passant des partenariats avec divers instituts, ce qui a contribué à établir Paris comme l’un des pôles internationaux de recherche en intelligence artificielle.

De la robotique aux neurosciences

Si la spécialité historique de FAIR demeure le traitement du langage et l’open source, son agenda actuel va bien au-delà. Des projets de robotique sont en cours, afin de doter les machines d’une capacité de planification et d’action plus autonome. Apprendre à un robot à saisir un objet ou à choisir une séquence d’actions pour naviguer dans un environnement incertain nécessite un autre type d’intelligence que la prédiction brute de mots. LeCun insiste sur ce point : « Un chatbot peut passer un examen de droit avec brio, mais il ne peut pas comprendre l’espace physique comme le fait un chat, celui avec des moustaches et des pattes, qui, lui, arrive à sauter d’une chaise à l’autre et à se faufiler dans les endroits qui lui plaisent, sans qu’on lui ait jamais montré comment faire. » Cette irruption dans le réel soulève une difficulté nouvelle : la vidéo et la robotique imposent de gérer un foisonnement de détails impossibles à prédire exactement. « Il ne s’agit plus de générer la suite la plus probable, comme dans le langage, mais de construire une représentation abstraite du monde, qui sache ignorer les éléments imprévisibles et conserver la structure utile. » Les équipes de FAIR travaillent sur cette architecture, avec l’objectif de rendre la machine plus agile dans des contextes changeants.

Une autre thématique en vue touche à la jonction entre l’IA et le cerveau humain, via des dispositifs non invasifs. Les chercheurs cherchent à décrypter certains signaux neuronaux et envisagent que cette avancée puisse, à terme, offrir un moyen de communication aux personnes atteintes de handicaps lourds. Les partenariats conclus avec des centres médicaux et des institutions spécialisées illustrent la volonté de Meta d’inscrire cette recherche dans un cadre rigoureux, tout en gardant l’œil rivé sur les débouchés pratiques.

FAIR poursuit également son long engagement sur la traduction et la préservation de langues en voie de disparition*, un sujet cher à Meta, dont les plates-formes mondiales brassent plus de deux milliards d’individus. Les modèles de langue massive, comme LLaMA, s’avèrent particulièrement utiles pour couvrir des idiomes pauvres en ressources numériques. Le laboratoire s’efforce de collaborer avec des gouvernements, des associations et l’UNESCO pour enrichir les jeux de données, tout en aidant à construire des interfaces multilingues plus accessibles.

AGI, quand la promesse s’éloigne

Le débat sur l’intelligence artificielle générale (AGI) traverse de part en part la sphère de l’IA. Certains prétendent que les récents modèles de langage, dopés aux calculs, touchent déjà à la superintelligence. D’autres, comme Elon Musk, annoncent depuis plusieurs années l’arrivée de « RoboTaxis » conduits par l’IA, sans que la promesse se concrétise. Yann LeCun reçoit ces allégations avec un scepticisme teinté d’amusement. Il rappelle qu’on annonçait déjà, dans les années 1950 ou 1980, l’avènement d’un programme générique capable de tout résoudre. Il ajoute que l’exploit de maîtriser un jeu de Go ou de résoudre des exercices de mathématiques de haut niveau n’implique pas la compréhension profonde du monde réel. « La planification et l’anticipation dans un jeu de plateau se fondent sur un espace d’états précis ; la vraie vie est, elle, truffée de hasards et d’incertitudes. »

Le projet AMI, c’est de construire de nouvelles architectures d’intelligence humaine pour que les systèmes puissent raisonner, planifier, comprendre le monde physique, avoir une mémoire persistante et apprendre à accomplir de nouvelles tâches sans avoir à être entraînés pour cela. »

Yann LeCun

META

Son propre horizon se nomme « AMI », Advanced Machine Intelligence, un terme qui cache un chantier technique bien plus large que la prédiction textuelle. Il s’agit de construire des modèles capables de manipuler des connaissances abstraites, sans tenter de reproduire chaque détail qui, de toute façon, serait incontrôlable. Il explique qu’un enfant de quelques années comprend très tôt que les objets tombent ou qu’une boule qui roule finit par ralentir, alors même qu’il n’a pas encore acquis la parole. Les animaux, eux aussi, développent des stratégies de survie sans s’échanger le moindre mot. Penser que le langage à lui seul pourrait conduire à l’AGI lui paraît illusoire.

Lui-même reconnaît que l’assemblage de toutes ces briques prendra du temps. Il mentionne la nécessité d’explorer de nouvelles approches architecturales, loin de la simple génération de tokens, pour modéliser l’espace, la temporalité, la causalité. Interrogé sur la date à laquelle pourrait émerger une intelligence de niveau humain, il se contente de dire que cela prendra probablement plusieurs années, voire plus d’une décennie. Il insiste néanmoins sur le fait que la recherche avance à pas de géant et que les progrès des dix dernières années laissent espérer d’autres percées dans la décennie à venir.

Aux portes de l’Advanced Machine Intelligence

Le dixième anniversaire de FAIR Paris sert aussi de passerelle pour réfléchir à la suite de l’aventure. Le groupe Meta a, depuis peu, mis sur pied une division entière, Gen AI, qui mobilise des milliers de personnes autour de la création d’applications concrètes dans Facebook, Instagram ou WhatsApp. La voie semble tracée pour que les travaux de recherche trouvent un prolongement industriel, notamment en modération de contenu, en recommandation ou en développement de nouveaux services, du type métavers ou réalité augmentée.

Yann LeCun demeure néanmoins convaincu que l’open source reste le moyen le plus rapide de parvenir à des découvertes majeures, là où le secret ou la rétention d’informations freinent l’élan collectif. Il rappelle la réussite de PyTorch et LLaMA pour illustrer cette philosophie. Dans la même veine, il explique que les chercheurs qui passent par FAIR contribuent, en repartant, à animer le tissu des start-up et des laboratoires universitaires de l’Hexagone et d’ailleurs.

Au sortir de ces célébrations, l’on retient que FAIR a réconcilié, pour ainsi dire, la recherche industrielle et la quête de la connaissance. Beaucoup de doctorants et d’ingénieurs, formés sous le signe de l’open source, ont essaimé dans des entreprises technologiques européennes, participant à une sorte de pollinisation croisée. Les plus jeunes posent un regard candide sur la question de l’AGI, comme si elle était déjà à portée de main, tandis que ceux qui ont assisté aux étapes successives depuis les années 1980 cultivent une prudence héritée des précédentes « bulles IA ».

« Nous n’avons pas de robots domestiques capables d’agir avec la même souplesse qu’un chat, et ce n’est pas pour tout de suite », reconnaît LeCun avec un éclat de rire. Mais il ajoute que ce grand défi, qui consiste à modéliser la réalité, à planifier dans un environnement physique, à stocker une mémoire persistante et à raisonner en dehors de la simple sphère linguistique, constitue la prochaine frontière. Il voit déjà se dessiner une IA qui aurait assimilé la leçon essentielle du développement animal : apprendre à naviguer dans l’imprévu. Après dix ans, FAIR Paris entre ainsi dans une nouvelle ère, celle où la machine pourrait finir par comprendre le monde presque autant qu’elle en génère des phrases. Loin des annonces précipitées, la patience semble de rigueur, car, pour Yann LeCun, il s’agit surtout de « grignoter le mystère, une brique après l’autre ».

* Savez-vous dire « j’aime » en Inuit ? Sur Facebook, c’est « Piugijara ». Meta a lancé un outil de traduction IA capable de couvrir 200 langues, bien au-delà des 133 langues de Google Translate. Cet outil comprend notamment l’inuktitut, selon le dialecte du sud de l’île de Baffin, avec « Uqausiksat » pour « commenter » et « Saqqitikkannirli » pour « partager ». Cette initiative vise à connecter des communautés isolées par des langues à faible ressource numérique et à soutenir l’expansion mondiale de Meta, en alimentant notamment son projet de métavers.

Les avancées de FAIR et les chiffres clés

• 10 ans de présence à Paris depuis la création du laboratoire FAIR, sous l’impulsion de Yann LeCun.

• FICE (Facebook AI Similarity Search) : premier produit à fort impact, utilisé en interne chez Meta et par des groupes de recherche externes pour la récupération d’informations et l’indexation.

• PyTorch : framework de deep learning né au sein de FAIR, aujourd’hui adopté par la quasi-totalité de la communauté IA (OpenAI, Microsoft, NVIDIA, Amazon, etc.), hormis Google qui dispose de ses propres outils.

• LLaMA : modèle de langage de nouvelle génération, open source, ayant ouvert la voie à de multiples innovations IA.

• Gen AI : l’une des cinq grandes divisions de Meta aux côtés de WhatsApp, Messenger, Facebook et Instagram, forte de plusieurs milliers d’employés.

• 45 doctorants environ présents en continu dans l’équipe, travaillant sur trois ans de thèse (standard européen) ; chaque année, une douzaine de PhD décrochent leur diplôme et rejoignent ensuite l’industrie locale, les startups ou la recherche.

• Programme Brain&AI : initiative de recherche visant à utiliser des capteurs non-invasifs pour mieux comprendre et décoder l’activité cérébrale, notamment au service des personnes handicapées.

• Traduction multilingue : travaux sur “No Language Left Behind” et “Seamless” pour promouvoir les langues peu dotées, en partenariat avec des gouvernements (Nunavut, Canada) et l’UNESCO.

• AMI (Advanced Machine Intelligence) : objectif de long terme visant à développer des architectures capables de raisonner dans le monde réel, de planifier et d’apprendre sans supervision, au-delà des performances actuelles des grands modèles de langage.

À LIRE AUSSI :